Ein LLM ist wie eine Autocomplete-Funktion auf Steroiden. Es ist darauf trainiert, das statistisch wahrscheinlichste nächste Wort in einem Satz vorherzusagen und baut so Wort für Wort ganze Texte auf.

"Large" ("groß") bezieht sich auf die riesige Größe. LLMs bestehen aus neuronalen Netzen mit Milliarden von Parametern und werden mit gigantischen Datenmengen (einem großen Teil des Internets) trainiert.

Ein LLM ist ein Mustererkenner, kein Denker. Es hat kein echtes Wissen oder Bewusstsein. Es ahmt menschliche Sprache brillant nach, kann aber auch Fakten erfinden (halluzinieren), weil es nur auf Wahrscheinlichkeiten basiert.

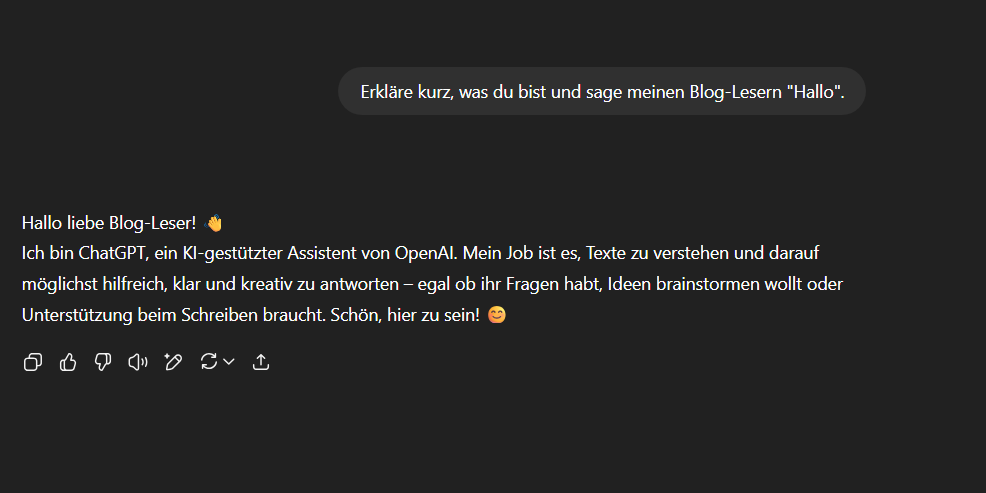

Hast Du jemals ChatGPT eine komplexe Frage gestellt und warst verblüfft von der eloquenten, detaillierten und menschenähnlichen Antwort? Es fühlt sich oft an wie pure Magie. 🪄 Man fragt sich unweigerlich: Wie kann eine Maschine so kreativ und intelligent sein?

Willkommen in der Welt der Large Language Models (LLMs). Das ist der technische Begriff für den Motor, der ChatGPT und ähnliche KIs antreibt. In diesem Artikel entzaubern wir die Magie und zeigen, dass ein LLM im Grunde eine extrem fortschrittliche Version der Autocomplete-Funktion ist.

Die Grundlage: Autocomplete auf Steroiden

Du kennst das von Deiner Handy-Tastatur: Du tippst "Ich komme heute Abend..." und Dein Handy schlägt vor "...später". Es analysiert die letzten paar Wörter und schlägt das statistisch wahrscheinlichste nächste Wort vor. Simpel, aber nützlich.

Jetzt stell Dir eine Autocomplete-Funktion vor, die nicht nur die letzten drei Wörter analysiert, sondern den gesamten Text, den Du bisher geschrieben hast, den gesamten Kontext des Gesprächs und darüber hinaus das Wissen aus Millionen von Büchern und Webseiten.

Und anstatt nur ein Wort vorzuschlagen, schlägt sie das wahrscheinlichste Wort vor, dann basierend auf diesem neuen Wort das nächste, dann das nächste und so weiter – bis ein ganzer, zusammenhängender Absatz entsteht.

Genau das ist, in seiner einfachsten Form, ein Large Language Model. Es ist ein Meister der Vorhersage, ein ultimativer Mustererkenner für Sprache.

Die drei Säulen: Was "Large Language Model" wirklich bedeutet

Um das Konzept vollständig zu verstehen, zerlegen wir den Namen in seine drei Bestandteile:

1. Large (Groß) 🧠

"Groß" ist hier eine Untertreibung. Wir sprechen von einer unvorstellbaren Dimension in zwei Bereichen:

- Größe des Modells: Ein LLM besteht aus einem gigantischen neuronalen Netz mit Milliarden von Parametern (den kleinen "Stellschrauben", die wir im letzten Artikel besprochen haben). Diese schiere Anzahl an Verbindungen erlaubt es ihm, extrem feine und komplexe Nuancen in der Sprache zu lernen.

- Größe der Daten: Diese Modelle werden mit einem riesigen Teil des Internets und digitalen Büchern trainiert. Wir reden hier nicht von einer Bibliothek, sondern von dem Wissen von hunderten Millionen von Webseiten. Es ist, als hätte man das Modell gezwungen, fast alles zu "lesen", was die Menschheit je digital geschrieben hat.

2. Language (Sprache) 🗣️

Das ist die Spezialisierung des Modells. Ein LLM ist darauf trainiert, menschliche Sprache zu verarbeiten. Es tut dies, indem es Wörter in Zahlen umwandelt. Jedes Wort bekommt eine Art numerischen Fingerabdruck (einen "Vektor"), der seine Bedeutung und seinen Kontext im Sprachgebrauch repräsentiert.

Dadurch lernt das Modell die Beziehung zwischen Wörtern. Es "weiß" zum Beispiel, dass die Wörter "König" und "Königin" eine ähnliche Beziehung zueinander haben wie "Mann" und "Frau". Es lernt Grammatik, Stil, Fakten und sogar Argumentationsstrukturen, indem es diese numerischen Muster analysiert.

3. Model (Modell) 🤖

Wie wir bereits wissen, ist ein "Modell" das fertige Produkt des Trainingsprozesses. Es ist eine trainierte, eingefrorene "Momentaufnahme" des neuronalen Netzes. Es lernt nicht mehr aktiv dazu, sondern wendet sein riesiges, antrainiertes Wissen an, um seine eine Aufgabe zu erfüllen: das nächste Wort vorherzusagen.

Der Prozess: Wie eine Antwort entsteht

Schauen wir uns an, wie es funktioniert. Du gibst einen Prompt ein, zum Beispiel: "Was ist die Hauptstadt von Frankreich?"

- Analyse des Prompts: Das LLM wandelt Deinen Satz in seine numerischen Fingerabdrücke um und versteht den Kontext. Es erkennt die Muster, die auf eine Frage nach einer Hauptstadt hindeuten.

- Die erste Vorhersage: Basierend auf den unzähligen Malen, die es diese oder ähnliche Fragen in seinen Trainingsdaten gesehen hat, berechnet es das wahrscheinlichste erste Wort für die Antwort. Das könnte "Die" sein.

- Die Kettenreaktion: Jetzt nimmt es den neuen Satzanfang "Die" und berechnet das nächste wahrscheinlichste Wort: "Hauptstadt". Der Satz lautet nun "Die Hauptstadt".

- Weiter im Takt: Es geht immer weiter. "Die Hauptstadt von" → "Frankreich". "Die Hauptstadt von Frankreich" → "ist". "Die Hauptstadt von Frankreich ist" → "Paris".

- Das Ende: Das Modell fügt Wort für Wort an, bis es das statistische Signal für ein Satzende (wie einen Punkt) als wahrscheinlichste nächste Einheit vorhersagt. Fertig ist die Antwort.

Es wirkt intelligent, weil die Kette der wahrscheinlichsten Wörter, basierend auf den Daten des gesamten Internets, fast immer der korrekten menschlichen Antwort entspricht.

Was ein LLM NICHT ist (Wichtige Warnung!)

Zu verstehen, wie ein LLM funktioniert, hilft auch zu verstehen, was es nicht ist.

- Es ist keine Wissensdatenbank: Ein LLM hat keine Datenbank, in der es Fakten nachschlägt. Es sagt nur das statistisch wahrscheinlichste Wort voraus. Manchmal ist das wahrscheinlichste Wort aber faktisch falsch. Das nennt man eine Halluzination.

- Es "versteht" nicht wirklich: Es verarbeitet Sprache auf einem mathematischen Niveau. Es hat kein Bewusstsein, kein Verständnis für Wahrheit oder Moral. Es ist ein Papagei, der gelernt hat, Sätze perfekt nachzubilden, aber nicht versteht, was er da überhaupt sagt.

- Es ist nicht live mit dem Internet verbunden: Ein trainiertes Modell ist ein abgeschlossenes System. Sein "Wissen" endet mit dem Stand seiner Trainingsdaten (deshalb wusste ChatGPT lange nichts über Ereignisse nach 2021).

Fazit: Ein brillanter Nachahmer, kein Denker

Ein Large Language Model ist eine der beeindruckendsten technologischen Errungenschaften unserer Zeit. Es ist ein mächtiges Werkzeug, das auf einem erstaunlich einfachen Prinzip beruht: der Vorhersage des nächsten Wortes auf einer gigantischen Skala.

Es ist keine Magie und kein Bewusstsein. Es ist Statistik und Mustererkennung in Perfektion – ein Autocomplete auf Steroiden, das die Art und Weise, wie wir mit Informationen interagieren, für immer verändern wird.

Weiterführende Fragen

Warum klingen die Antworten von verschiedenen LLMs (z.B. ChatGPT, Google Gemini) unterschiedlich?

Das liegt an mehreren Faktoren: Sie wurden auf leicht unterschiedlichen Datensätzen trainiert, haben eine andere interne Architektur (Anzahl der Parameter etc.) und wurden in einem zweiten Schritt mit unterschiedlichen menschlichen Vorgaben "feinabgestimmt", um einen bestimmten Stil (z.B. eher kreativ oder eher sachlich) zu bevorzugen.

Was ist der Unterschied zwischen einem LLM und einem Neuronalen Netz?

Ein Neuronales Netz ist das grundlegende technische Konzept – wie ein Motorblock. Ein LLM ist eine ganz spezifische, riesige und hochkomplexe Anwendung dieses Konzepts – wie ein fertig gebauter Formel-1-Motor. Man könnte sagen: Jedes LLM ist ein Neuronales Netz, aber bei weitem nicht jedes Neuronale Netz ist ein LLM (viele sind viel kleiner und für andere Aufgaben wie Bilderkennung gedacht).

Muss ich mit ChatGPT "bitte" und "danke" schreiben oder auf Grammatik achten?

Nein, musst du nicht. Das LLM hat keine Gefühle und bewertet dich nicht nach deiner Höflichkeit. Es reagiert auf die Schlüsselwörter und den Kontext deiner Anfrage, nicht auf die Umgangsformen. Allerdings kann eine klare, grammatikalisch korrekte Formulierung helfen, präzisere und bessere Ergebnisse zu erzielen, weil die Anfrage für die Maschine weniger missverständlich ist.

Kann man ein LLM auf eigene, private Daten trainieren?

Ja, das ist ein sehr häufiger Anwendungsfall. Unternehmen nehmen ein großes Basis-LLM und "feinabstimmen" (fine-tune) es mit ihren eigenen internen Dokumenten, E-Mails oder Kundendaten. Dadurch lernt das Modell den spezifischen Jargon und das Wissen des Unternehmens und kann zum Beispiel als Support-Chatbot eingesetzt werden.

Jetzt kostenlos abonnieren und immer auf dem Neuesten bleiben. 🚀