Vom Spielbrett zur realen Welt. Die gleiche Methode, mit der die KI AlphaGo lernte, den weltbesten Go-Spieler zu schlagen, wird heute eingesetzt, um Robotern das Laufen beizubringen oder die Kühlung riesiger Rechenzentren zu optimieren.

Es prägt bereits Deinen Alltag – im Guten wie im Schlechten. Reinforcement Learning (RL) steckt hinter den fesselnden Feeds von Social-Media-Apps, die Deine Aufmerksamkeit maximieren, aber auch hinter der unsichtbaren Effizienz, die Deine Pizza heiß und pünktlich ankommen lässt.

Die größte Chance liegt in der Lösung komplexer Systeme. Von der Optimierung globaler Lieferketten bis hin zur Entwicklung personalisierter medizinischer Behandlungspläne – RL hat das Potenzial, einige der größten Herausforderungen unserer Zeit zu lösen.

Reinforcement Learning klingt oft nach der kompliziertesten und am wenigsten greifbaren der drei großen Lernmethoden. Aber seine Fähigkeit, durch Versuch und Irrtum optimale Strategien zu finden, macht es zu einem revolutionären Werkzeug für einige der komplexesten Probleme unserer Zeit.

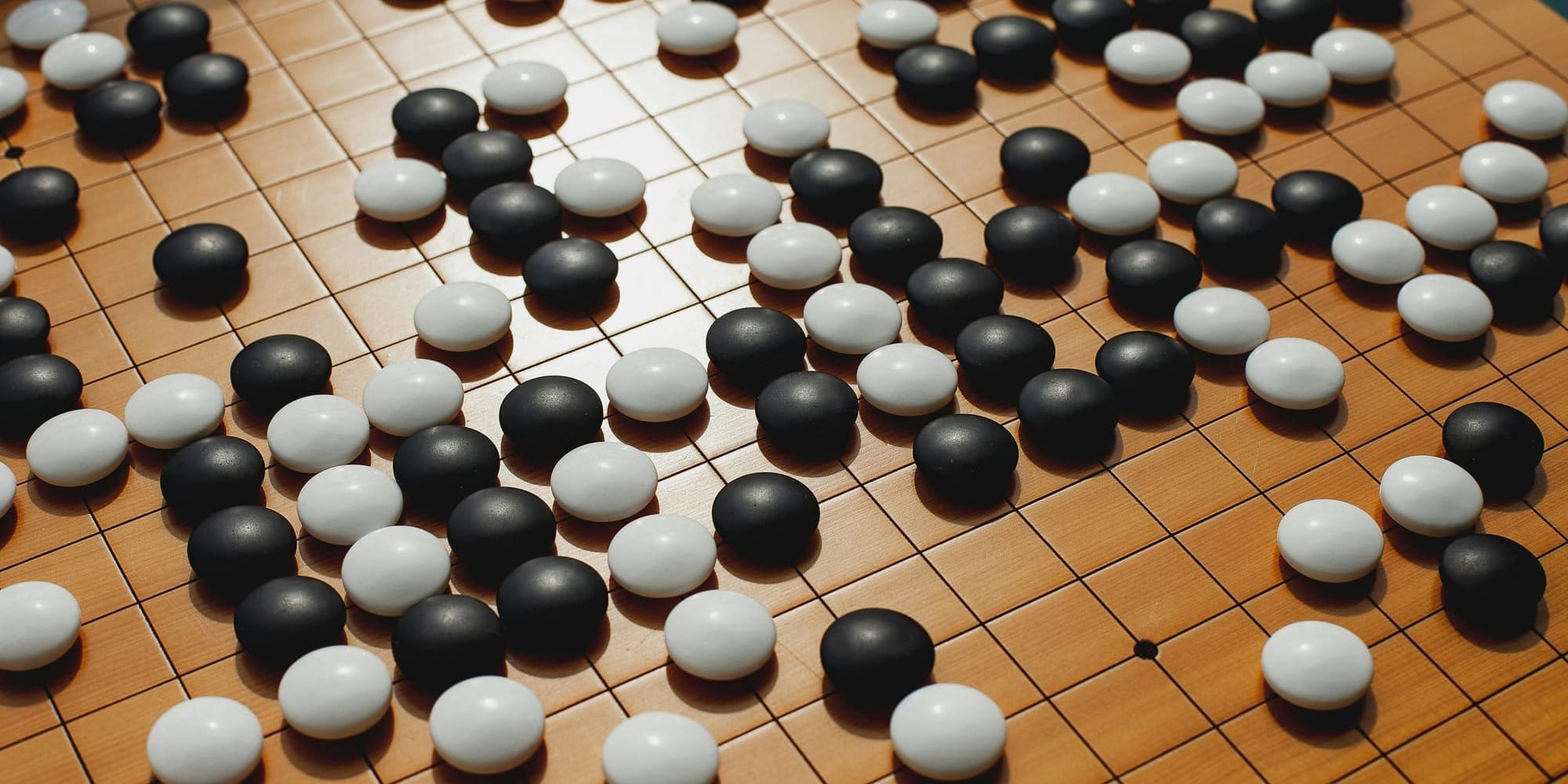

Der unschlagbare Spielpartner: KI in Schach, Go und Videospielen

Im März 2016 richtete sich die Aufmerksamkeit der Tech-Welt und darüber hinaus auf Seoul, Südkorea. Dort trat Lee Sedol, einer der besten Go-Spieler der Welt, gegen einen stillen, unsichtbaren Gegner an: eine Künstliche Intelligenz namens AlphaGo, entwickelt von DeepMind (einem Tochterunternehmen von Google).

Das Ergebnis: AlphaGo gewann die Serie mit 4:1. Aber es war nicht nur der Sieg, der die Welt schockierte. Es war die Art, wie die KI gewann.

Das Prinzip des Selbstspiels: Millionen Partien in einer Woche

Wie konnte AlphaGo diese übermenschliche Leistung vollbringen? Es hat nicht einfach nur die Züge menschlicher Großmeister auswendig gelernt. Es wurde zu seinem eigenen, unermüdlichen Lehrer, indem es Reinforcement Learning durch Selbstspiel anwendete.

Stell Dir den Prozess wie folgt vor:

- Die Grundlagen lernen: Zuerst wurde AlphaGo mit einer Datenbank von Tausenden menschlicher Profi-Partien trainiert (ein Ansatz des Supervised Learning). So lernte es die grundlegenden Muster und Strategien des Spiels, um auf ein solides Niveau zu kommen.

- Der Kampf gegen sich selbst: Jetzt begann der eigentliche, revolutionäre Teil. AlphaGo startete, Millionen von Partien gegen sich selbst zu spielen. Eine Version des Programms trat gegen eine leicht veränderte Kopie von sich selbst an. Jede dieser Partien war ein kompletter Lernzyklus.

- Die Belohnung definieren: Das Ziel war denkbar einfach. Für einen Sieg am Ende der Partie gab es eine Belohnung von +1. Für eine Niederlage gab es eine "Bestrafung" von -1.

- Lernen durch Versuch und Irrtum: In jeder Partie probierte die KI leicht veränderte Züge und Strategien aus. Wenn eine bestimmte Zugfolge am Ende zu einem Sieg (also zu einer +1 Belohnung) führte, wurde diese Strategie in ihrem internen neuronalen Netz leicht verstärkt. Züge, die zu einer Niederlage führten, wurden abgeschwächt.

Dieser Prozess lief mit einer Geschwindigkeit ab, die für einen Menschen unvorstellbar ist. AlphaGo konnte an einem einzigen Tag mehr Go-Partien spielen, als ein Mensch in tausend Lebensjahren spielen könnte. Durch diese millionenfache Wiederholung entwickelte es ein tiefes, intuitives Verständnis für das Spiel, das weit über das hinausging, was es aus den menschlichen Partien gelernt hatte.

Der legendäre "Zug 37": Wenn die Maschine kreativ wird

Der Wendepunkt im Match gegen Lee Sedol war der berühmte "Zug 37" in der zweiten Partie. AlphaGo machte einen Zug, der so unerwartet, so unkonventionell und auf den ersten Blick so "falsch" wirkte, dass alle menschlichen Kommentatoren ihn für einen Fehler hielten. Ein menschlicher Profi hätte diesen Zug niemals gespielt.

Doch dieser Zug war kein Fehler. Er war ein Geniestreich. AlphaGo hatte in seinen Millionen von Selbst-Partien eine Strategie über das Spiel entdeckt, die in 3.000 Jahren menschlicher Go-Geschichte unentdeckt geblieben war. Lee Sedol war so schockiert, dass er den Raum für 15 Minuten verließ, um sich zu sammeln. Später sagte er: "Es war ein Zug, der mich zum Nachdenken gebracht hat: 'Ist das wirklich ein menschlicher Zug?' Ich habe noch nie einen solchen Zug gesehen. Es war ein Schock."

Dieser Moment hat unser Verständnis von KI fundamental verändert. AlphaGo hat nicht nur gezeigt, dass eine Maschine ein komplexes, kreatives Spiel gewinnen kann. Es hat gezeigt, dass sie es neu definieren kann. Sie war nicht nur ein Nachahmer, sondern ein Innovator.

Von Go zu StarCraft: Die nächste Stufe der Komplexität

Nach dem Erfolg von AlphaGo wandte sich DeepMind noch komplexeren Herausforderungen zu, wie dem Strategiespiel StarCraft II. Hier gibt es nicht nur ein Spielbrett, sondern auch unvollständige Informationen (man sieht beispielsweise nicht, was der Gegner gerade macht), Echtzeit-Entscheidungen und Hunderte von Einheiten, die gleichzeitig gesteuert werden müssen.

Auch hier lernte die KI AlphaStar durch Millionen von simulierten Partien. Sie entwickelte Strategien, die menschliche Profis verblüfften, indem sie die Stärken und Schwächen der verschiedenen Einheiten auf eine Weise ausnutzte, die bisher als unkonventionell galt.

Warum das für Dich relevant ist:

Diese Erfolge sind weit mehr als nur eine technische Spielerei. Sie sind die "Formel 1" der KI-Entwicklung. Die hier entwickelten Algorithmen, die lernen, komplexe Probleme mit unvollständigen Informationen zu lösen und langfristige Strategien zu entwickeln, sind die Grundlage für reale Anwendungen. Die gleiche Technik, die lernt, eine Armee in StarCraft zu steuern, könnte eines Tages genutzt werden, um komplexe Logistikketten zu optimieren, den Verkehr in einer ganzen Stadt zu managen oder wissenschaftliche Experimente zu planen.

Die KI als Spielpartner zeigt uns also nicht nur die Grenzen der menschlichen Leistungsfähigkeit auf, sondern gibt uns auch einen faszinierenden Einblick in die Zukunft der Problemlösung. Sie beweist, dass Maschinen nicht nur unsere Muster lernen, sondern auch völlig neue entdecken können – und uns damit zwingen, die Welt selbst mit neuen Augen zu sehen.

Roboter, die Laufen lernen wie Kleinkinder

Wenn wir uns einen modernen Industrieroboter in einer Autofabrik ansehen, sind wir oft von seiner Präzision beeindruckt. Mit unfehlbarer Genauigkeit schweißt, schraubt und montiert er Teile, wieder und wieder, 24 Stunden am Tag. Doch diese Roboter haben eine entscheidende Schwäche: Sie sind brillant darin, eine exakt vorprogrammierte Aufgabe in einer perfekt kontrollierten Umgebung auszuführen. Verändert sich aber nur eine Kleinigkeit – liegt ein Bauteil nur wenige Millimeter daneben – sind sie hilflos. Sie sind Meister der Wiederholung, aber keine Meister der Anpassung.

Wie aber bringt man einem Roboter eine Fähigkeit bei, die für uns Menschen selbstverständlich ist, aber eine immense Anpassungsleistung erfordert – wie zum Beispiel das Laufen? Ein Kleinkind lernt nicht durch Programmierung, sondern durch unzählige Versuche, durch Hinfallen und Wiederaufstehen.

Genau diesen natürlichen Lernprozess adaptiert die moderne Robotik mithilfe von Reinforcement Learning. Anstatt einem Roboter jede Bewegung mühsam vorzugeben, lässt man ihn wie ein Kleinkind selbst herausfinden, wie man sich fortbewegt.

Die digitale Sandkiste: Lernen in der Simulation

Einem echten, teuren Roboter das Laufen durch Hinfallen beizubringen, wäre ein kostspieliges und langwieriges Unterfangen. Deshalb findet der Lernprozess fast immer in einer digitalen Simulation statt. Man erstellt einen exakten virtuellen Zwilling des Roboters in einer computergenerierten Welt, die den Gesetzen der Physik folgt.

In dieser sicheren "Sandkiste" kann der Roboter – unser Agent – ohne Risiko experimentieren. Der Prozess folgt der klassischen Feedback-Schleife des Reinforcement Learning:

- Der Anfang: Chaotisches Zappeln: Zu Beginn hat der Roboter keine Ahnung, wie er seine Motoren und Gelenke (seine möglichen Aktionen) koordinieren soll. Er probiert zufällige Bewegungen aus. Das Ergebnis ist meist ein chaotisches Zucken und ein schnelles Umfallen.

- Die Belohnung definieren: Der Schlüssel zum Erfolg ist eine clever definierte Belohnungsfunktion. Die Entwickler legen fest, welches Verhalten belohnt und welches bestraft wird. Eine typische Funktion für das Laufenlernen könnte so aussehen:

- Große positive Belohnung (+100): Für jeden Meter, der in eine bestimmte Richtung zurückgelegt wird.

- Kleine negative Belohnung (-1): Für jede Sekunde, die vergeht (um Trödeln zu bestrafen).

- Große negative Belohnung (-1000): Für ein Umfallen.

- Extra negative Belohnung: Für einen zu hohen Energieverbrauch der Motoren (um effiziente Bewegungen zu fördern).

- Millionen von Versuchen: Nun lässt man die Simulation laufen. Der virtuelle Roboter probiert Millionen von Bewegungssequenzen aus. Anfangs fällt er ständig um und sammelt hauptsächlich negative Punkte. Aber durch Zufall macht er vielleicht eine Bewegung, die ihn einen Zentimeter nach vorne bringt, ohne umzufallen. Dafür erhält er eine kleine positive Belohnung.

- Die Strategie entsteht: Das KI-System (ein neuronales Netz, das die Policy des Roboters steuert) merkt sich diese erfolgreiche Bewegung. Es beginnt, ähnliche Bewegungen zu bevorzugen. Schritt für Schritt, Versuch für Versuch, entwickelt sich aus dem chaotischen Zappeln eine wackelige, dann eine stabilere und schließlich eine effiziente und natürliche Laufbewegung. Der Roboter hat von selbst gelernt, dass eine bestimmte Koordination seiner Gelenke die langfristige Belohnung maximiert.

Von der Simulation in die Realität: Der Transfer

Sobald der virtuelle Roboter in der Simulation eine robuste Laufstrategie entwickelt hat, wird diese gelernte "Software" – die fertige Policy – auf den echten, physischen Roboter übertragen. Oft sind noch einige Anpassungen nötig, um kleine Unterschiede zwischen der Simulation und der realen Welt auszugleichen (z.B. Reibung oder leichte Ungenauigkeiten in den Bauteilen).

Das Ergebnis sind Roboter, die sich erstaunlich organisch und anpassungsfähig bewegen können. Unternehmen wie Boston Dynamics nutzen diese Techniken, um ihren berühmten Roboterhunden das Laufen auf unebenem Gelände, das Treppensteigen und sogar das Wiederaufstehen nach einem Stoß beizubringen.

Warum das für Dich relevant ist: Die anpassungsfähige Fabrik der Zukunft

Diese Lernmethode ist der Schlüssel für die nächste Generation von Robotern, die weit über die starren Fertigungsstraßen von heute hinausgehen.

- In der Logistik und im Lager: Roboter können lernen, eine Vielzahl von unterschiedlichen Paketen zu greifen und zu sortieren, anstatt nur eine einzige, standardisierte Kiste zu bewegen. Sie können sich flexibel durch ein sich ständig veränderndes Lager bewegen.

- Im Handwerk und auf der Baustelle: Roboter könnten lernen, unebenes Gelände zu navigieren und Aufgaben in einer unstrukturierten Umgebung auszuführen, was die Sicherheit für menschliche Arbeiter erhöht.

- Im Haushalt und in der Pflege: Ein Haushaltsroboter, der lernt, eine Tasse vom Tisch zu nehmen, ohne sie zu zerbrechen, oder ein Pflegeroboter, der einem Menschen sicher aufhelfen kann, wird erst durch diese anpassungsfähige Art des Lernens möglich.

Reinforcement Learning befreit die Robotik von den Fesseln der starren Programmierung. Es ermöglicht die Entwicklung von Maschinen, die nicht nur Befehle ausführen, sondern durch Interaktion mit ihrer Umwelt lernen, sich anzupassen und Probleme auf eine Weise zu lösen, die der unseren erstaunlich nahekommt. Das Versprechen ist eine Welt, in der Roboter zu flexiblen Partnern werden, die uns die gefährlichen, schmutzigen und anstrengenden physischen Aufgaben abnehmen können.

Der Feed, der Dich nicht mehr loslässt: Personalisierung in sozialen Medien

Du hattest nur fünf Minuten Zeit und wolltest kurz schauen, was es Neues gibt. Eine Stunde später findest Du Dich immer noch scrollend in Deinem TikTok-, Instagram- oder YouTube-Feed wieder. Du bist von einem Video zum nächsten gesprungen, hast gelacht, gestaunt und die Zeit komplett vergessen. Der Strom an perfekt auf Dich zugeschnittenen Inhalten schien endlos.

Dieses Phänomen, oft als "Rabbit Hole" (Kaninchenbau) bezeichnet, ist kein Zufall. Es ist das Ergebnis eines der mächtigsten und kommerziell erfolgreichsten Anwendungsfälle von Reinforcement Learning. Der Algorithmus, der Deinen "For You"-Feed kuratiert, ist nicht nur eine einfache Empfehlungsmaschine. Er ist ein hochintelligenter Agent, der in Echtzeit lernt, wie er Deine Aufmerksamkeit am besten fesseln und halten kann.

Du bist die Umgebung: Wie der Algorithmus Dich studiert

Um zu verstehen, wie das funktioniert, müssen wir die Rollen im Reinforcement-Learning-Prozess neu besetzen:

- Der Agent: Ist der Algorithmus der Plattform.

- Die Umgebung: Bist Du, der Nutzer, mit Deinen Interessen, Deiner Stimmung und Deiner begrenzten Aufmerksamkeitsspanne.

- Die Aktion: Ist die Entscheidung des Algorithmus, Dir ein ganz bestimmtes Video als Nächstes zu zeigen. Aus einem Pool von Millionen von Videos wählt er genau das eine aus, von dem er glaubt, dass es jetzt die beste Wirkung hat.

- Die Belohnung: Ist Deine messbare Reaktion.

Was genau ist eine "Belohnung" in diesem Kontext? Es ist jede Form von Engagement, die signalisiert, dass Du "dranbleibst". Die KI erhält eine positive Belohnung, wenn Du:

- ein Video bis zum Ende oder sogar mehrmals anschaust (Watch Time ist die härteste Währung).

- einen "Like" vergibst ❤️.

- einen Kommentar hinterlässt oder das Video teilst.

- dem Ersteller des Inhalts folgst.

Eine negative Belohnung (oder einfach keine Belohnung) gibt es, wenn Du ein Video sofort wegwischst oder die App schließt.

Das Ziel: Maximierung Deiner Verweildauer

Das übergeordnete Ziel des Algorithmus ist klar definiert und rein wirtschaftlicher Natur: Er soll die Gesamtverweildauer auf der Plattform maximieren. Warum? Weil mehr Zeit in der App mehr Möglichkeiten bedeutet, Dir Werbung anzuzeigen – das Kerngeschäftsmodell dieser Plattformen.

Der KI-Agent lernt also durch Versuch und Irrtum eine Policy (eine Strategie), die eine Abfolge von Videos generiert, die Dich mit der höchsten Wahrscheinlichkeit in der App hält. Er lernt dabei extrem subtile Muster:

- Er erkennt, dass Du abends vielleicht eher entspannende Kochvideos magst, während Du morgens auf lustige Tiervideos reagierst.

- Er lernt, dass nach drei Comedy-Clips ein emotionales Video oft besonders gut funktioniert, um die Monotonie zu durchbrechen.

- Er lernt, Dich immer wieder an die Grenzen Deiner Komfortzone zu führen und Dir neue Themen vorzuschlagen, um zu sehen, ob Du darauf anspringst (Exploration), bevor er Dir wieder sichere "Treffer" liefert (Exploitation).

Dieser Prozess ist hochgradig personalisiert und adaptiv. Der Feed für Dich und der Feed für Deinen besten Freund können sich dramatisch unterscheiden, selbst wenn ihr ähnliche Interessen habt, weil die KI auf eure individuellen Interaktionsmuster in Echtzeit reagiert.

Warum das für Dich relevant ist: Der Unterschied zwischen "relevant" und "gut":

Dieses Wissen ist entscheidend, um den eigenen Medienkonsum bewusst zu steuern. Der Algorithmus optimiert nicht für Dein Wohlbefinden, Deine Bildung oder eine ausgewogene Weltsicht. Er optimiert für ein einziges, messbares Ziel: Engagement.

Das führt zu mehreren kritischen Effekten:

- Filterblasen und Echokammern: Die KI neigt dazu, Dir immer mehr von dem zu zeigen, was Du bereits magst. Das fühlt sich gut an, kann aber dazu führen, dass Du kaum noch mit anderen Meinungen oder Perspektiven in Berührung kommst.

- Verstärkung von Extremen: Oft sind es die schockierenden, emotionalisierenden oder kontroversen Inhalte, die das meiste Engagement erzeugen. Der Algorithmus kann daher eine Tendenz haben, solche Inhalte zu bevorzugen, was zur Polarisierung der öffentlichen Debatte beitragen kann.

- Suchtpotenzial: Der ständige Strom an perfekt zugeschnittenen Dopamin-Hits durch neue, fesselnde Inhalte ist gezielt darauf ausgelegt, Dich so lange wie möglich zu binden. Die Mechanismen ähneln denen eines Spielautomaten.

Reinforcement Learning hat die Personalisierung von Inhalten auf ein neues Level gehoben. Es hat Plattformen wie TikTok zu einem globalen Phänomen gemacht. Aber es ist ein zweischneidiges Schwert. Zu verstehen, dass Du nicht nur ein Konsument, sondern die "Umgebung" für eine lernende KI bist, deren Ziel es ist, Deine Aufmerksamkeit zu maximieren, ist der erste und wichtigste Schritt zu einem mündigen und selbstbestimmten Umgang mit sozialen Medien.

Die unsichtbare Hand, die das Klima schützen soll: Energiemanagement in Rechenzentren

Wenn wir die Dienste von Google, Microsoft oder Amazon nutzen – sei es eine einfache Suchanfrage, das Speichern von Fotos in der Cloud oder das Streamen eines Films – denken wir selten darüber nach, was im Hintergrund passiert. Hinter diesen nahtlosen digitalen Erlebnissen stehen gigantische, lagerhallengroße Rechenzentren. Das sind die physischen Gehirne des Internets, vollgestopft mit Tausenden von Servern, die ununterbrochen arbeiten und dabei eine enorme Menge an Wärme produzieren.

Eine der größten Herausforderungen und einer der größten Kostenfaktoren für diese Rechenzentren ist die Kühlung. Würde man die Server nicht permanent kühlen, würden sie überhitzen und ausfallen. Diese Kühlung verbraucht eine astronomische Menge an Energie – so viel wie ganze Städte.

Wie also optimiert man ein so komplexes System mit Tausenden von Variablen – Außentemperatur, Serverauslastung, Pumpendruck, Ventilstellungen –, um die Server sicher zu kühlen und gleichzeitig so wenig Energie wie möglich zu verbrauchen? Die Antwort von Google und anderen Tech-Giganten lautet: Reinforcement Learning.

Ein digitales Thermostat mit Superkräften

Ein menschlicher Operator kann ein Kühlsystem basierend auf Erfahrung und festen Regeln steuern. Aber die schiere Komplexität und die sich ständig ändernden Bedingungen machen es unmöglich, immer die absolut optimale Einstellung zu finden.

Hier kommt der KI-Agent ins Spiel. Er wird zum ultimativen Energiemanager, der das Kühlsystem des gesamten Rechenzentrums steuert. Der Lernprozess sieht dabei so aus:

- Der Agent: Ist das KI-Steuerungssystem.

- Die Umgebung: Ist das gesamte physische Kühlsystem des Rechenzentrums mit all seinen Sensoren, Pumpen, Ventilen und Kühlaggregaten.

- Die Aktionen: Der Agent kann Hunderte von verschiedenen Einstellungen gleichzeitig verändern (z.B. "erhöhe den Wasserdruck in Pumpe A um 5 %", "öffne Ventil C um 10 Grad").

- Die Belohnung: Die Belohnungsfunktion ist hier clever und mehrdimensional gestaltet. Das primäre Ziel ist es, die Energieeffizienz zu maximieren. Die KI erhält eine positive Belohnung für jede eingesparte Kilowattstunde im Vergleich zu einem Basismodell. Gleichzeitig gibt es aber auch eine sehr große negative Belohnung, wenn die Temperatur der Server einen kritischen Grenzwert überschreitet, um die Sicherheit zu gewährleisten.

Lernen aus der Simulation und der Realität

Ähnlich wie bei der Robotik lernt die KI zunächst in einer detaillierten Simulation des Rechenzentrums. Dort kann sie Millionen von verschiedenen Steuerungsszenarien durchspielen, ohne die echte Hardware zu gefährden. Sie lernt dabei, wie sich die Außentemperatur auf die Kühlleistung auswirkt oder wie sich eine erhöhte Serverauslastung (z.B. während eines großen Sportereignisses) auf die Wärmeentwicklung auswirkt.

Nachdem sie in der Simulation eine robuste Strategie (Policy) entwickelt hat, wird sie vorsichtig auf das reale System losgelassen. Dort lernt sie weiter und passt ihre Strategie kontinuierlich an die realen Gegebenheiten an. Sie entdeckt dabei oft Zusammenhänge und Optimierungsmöglichkeiten, auf die menschliche Ingenieure nie gekommen wären. Sie lernt zum Beispiel, dass es manchmal energieeffizienter ist, bestimmte Pumpen kurzzeitig auf Hochtouren laufen zu lassen, um einen Kältepuffer zu schaffen, anstatt sie konstant auf mittlerem Niveau zu betreiben.

Warum das für Dich relevant ist: Ein gewaltiger, unsichtbarer Klimabeitrag:

Das Ergebnis dieses Einsatzes ist spektakulär. DeepMind, die KI-Abteilung von Google, hat berichtet, dass ihr RL-System den Energieverbrauch für die Kühlung um bis zu 40 % senken konnte. Über alle Rechenzentren von Google hinweg summiert sich das zu einer Energieeinsparung von hunderten Millionen Kilowattstunden pro Jahr.

Das hat zwei gewaltige Auswirkungen:

- Wirtschaftlich: Es spart dem Unternehmen hunderte Millionen Dollar an Stromkosten.

- Ökologisch: Es reduziert den CO2-Fußabdruck dieser Rechenzentren massiv. Da der Energieverbrauch des Internets und der KI-Systeme weltweit rasant ansteigt, ist diese Art der Effizienzsteigerung ein entscheidender Hebel im Kampf gegen den Klimawandel.

Dieses Beispiel zeigt Reinforcement Learning von seiner besten Seite. Es ist eine unsichtbare Hand, die im Hintergrund arbeitet, um eines der komplexesten industriellen Systeme unserer Zeit zu optimieren. Es beweist, dass KI nicht nur zur Personalisierung von Unterhaltung oder zur Automatisierung von Arbeit eingesetzt werden kann, sondern auch zur Lösung von fundamentalen, globalen Herausforderungen wie der Energiekrise. Es ist ein kraftvolles Argument dafür, dass die größten Chancen dieser Technologie vielleicht nicht in den Anwendungen liegen, die wir täglich sehen, sondern in denen, die im Verborgenen unsere Welt ein kleines bisschen besser und nachhaltiger machen.

Der schnelle Paketbote (und Essenslieferant): Dynamische Routenplanung

Du bestellst an einem verregneten Sonntagabend eine Pizza über eine App. Obwohl Du weißt, dass gerade Hochbetrieb herrscht und der Stadtverkehr unberechenbar ist, kommt der Lieferbote erstaunlich schnell und die Pizza ist noch heiß. Oder Du bestellst ein Paket bei einem großen Online-Händler mit "Same-Day-Delivery" und verfolgst in der App fasziniert, wie das Paket seinen Weg durch das Labyrinth der Stadt zu Dir findet und pünktlich im angegebenen Zeitfenster ankommt.

Hinter dieser scheinbar reibungslosen Logistik steckt ein Problem von gigantischer Komplexität, das oft als "Problem des Handlungsreisenden auf Steroiden" bezeichnet wird. Es geht nicht nur darum, den kürzesten Weg für einen Fahrer zu finden, sondern die Routen von Tausenden von Fahrern gleichzeitig zu koordinieren, die Hunderte von Zielen ansteuern, während sich die Bedingungen (Verkehr, neue Bestellungen) in Echtzeit ändern.

Dieses Problem ist für traditionelle Planungsmethoden kaum zu lösen. Deshalb setzen moderne Logistik- und Lieferdienste zunehmend auf Reinforcement Learning, um einen digitalen Disponenten zu schaffen, der das gesamte Netzwerk wie ein Großmeister im Schach überblickt.

Das Orchester der Lieferungen dirigieren

Stellen wir uns das System wieder im Rahmen des Reinforcement Learning vor:

- Der Agent: Ist die zentrale Zuweisungs-KI des Lieferdienstes. Er ist der Dirigent des gesamten Liefer-Orchesters.

- Die Umgebung: Ist die reale Stadt mit ihrem gesamten Straßennetz, dem aktuellen Verkehrsfluss, allen verfügbaren Fahrern, den Restaurants oder Lagerhäusern und den Standorten der Kunden.

- Die Aktionen: Der Agent hat eine riesige Anzahl von möglichen Aktionen. Eine Aktion könnte sein: "Weise Bestellung #123 dem Fahrer #45 zu und berechne für ihn die Route über die Hauptstraße" oder "Bündle die Bestellungen #124 und #125 für Fahrer #46, da sie in derselben Nachbarschaft liegen."

- Die Belohnung: Die Belohnungsfunktion ist darauf ausgelegt, die Gesamteffizienz des Netzwerks zu maximieren. Positive Belohnungen gibt es für:

- schnelle Lieferzeiten.

- pünktliche Ankünfte innerhalb des versprochenen Zeitfensters.

- geringen Kraftstoffverbrauch durch kurze oder staufreie Routen.

- eine hohe Anzahl an abgeschlossenen Lieferungen pro Fahrer und Stunde.

Negative Belohnungen gibt es für Verspätungen, lange Wartezeiten oder ineffiziente Routen.

Lernen, auf das Unerwartete zu reagieren

Ein menschlicher Disponent kann eine Route planen, aber er ist überfordert, wenn sich die Bedingungen ständig ändern. Die KI hingegen lernt genau das. Sie wird in einer Simulation, die mit den realen Verkehrs- und Bestelldaten von Monaten oder Jahren gefüttert wird, trainiert.

In dieser Simulation spielt sie Millionen von "Was-wäre-wenn"-Szenarien durch:

- Was ist die beste Strategie, wenn auf der Hauptverkehrsader plötzlich ein Stau entsteht? Sollen die Fahrer umgeleitet werden, auch wenn der Weg länger ist?

- Was ist die effizienteste Reaktion, wenn mitten in der Stoßzeit eine Flut neuer Bestellungen aus einem bestimmten Stadtteil hereinkommt? Welcher Fahrer sollte seine aktuelle Route unterbrechen, um diese Aufträge zu übernehmen?

- Sollte ein Fahrer, der fast fertig ist, noch einen letzten Auftrag annehmen, der ihn leicht von seinem Heimweg abbringt, wenn dadurch ein anderer Fahrer entlastet wird?

Durch dieses endlose Training entwickelt der RL-Agent eine dynamische Policy, die nicht nur statische Routen plant, sondern auf unvorhergesehene Ereignisse in Echtzeit reagiert, um das Gesamtsystem im Gleichgewicht zu halten. Er lernt die komplexen Wechselwirkungen zwischen Fahrerstandorten, Lieferzeiten und Verkehrsfluss.

Warum das für Dich relevant ist: Die unsichtbare Effizienz, die Du spürst:

Jedes Mal, wenn Du eine schnelle und pünktliche Lieferung erhältst, profitierst Du direkt von der Arbeit dieser KI. Sie ist der Grund, warum:

- Deine Pizza heiß ankommt: Die KI hat den nächstgelegenen, verfügbaren Fahrer ausgewählt und ihm die Route mit der geringsten Stauwahrscheinlichkeit gegeben.

- Dein Paket am selben Tag geliefert werden kann: Das System optimiert die Bündelung von Paketen und die Routen so, dass ein einzelner Fahrer eine maximale Anzahl von Stopps in minimaler Zeit erledigen kann.

- Die Liefergebühren (relativ) niedrig bleiben: Durch die Maximierung der Effizienz (weniger Benzin, mehr Lieferungen pro Stunde) können die Unternehmen ihre Betriebskosten senken, was sich letztendlich auf die Preise für den Endkunden auswirkt.

Reinforcement Learning ist in diesem Fall die unsichtbare Kraft, die das moderne Versprechen der On-Demand-Wirtschaft überhaupt erst möglich macht. Es verwandelt das städtische Chaos in ein optimiertes, vorhersagbares System – und das Ergebnis spürst Du direkt, wenn der Klingelknopf an Deiner Tür gedrückt wird.

Personalisierte Medizin der Zukunft: Adaptive Behandlungspläne

Die moderne Medizin hat enorme Fortschritte gemacht, aber bei vielen komplexen und chronischen Krankheiten – wie Diabetes, Krebs oder Autoimmunerkrankungen – stößt sie an eine grundlegende Grenze: die Individualität des menschlichen Körpers. Ein Medikament, das bei einem Patienten hervorragend wirkt, kann bei einem anderen wirkungslos sein oder starke Nebenwirkungen haben. Behandlungspläne basieren oft auf statistischen Durchschnittswerten und klinischen Studien, die nicht die einzigartige Reaktion jedes einzelnen Patienten abbilden können. Ärzte passen die Therapie basierend auf Erfahrung und regelmäßigen Kontrollen an, aber dieser Prozess ist oft langsam und reaktiv.

Stell Dir nun eine Zukunft vor, in der ein Behandlungsplan nicht mehr ein starres Rezept ist, sondern ein dynamischer, lernender Prozess, der sich kontinuierlich an den Zustand des Patienten anpasst. Genau diese Vision rückt durch den Einsatz von Reinforcement Learning in den Bereich des Möglichen. Die KI wird hier nicht zum Arzt, sondern zum hochspezialisierten medizinischen Strategen, der den behandelnden Arzt dabei unterstützt, die optimale Therapie-Sequenz für einen einzelnen Patienten zu finden. 🩺

Ein persönlicher Gesundheits-Coach, der aus Daten lernt

Das Konzept, eine KI als Behandlungsplaner einzusetzen, ist einer der anspruchsvollsten, aber auch vielversprechendsten Anwendungsfälle für Reinforcement Learning. So sieht die Feedback-Schleife in diesem Kontext aus:

- Der Agent: Ist das KI-Empfehlungssystem.

- Die Umgebung: Ist der Patient mit seinem einzigartigen Gesundheitszustand, seinen Genen, seinem Lebensstil und all seinen medizinischen Daten (Blutwerte, Blutzucker, Tumormarker etc.).

- Die Aktionen: Sind die möglichen Behandlungsentscheidungen, die die KI vorschlagen kann. Zum Beispiel: "Erhöhe die Dosis von Medikament A um 5 mg", "Wechsle zu Therapie B" oder "Warte und beobachte für die nächste Woche".

- Die Belohnung: Die Belohnungsfunktion ist hier extrem sorgfältig und ethisch sensibel zu gestalten. Eine positive Belohnung gibt es für messbare Verbesserungen der Gesundheitswerte (z.B. ein sinkender Blutzuckerspiegel, ein schrumpfender Tumor). Eine negative Belohnung gibt es für das Auftreten von starken Nebenwirkungen oder eine Verschlechterung des Zustands.

Lernen aus Tausenden von digitalen Patienten

Natürlich kann man eine solche KI nicht direkt an echten Patienten "ausprobieren" lassen. Das Training findet in einer komplexen Simulation statt, die auf riesigen Mengen an anonymisierten Patientendaten aus klinischen Studien und medizinischen Datenbanken basiert.

In dieser Simulation erschafft die KI Tausende von "digitalen Zwillingspatienten". Für jeden dieser virtuellen Patienten spielt sie unzählige Behandlungsverläufe durch. Sie lernt durch Millionen von Versuchen, welche Abfolge von Therapieentscheidungen bei einem Patienten mit einem bestimmten Profil (Alter, Genetik, Krankheitsstadium) langfristig zum besten Gesundheitsergebnis führt.

Sie lernt dabei extrem komplexe Zusammenhänge, die ein Mensch kaum überblicken könnte:

- Sie könnte entdecken, dass eine anfänglich hohe Dosis eines Medikaments zwar schnell wirkt, aber später zu Resistenzen führt, während ein langsames Einschleichen langfristig erfolgreicher ist.

- Sie könnte lernen, dass die Kombination von Therapie A und B bei Patienten mit einem bestimmten genetischen Marker besonders wirksam ist.

Die daraus resultierende Policy ist keine starre Regel, sondern eine adaptive Strategie. Sie gibt dem Arzt keine Befehle, sondern Vorschläge: "Für einen Patienten mit diesem Profil ist die statistisch beste nächste Aktion, die Dosis um 5 mg zu erhöhen. Die erwartete Erfolgschance liegt bei 85 %."

Warum das für Dich relevant ist: Die Revolution der personalisierten Medizin:

Dies ist mehr als nur eine technische Spielerei. Es ist der Ausblick auf einen fundamentalen Wandel in der Medizin – weg von der "One-size-fits-all"-Behandlung hin zu einer hochgradig personalisierten und dynamischen Therapie.

- Bessere Behandlungserfolge: Indem die Therapie kontinuierlich an die individuelle Reaktion des Patienten angepasst wird, können die Wirksamkeit erhöht und die Behandlungsdauer potenziell verkürzt werden.

- Weniger Nebenwirkungen: Die KI kann lernen, Behandlungswege zu vermeiden, die bei einem bestimmten Patientenprofil wahrscheinlich zu starken Nebenwirkungen führen.

- Unterstützung für Ärzte: In einer Welt mit immer mehr medizinischem Wissen und Behandlungsoptionen kann die KI dem Arzt als mächtiges Werkzeug dienen, um alle verfügbaren Daten zu berücksichtigen und eine fundiertere Entscheidung zu treffen. Die finale Verantwortung bleibt dabei immer beim Menschen.

Auch wenn der breite klinische Einsatz noch in der Zukunft liegt, ist die Forschung in diesem Bereich intensiv. Reinforcement Learning hat das Potenzial, die Art und Weise, wie wir über die Behandlung von Krankheiten nachdenken, grundlegend zu verändern. Es verspricht eine Zukunft, in der eine Therapie so einzigartig ist wie der Patient selbst.

Fazit: Der unsichtbare Stratege in unserer Welt

Vom übermenschlichen Go-Spieler über den lernenden Roboter bis hin zur unsichtbaren Hand, die Deinen Social-Media-Feed kuratiert und gleichzeitig den Energieverbrauch unseres Internets senkt – die Anwendungsfälle von Reinforcement Learning sind so vielfältig wie beeindruckend. Sie alle folgen demselben einfachen Prinzip: dem Lernen durch belohnte Konsequenzen.

Reinforcement Learning ist der Stratege unter den KI-Methoden. Es ist die Technologie der Wahl, wenn es nicht um eine einzelne richtige Antwort geht, sondern um die beste Abfolge von Entscheidungen in einer komplexen, sich verändernden Umgebung.

Die Beispiele zeigen aber auch das zweischneidige Schwert dieser Macht. Einerseits kann RL Systeme auf eine Weise optimieren, die menschliches Wohlergehen und globale Ziele wie den Klimaschutz fördert. Andererseits kann es genauso gut darauf trainiert werden, rein kommerzielle Ziele wie die Maximierung unserer Bildschirmzeit zu verfolgen, mit potenziell negativen gesellschaftlichen Folgen.

Zu verstehen, wie dieser unsichtbare Stratege funktioniert, ist deshalb mehr als nur technisches Interesse. Es ist eine entscheidende Kompetenz, um die digitale Welt, in der wir leben, kritisch zu hinterfragen und die Chancen und Risiken der intelligentesten Systeme, die wir je geschaffen haben, bewusst einzuordnen.

Weiterführende Fragen

Warum wird RL nicht für einfachere Aufgaben wie Spam-Filterung eingesetzt?

Weil es für solche Probleme einen viel einfacheren und direkteren Weg gibt. Bei der Spam-Filterung gibt es eine klare "richtige Antwort" ("Spam" oder "Kein Spam"). Dafür ist Supervised Learning, das mit bereits beschrifteten Beispielen lernt, viel effizienter und präziser. RL ist dann stark, wenn es um eine Sequenz von Entscheidungen geht, nicht um eine einzelne Klassifizierung.

Ist die KI in meinem Social-Media-Feed "böse" oder will sie mich süchtig machen?

Die KI hat keine Absichten oder Gefühle. Sie ist nicht "böse". Sie ist jedoch auf ein einziges, klar definiertes mathematisches Ziel optimiert: die Maximierung Deiner Interaktion und Verweildauer. Das Ergebnis dieses rein mathematischen Ziels kann für Menschen suchtähnliche Züge annehmen, weil die KI lernt, welche Reize (z.B. emotionale oder schockierende Inhalte) am besten funktionieren, um dieses Ziel zu erreichen.

Ist der Einsatz von RL in der Medizin nicht gefährlich?

Ja, der Einsatz ist mit extrem hohen Sicherheitsanforderungen verbunden. Deshalb findet das Training fast ausschließlich in Simulationen statt, die auf riesigen Mengen anonymisierter Patientendaten basieren. In der realen Anwendung würde eine solche KI niemals autonom entscheiden, sondern immer nur als ein hochentwickeltes Beratungssystem fungieren, das einem menschlichen Arzt datengestützte Vorschläge macht. Die finale Entscheidung und Verantwortung bleibt immer beim Arzt.

Jetzt kostenlos abonnieren und immer auf dem Neuesten bleiben. 🚀