Training ist das Lernen, Inferenz ist das Anwenden. Das Training ist der einmalige, monatelange Prozess, bei dem ein KI-Modell aus riesigen Datenmengen lernt. Die Inferenz ist der blitzschnelle Moment, in dem das fertig trainierte Modell dieses Wissen nutzt, um Deine Frage zu beantworten.

Die Analogie: Pauken vs. Prüfung. Das Training ist wie das monatelange, extrem anstrengende Pauken für eine große Abschlussprüfung. Die Inferenz ist wie das schnelle Beantworten einer einzelnen Frage in der Prüfung selbst.

Der Energieverbrauch ist dramatisch unterschiedlich. Das Training ist ein brutaler Kraftakt, der gigantische Mengen an Rechenleistung und Energie verschlingt. Eine einzelne Inferenz ist im Vergleich dazu sehr energieeffizient, aber die schiere Masse an Milliarden von täglichen Anfragen führt ebenfalls zu einem hohen Gesamtverbrauch.

Wir stellen ChatGPT eine komplexe Frage, und in wenigen Sekunden erhalten wir eine wohlformulierte Antwort. Wir geben Midjourney eine absurde Idee, und fast augenblicklich erscheint ein Kunstwerk. Die Geschwindigkeit und scheinbare Mühelosigkeit, mit der moderne KI-Systeme arbeiten, ist ein zentraler Teil ihrer Faszination.

Doch diese blitzschnelle Leistung verschleiert eine fundamentale Wahrheit. Die KI führt in ihrem "Leben" zwei völlig getrennte Existenzen: eine extrem langsame, mühsame und energieintensive Phase des Lernens und eine blitzschnelle, effiziente Phase der Anwendung. Diesen Unterschied zu verstehen, ist der Schlüssel, um die Funktionsweise, die Kosten und die Grenzen der KI wirklich zu begreifen.

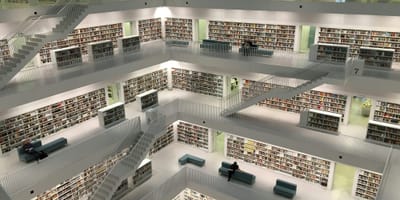

Stell es dir vor wie die Vorbereitung auf eine große Abschlussprüfung. 🎓 Das Training ist das monatelange, zermürbende Pauken in der Bibliothek. Es ist langsam, anstrengend und verbraucht Unmengen an Kaffee und Energie. Die Inferenz ist das Ablegen der Prüfung selbst. Du bekommst eine Frage und wendest dein gelerntes Wissen schnell an, um sie zu beantworten.

In diesem Deep Dive beleuchten wir diese beiden Phasen und zeigen, warum die Trennung zwischen dem anstrengenden Lernen und der eleganten Anwendung die gesamte moderne KI-Welt erst möglich macht.

Phase 1: Das Training – Ein brutaler Marathon des Lernens

Das Training ist die Geburtsstunde eines KI-Modells. Es ist der Prozess, bei dem ein "dummes", uninitialisiertes neuronales Netz zu einem Experten geformt wird. Bleiben wir bei unserer Analogie: Dies ist die Phase, in der unser Student monatelang in der Bibliothek sitzt, umgeben von einem gigantischen Berg an Büchern.

Das Lernmaterial (Die Daten):

Der Student liest nicht nur ein paar Bücher, er liest den Inhalt einer ganzen Nationalbibliothek. Für eine KI ist dieses Lernmaterial der Trainingsdatensatz – eine riesige, oft Petabytes große Sammlung an Texten, Bildern oder anderen Daten.

Die Lernmethode (Das Pauken):

Der Student paukt nicht einfach nur, er lernt aktiv. Er liest ein Kapitel, versucht, eine Übungsaufgabe zu lösen, vergleicht sein Ergebnis mit der Musterlösung, erkennt seinen Fehler und passt seine Denkweise an.

Exakt das passiert beim KI-Training. Das Modell durchläuft einen endlosen Lernzyklus:

- Es bekommt einen Datenpunkt (z.B. einen Satz, bei dem das letzte Wort fehlt).

- Es macht eine Vorhersage (rät das fehlende Wort).

- Es vergleicht seine Vorhersage mit der richtigen Antwort.

- Es berechnet den "Fehler" und passt seine Milliarden von internen Parametern (auch Gewichte genannt) minimal an, um den Fehler beim nächsten Mal zu verringern.

Die Anstrengung (Die Kosten):

Diese Phase ist ein brutaler Kraftakt. Das monatelange Pauken des Studenten entspricht in der KI-Welt:

- Immense Rechenleistung (Compute): Der Lernzyklus wird milliarden- oder sogar billionenfach wiederholt. Dies erfordert den Einsatz von Tausenden von hochleistungsfähigen Grafikkarten (GPUs), die in riesigen Clustern zusammengeschaltet sind.

- Hoher Zeitaufwand: Das Training eines großen Modells wie GPT-4 dauert viele Wochen oder sogar Monate ununterbrochener Rechenzeit.

- Massiver Energieverbrauch: All diese GPUs verbrauchen eine gewaltige Menge an Strom und erzeugen Abwärme, die aufwendig gekühlt werden muss. Dies ist die Phase, die für den riesigen ökologischen Fußabdruck der KI verantwortlich ist.

Am Ende dieses Marathons steht das Ergebnis: der Student hat seine Prüfungsvorbereitung abgeschlossen. In der KI-Welt nennen wir das Ergebnis ein trainiertes Modell. Das gesamte Wissen ist nun fest in den Milliarden von Parametern "eingebrannt".

Phase 2: Die Inferenz – Der blitzschnelle Moment der Anwendung

Jetzt kommt der Moment, für den alles trainiert wurde. Der Student betritt den Prüfungsraum. Er lernt nicht mehr, er wendet an. Dies ist die Inferenz.

Der Prüfungsbogen (Der Prompt):

Der Prüfer gibt dem Studenten eine Frage. Das ist Dein Prompt, den Du in das Chatfenster eingibst.

Die Antwort (Die Generierung):

Der Student liest die Frage, greift auf sein über Monate aufgebautes Wissen zurück und schreibt die Antwort in wenigen Minuten nieder. Er passt während der Prüfung nicht mehr sein grundlegendes Weltbild an; er nutzt es.

Genauso funktioniert die Inferenz bei einer KI. Wenn Dein Prompt beim Modell ankommt, geschieht Folgendes:

- Die Information fließt einmal von vorne nach hinten durch das bereits trainierte, "eingefrorene" neuronale Netz. Dieser Prozess wird Forward Pass genannt.

- Die Gewichte des Modells werden dabei nicht verändert. Die KI lernt in diesem Moment nichts dazu. Sie wendet nur die gelernten Muster an, um die wahrscheinlichste Fortsetzung deines Textes zu berechnen.

Die Effizienz:

Im Vergleich zum Training ist eine einzelne Inferenz unglaublich schnell und energieeffizient. Es ist der Unterschied zwischen monatelangem Lernen und einer einzigen, schnellen Antwort.

Die Herausforderung der Skalierung:

Der Student muss nur eine Prüfung schreiben. Eine KI wie die Google-Suche muss aber Milliarden von "Prüfungsfragen" pro Tag beantworten. Auch wenn jede einzelne Anfrage wenig Energie verbraucht, summiert sich die schiere Menge zu einem gewaltigen, kontinuierlichen Stromverbrauch. Man schätzt, dass über die gesamte Lebensdauer eines KI-Modells die Inferenzphase insgesamt mehr Energie verbrauchen kann als das einmalige Training.

Kapitel 3: Warum diese Trennung alles verändert

Die strikte Trennung von Training und Inferenz ist nicht nur ein technisches Detail, sondern hat fundamentale Konsequenzen für die gesamte KI-Industrie und für uns als Nutzer.

- Kosten und Zugänglichkeit: Das Training ist den Tech-Giganten mit ihren riesigen Rechenzentren vorbehalten. Die Inferenz hingegen kann auf viel kleinerer, günstigerer Hardware laufen. Dies ermöglicht das Geschäftsmodell der APIs: OpenAI trainiert das Modell einmal zentral, aber Tausende von Entwicklern können es dann über eine Schnittstelle für ihre eigenen Apps nutzen (die Inferenz ausführen). Spezialisierte Chips wie in unseren Smartphones (Edge AI) sind oft reine "Inferenz-Chips", die darauf optimiert sind, trainierte Modelle effizient auszuführen, aber nicht, sie zu trainieren.

- Optimierte Hardware: Die Anforderungen sind so unterschiedlich, dass es spezialisierte Hardware für beide Phasen gibt. Riesige GPU-Cluster für das Training; energieeffizientere TPUs oder NPUs für die Inferenz.

- Aktualität und Wissen: Der Student in der Prüfung kann keine neuen Fakten lernen. Dies erklärt perfekt das Knowledge Cutoff-Problem. Das Wissen des Modells ist auf dem Stand des Trainings eingefroren. Techniken wie RAG sind ein cleverer Weg, dem Modell während der Inferenz (der Prüfung) einen "Spickzettel" mit aktuellen Informationen zu geben.

- Sicherheit und Kontrolle: Ein fertig trainiertes Modell ist ein stabiles und vorhersagbares Produkt. Man kann es testen und seine Sicherheit bewerten. Würde das Modell von jeder einzelnen Nutzeranfrage (Inferenz) in Echtzeit lernen, könnte es leicht manipuliert oder mit Falschinformationen "vergiftet" werden. Die Trennung ermöglicht eine wichtige Qualitätskontrolle.

Fazit

Die Unterscheidung zwischen dem anstrengenden Akt des Lernens (Training) und der schnellen Anwendung des Gelernten (Inferenz) ist das Fundament, auf dem die moderne KI-Ökonomie aufgebaut ist. Das Training ist der einmalige, teure Prozess, bei dem das "intellektuelle Kapital" geschaffen wird. Die Inferenz ist die unendlich skalierbare, schnelle Dienstleistung, die dieses Kapital für uns alle nutzbar macht. Es ist der Unterschied zwischen dem Schreiben eines Buches und dem Lesen einer einzelnen Seite.

Weiterführende Fragen

Lernt ChatGPT von meinen Gesprächen in Echtzeit?

Nein. Während Deines Gesprächs befindet sich das Modell in der Inferenz-Phase – es wendet nur sein eingefrorenes Wissen an und lernt nichts dazu. Deine Konversationen können (je nach Datenschutzeinstellungen) jedoch von den Betreibern gesammelt und später als Teil eines riesigen neuen Datensatzes für das Training einer zukünftigen, verbesserten Modellversion verwendet werden.

Was ist "Fine-Tuning" – ist das Training oder Inferenz?

Fine-Tuning ist eine Form des Trainings. Es ist quasi eine kürzere, spezialisierte "Lern-Session" für ein bereits trainiertes Modell. Man nimmt das fertige Modell (den "Absolventen") und schickt es für eine Weiterbildung mit neuen, spezifischen "Fachbüchern", um es zu einem Experten zu machen.

Warum kann mein Smartphone KI-Funktionen ausführen, aber keine KI trainieren?

Weil die Hardware in Deinem Smartphone (oft eine NPU - Neural Processing Unit) hochgradig für die Inferenz optimiert ist. Sie ist darauf ausgelegt, fertig trainierte Modelle extrem schnell und energieeffizient auszuführen. Für den massiven Rechenaufwand des Trainings fehlen ihr aber die spezialisierte Architektur und die schiere Leistung, die nur große Server-GPUs in Rechenzentren bieten.

Jetzt kostenlos abonnieren und immer auf dem Neuesten bleiben. 🚀