KI-Bias bedeutet, dass eine KI systematisch unfaire Entscheidungen trifft. Sie ist nicht "böse", sondern hat Vorurteile aus den Daten gelernt, mit denen sie trainiert wurde.

Die Hauptursache sind voreingenommene Daten. Wenn eine KI mit historischen Daten lernt, die gesellschaftliche Ungerechtigkeiten widerspiegeln (z.B. dass bestimmte Gruppen seltener befördert wurden), wird sie diese Muster als Wahrheit lernen und in die Zukunft fortschreiben.

"Garbage in, garbage out" (Müll rein, Müll raus). Eine KI ist immer nur ein Spiegel ihrer Trainingsdaten. Enthält der Datensatz Lücken (z.B. fehlen Bilder von bestimmten Personengruppen) oder wurde er von Menschen mit unbewussten Vorurteilen beschriftet, wird die KI diese Fehler übernehmen und im großen Stil reproduzieren.

Wir verbinden mit Künstlicher Intelligenz oft die Hoffnung auf eine objektive, datengestützte und faire Entscheidungsfindung. Eine Maschine, so die Vorstellung, ist frei von menschlichen Emotionen, Launen und Vorurteilen. Sie schaut nur auf die harten Fakten. Was aber, wenn diese "Fakten" selbst schon ein verzerrtes Bild der Realität zeichnen?

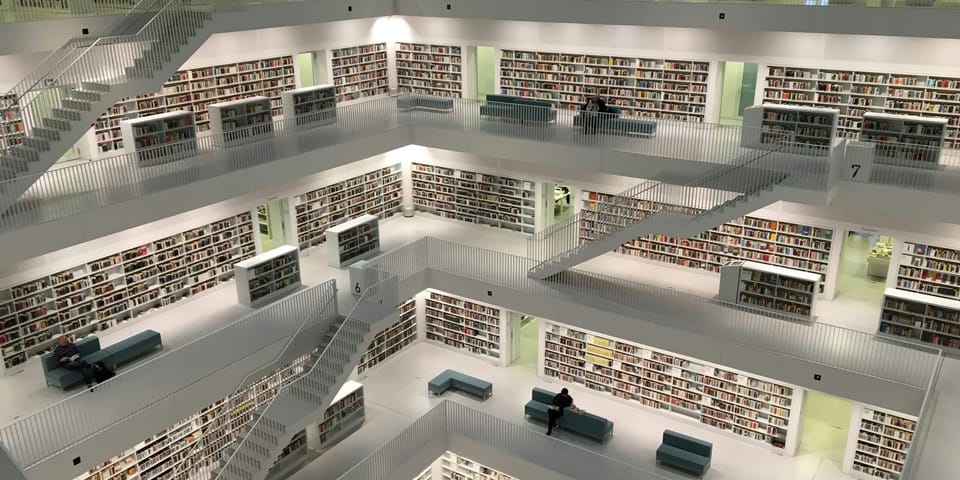

Stell Dir einen sehr fleißigen und talentierten Schüler vor. Er will alles über die Welt lernen. Aber die einzige Quelle, die ihm zur Verfügung steht, ist eine alte Bibliothek, gefüllt mit Büchern aus den 1950er Jahren. In diesen Büchern sind Frauen überwiegend als Hausfrauen dargestellt, Führungspositionen fast ausschließlich mit Männern besetzt und Menschen anderer Hautfarben kommen kaum vor oder werden in stereotypen Rollen gezeigt. 📚

Der Schüler liest all diese Bücher, lernt jedes Detail und wird zum Experten für dieses Wissen. Wenn Du ihn nun fragst, wer typischerweise ein Unternehmen leitet, wird er mit absoluter Sicherheit antworten: "Ein Mann."

Ist dieser Schüler böswillig? Nein. Er ist einfach nur das Produkt seiner Lernmaterialien. Er hat die Vorurteile seiner Zeit als unumstößliche Wahrheit gelernt.

Genau dieses Prinzip ist die Wurzel eines der größten und gefährlichsten Probleme der Künstlichen Intelligenz: dem KI-Bias.

Die Quelle des Gifts: Wie der Bias in die KI kommt

Eine KI ist nicht von Natur aus voreingenommen. Sie wird es durch die Daten, mit denen wir sie füttern. Der Grundsatz "Garbage in, garbage out" (Müll rein, Müll raus) gilt hier uneingeschränkt. Die Vorurteile schleichen sich auf mehreren Wegen in die Systeme ein.

1. Historischer Bias: Die alten Bücher der Vergangenheit

Das ist der direkteste und häufigste Weg. Die KI lernt aus historischen Daten, die die gesellschaftlichen Ungerechtigkeiten und Stereotypen unserer Vergangenheit widerspiegeln.

- Das berühmteste Beispiel: Amazons Bewerbungs-KI. Vor einigen Jahren versuchte Amazon, eine KI zu entwickeln, die Lebensläufe vorsortieren sollte. Sie wurde mit den Bewerbungsdaten der letzten zehn Jahre trainiert. Da in der Tech-Branche in dieser Zeit überwiegend Männer eingestellt wurden, lernte die KI ein einfaches Muster: Lebensläufe, die männlich konnotierte Begriffe (wie "Mannschaftskapitän im Schachclub") enthielten, waren erfolgreicher. Das System begann systematisch, Bewerbungen von Frauen herabzustufen – nicht weil es Frauen hasste, sondern weil es gelernt hatte, dass "männlich" ein Merkmal für Erfolg ist. Amazon hat das System nie eingesetzt.

Dieses Beispiel zeigt: Wenn die Vergangenheit ungerecht war, wird eine KI, die aus dieser Vergangenheit lernt, diese Ungerechtigkeit in die Zukunft fortschreiben und sogar automatisieren.

2. Repräsentations-Bias: Die unvollständige Bibliothek

Dieser Bias entsteht, wenn der Trainingsdatensatz die Realität nicht ausgewogen abbildet. Bestimmte Gruppen sind überrepräsentiert, andere kommen kaum vor.

- Das klassische Beispiel: Gesichtserkennung. Frühe Gesichtserkennungssysteme funktionierten bei weißen Männern exzellent, hatten aber eine katastrophale Fehlerquote bei Frauen und insbesondere bei Menschen mit dunklerer Hautfarbe. Warum? Weil die riesigen Bild-Datenbanken, mit denen sie trainiert wurden, hauptsächlich aus Bildern von weißen Männern bestanden. Die KI hatte einfach nie genug "Lernmaterial", um die Gesichter anderer demografischer Gruppen zuverlässig zu lernen. Für die KI waren diese Menschen quasi ein unbeschriebenes Blatt.

Wenn Deine Bibliothek nur Bücher über europäische Geschichte enthält, wird Dein Schüler nichts über die Geschichte Asiens oder Afrikas wissen.

3. Menschlicher Bias bei der Beschriftung: Der voreingenommene Lehrer

Viele KI-Modelle lernen durch Supervised Learning, also mit Daten, die von Menschen manuell beschriftet wurden. Diese menschlichen "Lehrer" bringen aber ihre eigenen, oft unbewussten Vorurteile mit in den Prozess ein.

- Beispiel Stimmungsanalyse: Stell Dir vor, Menschen sollen Kommentare als "durchsetzungsstark" oder "aggressiv" kennzeichnen. Es ist erwiesen, dass der gleiche fordernde Satz, wenn er von einem Mann geäußert wird, oft als "durchsetzungsstark" bewertet wird, während er bei einer Frau eher das Label "aggressiv" erhält. Die KI lernt diese subtile, geschlechtsspezifische Verzerrung als Fakt und wird sie in Zukunft selbst anwenden.

Die verheerenden Folgen: Diskriminierung im großen Stil

Ein voreingenommener Mensch kann großen Schaden anrichten. Eine voreingenommene KI aber kann diesen Schaden auf ein industrielles Niveau skalieren. Sie wird zum automatischen Verstärker für Ungerechtigkeit. Vor allem gefährlich wird dies, da Bias in den kleinsten Stellschrauben verheerende Wirkungen haben und leicht übersehen werden können.

- Im Kreditwesen: Eine KI könnte systematisch Menschen aus bestimmten Postleitzahlengebieten ablehnen, weil sie gelernt hat, dass diese statistisch ein höheres Ausfallrisiko haben – und ignoriert dabei die individuelle Situation des Antragstellers.

- In der Justiz: In den USA werden KI-Systeme eingesetzt, um das Rückfallrisiko von Straftätern vorherzusagen. Wenn diese Systeme mit Daten trainiert werden, die bereits einen rassistischen Bias enthalten (z.B. weil bestimmte Minderheiten häufiger verhaftet werden), werden sie genau diesen Minderheiten ein höheres Rückfallrisiko zuschreiben.

- In der Medizin: Wenn eine medizinische Diagnose-KI hauptsächlich mit Daten von einer ethnischen Gruppe trainiert wurde, könnte sie bei anderen Gruppen Symptome übersehen oder falsch interpretieren.

Das Problem wird durch die Black Box-Natur vieler KI-Systeme noch verschärft. Da wir oft nicht genau nachvollziehen können, warum eine KI zu einer Entscheidung kommt, ist es extrem schwer, einen versteckten Bias überhaupt zu entdecken, geschweige denn zu beweisen und zu korrigieren.

Gibt es einen Ausweg aus der Vorurteils-Falle?

Die Bekämpfung von KI-Bias ist eine der dringendsten Aufgaben für Entwickler, Unternehmen und die Gesellschaft. Es gibt keine einfache Lösung, aber einen klaren Weg, der aus mehreren Schritten besteht:

- Bessere Daten, bessere KI: Der wichtigste Schritt ist die sorgfältige Auswahl und Aufbereitung der Trainingsdaten. Sie müssen so vielfältig und repräsentativ wie möglich sein und sollten aktiv auf historische Verzerrungen hin untersucht und bereinigt werden.

- Algorithmische Fairness: Forscher entwickeln Techniken, um Fairness direkt in den Algorithmus einzubauen. Man kann einer KI zum Beispiel das Ziel geben, nicht nur eine genaue Vorhersage zu treffen, sondern auch sicherzustellen, dass die Fehlerquote über alle demografischen Gruppen hinweg gleich ist.

- Menschliche Aufsicht und Vielfalt: KI sollte niemals das letzte Wort in kritischen Entscheidungen haben. Ein Mensch muss immer die Möglichkeit haben, die Entscheidung zu überprüfen und zu korrigieren. Zudem ist es entscheidend, dass die Teams, die KI entwickeln, selbst vielfältig sind, um "blinde Flecken" und unbewusste Vorurteile im Entwicklungsprozess frühzeitig zu erkennen.

Fazit: Die KI als Spiegel unserer Gesellschaft

Das Problem des KI-Bias ist letztendlich kein rein technisches Problem. Die KI erfindet keine neuen Vorurteile – sie entdeckt und verstärkt die Vorurteile, die bereits in unserer Gesellschaft und in unseren Daten vorhanden sind.

Sie hält uns einen Spiegel vor. Und wenn uns das Bild, das wir darin sehen, nicht gefällt, können wir nicht einfach nur den Spiegel polieren. Wir müssen beginnen, die Welt zu verändern, die er reflektiert. Der Kampf gegen den KI-Bias ist daher untrennbar mit dem Kampf für eine gerechtere und fairere Gesellschaft verbunden.

Weiterführende Fragen

Kann man Bias nicht einfach "herausprogrammieren"?

Leider nicht so einfach. Bias ist oft tief in den subtilen Korrelationen der Daten verwurzelt und nicht auf einen einzelnen Faktor zurückzuführen. Man kann zwar versuchen, offensichtliche Merkmale wie Geschlecht oder Ethnie aus den Daten zu entfernen, aber die KI lernt oft, diese aus anderen Datenpunkten (wie Wohnort, Hobbys oder frühere Jobtitel) indirekt wieder abzuleiten.

Ist ein menschlicher Entscheider nicht immer fairer als eine voreingenommene KI?

Nicht zwangsläufig. Auch Menschen sind voller unbewusster Vorurteile. Der Vorteil einer KI ist, dass ihr Bias (wenn er einmal erkannt ist) messbar und potenziell korrigierbar ist. Das Ziel ist nicht unbedingt, eine perfekt faire KI zu schaffen (was vielleicht unmöglich ist), sondern eine, deren Fairnessgrad messbar und nachweislich höher ist als der eines durchschnittlichen menschlichen Entscheiders.

Was kann ich als normaler Nutzer beim Umgang mit KI beachten?

Sei kritisch und hinterfrage automatisierte Entscheidungen. Wenn du das Gefühl hast, von einem algorithmischen System unfair behandelt zu werden (z.B. bei einer Online-Bewerbung oder einem Kreditantrag), frage nach den Entscheidungskriterien. Unterstütze Unternehmen und Initiativen, die sich für transparente und ethische KI einsetzen, und bringe dich in die gesellschaftliche Debatte ein. Bewusstsein ist der erste und wichtigste Schritt.

Jetzt kostenlos abonnieren und immer auf dem Neuesten bleiben. 🚀