Algorithmen können Märkte schlagen – aber nur wenige schaffen es langfristig. Die erfolgreichsten Hedgefonds beweisen, dass es möglich ist, doch die überwältigende Mehrheit scheitert. Die Grenze zwischen Können und Glück bleibt verschwommen, und für normale Anleger sind passive Indexfonds meist die klügere Wahl.

Technologische Ungleichheit, unklare Verantwortung und Arbeitsplatzverluste werfen fundamentale ethische Fragen auf. Hochfrequenzhandel-Firmen haben strukturelle Vorteile, Regulierung hinkt hinterher, und hunderttausende Trading-Jobs sind verschwunden – die Gesellschaft muss entscheiden, welche Art von Märkten sie will.

Die Zukunft bringt Quantencomputing, dezentralisierte Finanzen und mächtigere KI – aber fundamentale Grenzen bleiben. Märkte werden technologisch transformiert werden, doch Vorhersagbarkeit stößt an inhärente Grenzen, und die zentrale Frage ist nicht nur "Was wird passieren?", sondern "Was sollte passieren?"

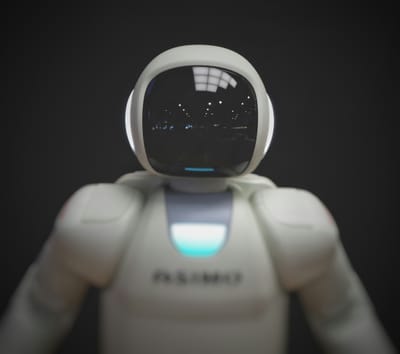

Stellen Sie sich vor, Sie könnten die New Yorker Börse besuchen – das legendäre Parkett, wo früher hunderte Händler in bunten Jacken durcheinander schrien, wild gestikulierten und Aufträge auf Zetteln notierten. Das Bild, das wir aus Filmen kennen: hektisch, laut, menschlich. Wenn Sie heute tatsächlich dort vorbeischauen, erwartet Sie eine Überraschung: gähnende Leere. Vereinzelt stehen ein paar Menschen vor Bildschirmen. Die Hektik ist verschwunden. Das Geschrei verstummt.

Was ist passiert? Die Händler sind nicht in den Ruhestand gegangen – sie wurden ersetzt. Durch Computer. Durch Algorithmen. Durch künstliche Intelligenz.

Die Revolution, die sich an den Finanzmärkten abspielt, ist für uns unsichtbar. Sie passiert nicht in prächtigen Börsenhallen, sondern in klimatisierten Rechenzentren. Sie läuft nicht in Minuten oder Sekunden ab, sondern in Millisekunden – tausendsteln Sekunden, schneller als ein Wimpernschlag. Während Sie diesen Satz lesen, haben Algorithmen weltweit tausende Aktien gekauft und verkauft, Preisunterschiede ausgenutzt, Muster analysiert und Entscheidungen getroffen – ohne dass jemals ein Mensch auf einen Knopf gedrückt hätte.

Diese Transformation ist so fundamental, dass Experten von einer neuen Ära sprechen: dem algorithmischen Zeitalter der Finanzmärkte. Maschinen handeln mit Maschinen, nach Regeln und Mustern, die oft nur noch sie selbst verstehen. Und die Beträge, um die es geht? Nicht Millionen – Billionen. Jeden einzelnen Tag.

Zahlen, die erstaunen: Wie viel Handel läuft bereits algorithmisch?

Die konkreten Zahlen sind schwer zu fassen, weil sie sich ständig ändern und je nach Markt variieren. Aber sie sind atemberaubend: An den großen US-Börsen werden Schätzungen zufolge 60 bis 75 Prozent des gesamten Handelsvolumens von Algorithmen ausgeführt. In manchen Marktsegmenten liegt der Anteil noch höher – bei über 90 Prozent.

Das bedeutet: Wenn Sie eine Aktie kaufen oder verkaufen, ist die Wahrscheinlichkeit groß, dass auf der anderen Seite kein Mensch sitzt, sondern ein Computer. Ihr Auftrag wird von einem Algorithmus entgegengenommen, der in Bruchteilen von Sekunden entscheidet, ob und zu welchem Preis er mit Ihnen handelt.

Noch beeindruckender wird es bei der Geschwindigkeit. High-Frequency Trading – Hochfrequenzhandel – macht mittlerweile einen erheblichen Teil des Börsengeschehens aus. Diese speziellen Algorithmen führen Trades in Mikrosekunden aus – das sind Millionstel Sekunden. Sie können tausende Transaktionen pro Sekunde durchführen. Zum Vergleich: Ein menschlicher Händler braucht mehrere Sekunden, um überhaupt zu erfassen, was gerade passiert ist.

Die Investitionen in diese Technologie sind gigantisch. Handelsfirmen zahlen Millionen für Glasfaserkabel, die ihre Rechenzentren wenige Kilometer direkter mit der Börse verbinden – um eine Millisekunde schneller zu sein als die Konkurrenz. Sie stellen Physiker und Mathematiker ein, die komplexe Modelle entwickeln. Sie bauen ihre Server so nah wie möglich an den Börsenservern auf – jeder Meter zählt.

Und die KI? Sie wird immer mächtiger. Moderne Machine-Learning-Systeme analysieren nicht nur Preisdaten, sondern durchforsten Nachrichtenartikel, Social-Media-Posts, Satellitenbilder von Parkplätzen vor Einkaufszentren, sogar Wetterdaten – alles auf der Suche nach einem winzigen Informationsvorteil, der sich in Profit verwandeln lässt.

Warum dieses Thema jeden betrifft – auch ohne eigene Aktien

Vielleicht denken Sie jetzt: "Interessant, aber ich habe keine Aktien. Was geht mich das an?" Die Antwort: mehr, als Sie vermutlich ahnen.

Erstens: Auch wenn Sie nicht direkt Aktien besitzen, sind Sie wahrscheinlich indirekt am Markt beteiligt. Ihre private Rentenversicherung, Ihre Lebensversicherung, vielleicht ein Bausparvertrag oder eine betriebliche Altersvorsorge – all diese Institutionen investieren Ihr Geld an den Finanzmärkten. Die Stabilität dieser Märkte betrifft also Ihre finanzielle Zukunft, Ihre Altersvorsorge, Ihre Sicherheit.

Zweitens: Die Finanzmärkte sind das Nervensystem der Weltwirtschaft. Hier wird entschieden, welche Unternehmen Kapital bekommen und welche nicht. Welche Innovationen finanziert werden. Welche Start-ups wachsen können. Wenn algorithmischer Handel diese Märkte instabiler macht – etwa durch sogenannte Flash Crashes, bei denen Aktienkurse innerhalb von Sekunden abstürzen und sich erholen – hat das reale Konsequenzen. Für Unternehmen, für Arbeitsplätze, für die gesamte Wirtschaft.

Drittens: Es geht um grundsätzliche Fragen unserer Gesellschaft. Ist es fair, wenn einige wenige Firmen durch Technologie-Vorsprung Milliarden verdienen können? Wer trägt die Verantwortung, wenn Algorithmen Fehler machen und Anleger Geld verlieren? Wie regulieren wir Systeme, die selbst Experten kaum noch durchschauen? Diese Fragen betreffen uns alle – als Bürger, als Demokratie.

Und schließlich: Die Entwicklung an den Finanzmärkten ist ein Vorgeschmack auf das, was in anderen Bereichen kommen könnte. Heute sind es Aktienhändler, die durch Algorithmen ersetzt werden. Morgen könnten es andere Berufe sein. Die Muster, die wir an der Börse beobachten – die Vorteile, die Risiken, die ethischen Dilemmata – werden uns in vielen Bereichen wieder begegnen.

Die Geschichte von KI an der Börse ist also nicht nur eine Geschichte über Geld und Märkte. Sie ist eine Geschichte über die Zukunft der Arbeit, über Gerechtigkeit und Macht, über die Frage, wie viel Kontrolle wir an Maschinen abgeben wollen – und welche Konsequenzen das hat.

1. Börse für Einsteiger: Die Grundlagen verstehen

Was ist die Börse? Handel, Preisbildung und Marktteilnehmer einfach erklärt

Die Börse ist im Kern nichts anderes als ein Marktplatz – nicht viel anders als der Wochenmarkt in Ihrer Stadt. Nur dass hier keine Äpfel oder Blumen gehandelt werden, sondern Anteile an Unternehmen (Aktien), Anleihen (Schuldverschreibungen) oder andere Finanzprodukte.

Stellen Sie sich vor: Ein Unternehmen wie BMW möchte wachsen, eine neue Fabrik bauen. Dafür braucht es Geld. Eine Möglichkeit ist, Anteile am Unternehmen zu verkaufen – Aktien. Wer eine BMW-Aktie kauft, besitzt ein winziges Stückchen von BMW. Bei über 600 Millionen ausgegebenen Aktien ist Ihr Anteil minimal, aber Sie sind rechtlich Miteigentümer. Wenn BMW Gewinn macht, profitieren Sie – durch Dividenden (Gewinnausschüttungen) oder weil die Aktie im Wert steigt.

Aber wo können Sie diese Aktie kaufen? An der Börse. Dort treffen Menschen, die Aktien kaufen wollen (Käufer), auf Menschen, die Aktien verkaufen wollen (Verkäufer). Die Börse organisiert dieses Zusammentreffen und sorgt dafür, dass alles fair und geregelt abläuft.

Die Preisbildung funktioniert nach einem simplen Prinzip: Angebot und Nachfrage. Wenn viele Menschen BMW-Aktien kaufen wollen, aber nur wenige verkaufen, steigt der Preis – wie bei den Erdbeeren auf dem Wochenmarkt im ersten Frühjahr. Gibt es mehr Verkäufer als Käufer, sinkt der Preis. Die Börse bringt beide Seiten zusammen und findet den Preis, bei dem sich beide einig werden.

Nehmen wir ein Beispiel: Sie möchten eine BMW-Aktie kaufen und sind bereit, maximal 95 Euro zu zahlen. Gleichzeitig gibt es jemanden, der seine Aktie verkaufen möchte, aber mindestens 94 Euro haben will. Die Börse bringt Sie zusammen, und Sie handeln irgendwo dazwischen – sagen wir bei 94,50 Euro. Beide sind zufrieden, der Handel kommt zustande.

Die Marktteilnehmer sind vielfältig: Privatanleger wie Sie und ich, die für ihre Altersvorsorge sparen. Institutionelle Anleger wie Pensionsfonds, Versicherungen oder Investmentfonds, die riesige Summen verwalten. Spekulanten, die auf kurzfristige Preisbewegungen wetten. Und mittlerweile eben: Algorithmen, die im Auftrag all dieser Gruppen handeln.

Die Börse erfüllt dabei wichtige Funktionen für die Wirtschaft: Sie ermöglicht es Unternehmen, Kapital zu beschaffen. Sie schafft Liquidität – Sie können Ihre Aktie jederzeit verkaufen, ohne einen Käufer persönlich suchen zu müssen. Und sie liefert durch die Preisbildung wichtige Informationen: Steigt eine Aktie, signalisiert das Vertrauen in das Unternehmen. Fällt sie, ist das ein Warnsignal.

Der traditionelle Händler: Wie Börse früher funktionierte

Gehen wir zurück in die 1980er oder 90er Jahre. Die Börse war ein Ort voller Menschen. Händler standen auf dem sogenannten Parkett – einem großen Handelssaal – und schrien sich Angebote zu. "100 BMW zu 94!", brüllte einer. "95!", konterte ein anderer. Handzeichen flogen durch die Luft: Handfläche zum Körper bedeutete kaufen, vom Körper weg verkaufen. Es war laut, chaotisch und intensiv.

Jeder Händler war spezialisiert – manche auf bestimmte Aktien, andere auf bestimmte Aufträge. Es gab Market Maker, spezialisierte Händler, die ständig Kauf- und Verkaufspreise stellten und so dafür sorgten, dass immer jemand da war, mit dem man handeln konnte. Ihre Aufgabe war es, Liquidität zu garantieren – und sie verdienten an der Differenz zwischen Kauf- und Verkaufspreis, dem sogenannten Spread.

Ein typischer Tag sah so aus: Ein Kunde – vielleicht eine Bank, die im Auftrag eines Privatanlegers handelte – rief einen Broker an und sagte: "Ich möchte 1.000 BMW-Aktien kaufen." Der Broker ging aufs Parkett oder rief dort an, suchte nach dem besten Preis und führte den Auftrag aus. Von der ersten Anfrage bis zum abgeschlossenen Handel konnten Minuten vergehen.

Die Informationslage war völlig anders als heute. Händler lasen Wirtschaftszeitungen, hörten auf Gerüchte, telefonierten mit Kontakten in Unternehmen. Nachrichten verbreiteten sich über Telefone, Ticker-Maschinen oder das Fernsehen. Wenn der BMW-Chef auf einer Pressekonferenz eine Gewinnwarnung verkündete, dauerte es Minuten bis Stunden, bis sich das im Aktienkurs niederschlug.

Das System war menschlich – im Guten wie im Schlechten. Erfahrene Händler hatten ein Gespür für den Markt, konnten Stimmungen einschätzen und nutzten jahrelange Erfahrung. Aber sie machten auch Fehler. Sie wurden müde. Sie handelten emotional – gierig in guten Zeiten, panisch in schlechten. Sie übersahen Informationen oder interpretierten sie falsch.

Die Kosten für Anleger waren erheblich. Die Spreads – die Differenz zwischen Kauf- und Verkaufspreis – waren deutlich größer als heute. Jeder Handel kostete Gebühren für Broker, Händler und die Börse selbst. Kleine Anleger hatten kaum Chancen gegen professionelle Händler mit besseren Informationen und direktem Zugang zum Parkett.

Warum Geschwindigkeit an der Börse Geld bedeutet

Hier liegt der Schlüssel zum Verständnis, warum Algorithmen die Börse übernommen haben: Geschwindigkeit ist Geld. Und zwar buchstäblich.

Stellen Sie sich vor: Eine wichtige Nachricht wird bekannt – BMW hat einen Großauftrag gewonnen. Die Aktie wird steigen, das ist klar. Wer jetzt schnell kauft, bevor der Preis nach oben schießt, macht Gewinn. Wer zu langsam ist, zahlt bereits den höheren Preis. In der alten Welt hatten diejenigen einen Vorteil, die als erste von der Nachricht erfuhren oder am schnellsten zum Telefon griffen.

Aber es gibt noch subtilere Wege, wie Geschwindigkeit Geld bedeutet. Nehmen wir Arbitrage – das Ausnutzen von Preisunterschieden. BMW-Aktien werden nicht nur in Frankfurt gehandelt, sondern auch in anderen Börsensälen. Manchmal gibt es winzige Preisunterschiede: In Frankfurt kostet die Aktie 94,50 Euro, in München 94,52 Euro. Wer schnell genug ist, kauft in Frankfurt und verkauft sofort in München – 2 Cent Gewinn pro Aktie. Klingt nach nichts? Bei 100.000 Aktien sind das 2.000 Euro. Und das in Sekunden.

Oder denken Sie an Front-Running (was in vielen Formen illegal ist, aber das Prinzip illustriert): Wenn Sie sehen, dass jemand einen riesigen Kaufauftrag platzieren will – sagen wir 1 Million BMW-Aktien – wissen Sie, dass dieser Auftrag den Preis nach oben treiben wird, einfach durch die schiere Nachfrage. Könnten Sie eine Millisekunde schneller sein und vorher kaufen, würden Sie profitieren, wenn der Preis durch den großen Auftrag steigt.

In der menschlichen Handelswelt waren diese Gelegenheiten selten und schwer zu nutzen. Die Preisunterschiede verschwanden langsam genug, dass nur Insider mit besten Verbindungen profitieren konnten. Mit Computern änderte sich das fundamental.

Ein Computer kann:

- Tausende Börsenplätze gleichzeitig überwachen

- Preisunterschiede in Millisekunden erkennen

- Sofort kaufen und verkaufen

- Muster in Kursbewegungen identifizieren

- Nachrichten automatisch analysieren und darauf reagieren

Plötzlich wurde Zeit in völlig neuen Dimensionen wichtig. Nicht Minuten oder Sekunden – Millisekunden. Eine Millisekunde ist der Unterschied zwischen Gewinn und Verlust. Zwischen einem erfolgreichen Trade und einer verpassten Gelegenheit.

Das führte zu einem technologischen Wettrüsten: Wer die schnellsten Computer hat, die direktesten Datenverbindungen, die cleversten Algorithmen, gewinnt. Handelsfirmen investieren Hunderte Millionen, um ihre Reaktionszeit um wenige Mikrosekunden zu verkürzen. Sie bauen Rechenzentren direkt neben den Börsenservern. Sie mieten die schnellsten Glasfaserkabel. Sie entwickeln spezielle Netzwerkkarten, die Daten ohne Umweg über das Betriebssystem verarbeiten – alles, um Nanosekunden zu sparen.

Für uns normale Anleger klingt das absurd. Ob Ihr Aktienauftrag in 2 Sekunden oder 2,001 Sekunden ausgeführt wird, ist völlig egal. Aber für algorithmische Händler, die tausende Male täglich winzige Margen ausnutzen, summieren sich diese Nanosekunden zu Millionen in Profit.

Die Börse ist von einem Ort, an dem Menschen gemächlich Unternehmensanteile handelten, zu einem Hochgeschwindigkeits-Datenrennen geworden. Und die Fahrer in diesem Rennen? Keine Menschen mehr – sondern Maschinen.

2. Der Aufstieg der Maschinen: Von den Anfängen bis heute

Die ersten Schritte: Einfache automatisierte Handelsregeln

Die Geschichte des algorithmischen Handels beginnt nicht mit künstlicher Intelligenz oder komplexen neuronalen Netzen. Sie beginnt erstaunlich simpel – mit dem Wunsch, menschliche Emotionen aus Handelsentscheidungen herauszunehmen.

In den frühen 1970er Jahren begannen clevere Händler, einfache Regeln aufzuschreiben: "Wenn der Preis einer Aktie unter ihren 50-Tage-Durchschnitt fällt, verkaufe. Wenn er darüber steigt, kaufe." Solche Strategien gab es schon länger, aber nun kam der entscheidende Schritt: Man programmierte sie in Computer, die automatisch handelten, sobald die Bedingungen erfüllt waren.

Diese frühen Systeme waren primitiv nach heutigen Maßstäben. Sie folgten starren "Wenn-Dann"-Regeln, die Programmierer mühsam eingegeben hatten. Ein typisches Beispiel war die Moving Average Crossover-Strategie: Kreuzt der kurzfristige gleitende Durchschnitt (etwa über 10 Tage) den langfristigen (etwa über 50 Tage) nach oben, ist das ein Kaufsignal. Kreuzt er nach unten, ein Verkaufssignal. Simple Mathematik, keine Intelligenz.

Aber selbst diese einfachen Systeme hatten Vorteile: Sie handelten diszipliniert. Kein Zögern, keine Panik, keine Gier. Wenn die Regel sagte "verkaufen", wurde verkauft – auch wenn es sich emotional falsch anfühlte. Für menschliche Händler, die oft genau im falschen Moment von Emotionen überwältigt wurden, war das revolutionär.

In den 1980er Jahren beschleunigte sich die Entwicklung. Computer wurden leistungsfähiger und billiger. Programm Trading wurde populär – Strategien, die ganze Aktienkörbe gleichzeitig kauften oder verkauften. Statt 100 Einzelentscheidungen zu treffen, gab ein Händler einen Befehl, und der Computer führte alle Trades automatisch aus. Das war effizienter, schneller und reduzierte Fehler.

Besonders beliebt wurde Index Arbitrage: Computer erkannten winzige Preisunterschiede zwischen einem Aktienindex (wie dem Dow Jones) und den Terminkontrakten auf diesen Index. Kauften sie den billigeren und verkauften den teureren, verdienten sie an der Differenz – risikolos, wenn es schnell genug ging. Und Computer waren sehr schnell.

Es war eine Zeit des Experimentierens. Die Technologie war neu, die Regeln unklar. Viele traditionelle Händler lachten über die "Computerjungs" – bis diese anfingen, beständig Geld zu verdienen. Die Maschinen waren gekommen, um zu bleiben.

Der Schwarze Montag 1987: Als Computer erstmals Chaos verursachten

Am 19. Oktober 1987 erlebte die Finanzwelt einen Alptraum. An einem einzigen Tag stürzte der Dow Jones Industrial Average um 22,6 Prozent ab – der größte prozentuale Tagesverlust in der Geschichte. Weltweit verloren Anleger in wenigen Stunden Billionen an Vermögen. Panik brach aus.

Was war passiert? Die Ursachen waren komplex – wirtschaftliche Unsicherheiten, überbewertete Märkte, geopolitische Spannungen. Aber ein Faktor machte alles schlimmer: automatisiertes Programm Trading.

Stellen Sie sich die Situation vor: Die Kurse beginnen zu fallen. Computer, programmiert mit sogenannten Portfolio Insurance-Strategien, erkennen das. Diese Strategien sollten eigentlich Verluste begrenzen – wenn Kurse fallen, verkaufe automatisch, um größere Verluste zu vermeiden. Klingt vernünftig, oder?

Aber an jenem Montag passierte Folgendes: Einige Computer begannen zu verkaufen. Das drückte die Kurse weiter nach unten. Andere Computer sahen die fallenden Kurse und begannen ebenfalls zu verkaufen. Und noch mehr Computer. Eine Kettenreaktion.

Die Verkäufe triggerten weitere Verkäufe. Der Druck wurde immer größer. Menschliche Händler, die das Chaos sahen, gerieten in Panik und verkauften auch. Das bestätigte den Computern, dass ihre Verkaufsentscheidung richtig war – also verkauften sie noch mehr. Ein Teufelskreis, ein sich selbst verstärkender Abwärtsstrudel.

Das Problem: Die Algorithmen waren nicht auf eine Situation vorbereitet, in der alle gleichzeitig verkaufen wollten. Sie hatten keine Vorstellung davon, dass ihr eigenes Handeln den Markt beeinflusste. Jeder Algorithmus agierte isoliert, nach seinen Regeln, ohne zu "verstehen", dass er Teil eines Systems war, das gerade außer Kontrolle geriet.

Innerhalb von Minuten verdampften Milliarden. Die Börse konnte die Flut an Verkaufsaufträgen kaum noch verarbeiten. Einige Market Maker – die Händler, die eigentlich für Liquidität sorgen sollten – zogen sich zurück, weil sie das Risiko nicht mehr tragen konnten. Das machte alles noch schlimmer.

Es war das erste Mal, dass die Welt sah: Computer können Märkte destabilisieren. Ihre Geschwindigkeit und ihre Fähigkeit, massenhaft gleichzeitig zu handeln, machten sie zu einer Gefahr. Die Regeln, die in ruhigen Zeiten funktionierten, versagten im Extremfall.

Nach dem Schwarzen Montag wurden Circuit Breakers eingeführt – automatische Handelsunterbrechungen, wenn Märkte zu schnell fallen. Die Idee: Einen Moment Pause erzwingen, damit sich die Gemüter beruhigen und Menschen rational über die Situation nachdenken können. Diese Schutzmaßnahmen existieren bis heute.

Aber die Lektion war klar: Automatisierter Handel war mächtig – und gefährlich. Trotzdem gab es kein Zurück. Die Technologie war zu nützlich, zu profitabel. Statt sie aufzugeben, entwickelte man sie weiter.

High-Frequency Trading: Der Wettlauf um Millisekunden

Spulen wir vor in die frühen 2000er Jahre. Die Börsen waren elektronisch geworden – kein Parkett mehr, nur noch Server. Die Internetgeschwindigkeit hatte sich vervielfacht. Und eine neue Spezies von Händlern war entstanden: die High-Frequency Trader (HFT).

Diese Firmen hatten eine radikale Einsicht: Wenn man extrem schnell ist – schneller als alle anderen – kann man winzige, flüchtige Profitgelegenheiten ausnutzen, die nur Millisekunden existieren. Und wenn man das tausendfach pro Sekunde macht, summiert sich das zu erheblichen Gewinnen.

Ein Beispiel: Eine große Bank will 1 Million Aktien von Siemens kaufen. Ein solcher Auftrag ist zu groß, um ihn auf einmal zu platzieren – das würde den Preis sofort in die Höhe treiben. Also teilt ein Algorithmus ihn in kleinere Pakete auf: 1.000 Aktien hier, 2.000 dort, über Minuten verteilt.

Aber HFT-Algorithmen können dieses Muster erkennen. Sie sehen: "Aha, da kauft jemand systematisch Siemens-Aktien. Das wird den Preis nach oben treiben." Also kaufen sie selbst Siemens-Aktien – Millisekunden bevor der nächste Teil des großen Auftrags kommt. Wenn dieser dann tatsächlich den Preis hochtreibt, verkaufen sie mit Gewinn. Das Ganze dauert vielleicht 20 Millisekunden. Der Profit pro Aktie? Vielleicht ein halber Cent. Bei 100.000 Aktien und hunderten solcher Trades pro Tag? Millionen.

Das technologische Wettrüsten wurde irrsinnig. Firmen investierten in:

Glasfaserkabel mit direkteren Routen: 2010 baute eine Firma eine direkte Glasfaserverbindung zwischen New York und Chicago – für 300 Millionen Dollar. Der Vorteil? Sie verkürzte die Übertragungszeit um 3 Millisekunden gegenüber der bisherigen Route. Drei tausendstel Sekunden, für 300 Millionen Dollar.

Mikrowellentürme: Noch schneller als Glasfaser ist: Funk. Firmen bauten Ketten von Mikrowellentürmen, um Daten durch die Luft zu schicken – schneller als durch Kabel, weil Licht in Glas langsamer ist als in Luft. Weitere Millionen, für weitere Mikrosekunden Vorteil.

Co-Location: Statt ihre Server irgendwo aufzustellen, mieten HFT-Firmen Platz direkt neben den Börsenservern – in denselben Rechenzentren. Je näher, desto kürzer die Kabelwege, desto schneller die Daten. Jeder Meter zählt, buchstäblich.

Spezial-Hardware: Normale Computer sind zu langsam. HFT-Firmen nutzen FPGAs (Field-Programmable Gate Arrays) – Chips, die speziell für eine Aufgabe programmiert werden und deshalb blitzschnell sind. Oder sie entwickeln eigene Netzwerkkarten, die Daten verarbeiten, ohne den Umweg über CPU und Betriebssystem zu nehmen.

Das Resultat: Moderne HFT-Systeme reagieren in Mikrosekunden – Millionstel Sekunden. Für menschliche Begriffe ist das quasi instantan. Die Zeit, die Sie brauchen, um mit den Fingern zu schnippen, reicht für hunderttausende Handelsentscheidungen.

Die HFT-Industrie wurde enorm profitabel – aber auch enorm umstritten. Kritiker warfen ihr vor, normale Anleger auszunutzen, Märkte zu manipulieren und nichts Wertvolles beizutragen – nur Mitnahmeeffekte auf Kosten anderer. Befürworter argumentierten, HFT schaffe Liquidität, enge Spreads und effizientere Märkte.

Eines ist sicher: HFT machte Geschwindigkeit zum alles entscheidenden Faktor. Und das bereitete den Boden für die nächste Revolution.

Machine Learning: Wenn Algorithmen selbst lernen zu handeln

Bis etwa 2010 waren Handelsalgorithmen clever, aber fundamentl dumm. Sie folgten Regeln, die Menschen programmiert hatten. Sie konnten nicht lernen, nicht adaptieren, nicht kreativ werden. Das änderte sich mit Machine Learning – maschinellem Lernen.

Die Grundidee: Statt einem System explizit zu sagen, was es tun soll, zeigt man ihm Beispiele und lässt es selbst Muster entdecken. Für den Börsenhandel bedeutet das: Man füttert einen Algorithmus mit historischen Daten – Preisbewegungen, Handelsvolumina, Nachrichtenmeldungen – und lässt ihn selbst herausfinden, welche Muster zu profitablen Trades führen.

Ein konkretes Beispiel: Ein traditioneller Algorithmus könnte programmiert sein: "Wenn eine Aktie 5% an einem Tag steigt, verkaufe – das ist wahrscheinlich eine Übertreibung." Ein Machine-Learning-System hingegen analysiert tausende vergangene Situationen, in denen Aktien 5% stiegen. Es stellt fest: "In 60% der Fälle steigt die Aktie danach weiter, wenn das Handelsvolumen überdurchschnittlich war und gleichzeitig positive Nachrichten erschienen. In 80% der Fälle fällt sie, wenn das Volumen niedrig war und es kurz vor Quartalsende passierte."

Solche Nuancen würde ein menschlicher Programmierer nie alle bedenken. Das Machine-Learning-System entdeckt sie von selbst in den Daten.

Die Techniken sind vielfältig:

Neuronale Netze analysieren komplexe, nichtlineare Zusammenhänge. Sie können hunderte Variablen gleichzeitig berücksichtigen und Muster finden, die für Menschen unsichtbar sind.

Reinforcement Learning – verstärkendes Lernen – funktioniert wie das Training eines Hundes: Der Algorithmus probiert verschiedene Handelsstrategien aus. Macht er Profit, wird diese Strategie verstärkt. Verliert er Geld, wird sie abgeschwächt. Über Millionen simulierter Trades lernt das System, was funktioniert.

Natural Language Processing – Sprachverarbeitung – ermöglicht es Algorithmen, Nachrichten zu "lesen". Eine Gewinnwarnung von BMW wird sofort analysiert, der Tonfall bewertet (wie negativ klingt die Formulierung?), und innerhalb von Millisekunden wird gehandelt – lange bevor menschliche Analysten den Text überhaupt zu Ende gelesen haben.

Sentiment Analysis durchforstet Twitter, Nachrichtenportale, sogar Reddit-Foren, um die Stimmung zu erfassen. Wenn plötzlich viele Menschen negativ über eine Aktie tweeten, könnte das ein Frühindikator für fallende Kurse sein. Die KI erkennt solche Muster und handelt danach.

Ein faszinierendes Beispiel ist der Hedgefonds Renaissance Technologies, gegründet vom Mathematiker James Simons. Die Firma setzt fast ausschließlich auf mathematische Modelle und Machine Learning – keine traditionellen Finanzanalysten, sondern Physiker, Mathematiker und KI-Forscher. Das Ergebnis: Der Hauptfonds erzielte über Jahrzehnte durchschnittliche Renditen von über 30% pro Jahr – eine Performance, die selbst Investmentlegenden wie Warren Buffett in den Schatten stellt.

Aber Machine Learning an der Börse hat auch Tücken:

Overfitting: Das System lernt historische Muster perfekt auswendig – aber diese wiederholen sich in der Zukunft nicht. Es ist wie ein Schüler, der Musterlösungen auswendig lernt, statt das Prinzip zu verstehen.

Black-Box-Problem: Moderne neuronale Netze sind so komplex, dass selbst ihre Entwickler oft nicht verstehen, warum sie eine bestimmte Entscheidung treffen. Das System sagt "Verkaufe BMW", aber niemand weiß genau, welche Faktoren zu dieser Empfehlung führten.

Unerwartetes Verhalten: Ein berühmter Fall ereignete sich 2012, als der Algorithmus der Firma Knight Capital in 45 Minuten 440 Millionen Dollar verlor – wegen eines Softwarefehlers. Das System kaufte und verkaufte wild durcheinander, zu völlig irrationalen Preisen. Die Firma stand kurz vor dem Bankrott.

Trotz dieser Risiken ist Machine Learning aus modernen Finanzmärkten nicht mehr wegzudenken. Die Algorithmen werden ständig raffinierter, lernen aus mehr Datenquellen, werden schneller und autonomer.

Wir stehen an einem Punkt, an dem Maschinen nicht nur schneller handeln als Menschen, sondern auch Muster erkennen, die Menschen nie sehen würden. Sie haben die Märkte nicht nur erobert – sie beginnen, sie grundlegend zu verändern.

3. Wie KI-Systeme an der Börse arbeiten

Datenanalyse in Echtzeit: Nachrichten, Tweets und Finanzkennzahlen

Stellen Sie sich vor, Sie müssten als menschlicher Händler alle relevanten Informationen für Ihre Investitionsentscheidungen sammeln. Sie würden vermutlich ein paar Wirtschaftszeitungen lesen, die Quartalsberichte der Unternehmen studieren, vielleicht einige Analystenmeinungen einholen. An einem guten Tag schaffen Sie vielleicht 20, 30 Informationsquellen zu durchforsten.

Moderne KI-Systeme an der Börse? Die verarbeiten Millionen Informationsquellen. Gleichzeitig. In Echtzeit. Rund um die Uhr.

Traditionelle Finanzkennzahlen bilden die Grundlage: Aktienkurse, Handelsvolumina, Bilanzdaten, Gewinnberichte. Aber das ist erst der Anfang. Ein typisches KI-Handelssystem zapft dutzende verschiedene Datenströme an:

Nachrichtenfeeds: Sekunden nachdem Reuters, Bloomberg oder die Deutschen Presse-Agentur eine Meldung veröffentlichen, hat die KI sie bereits analysiert. "VW kündigt neue Elektroauto-Fabrik an" – für ein neuronales Netz bedeutet das: positiv für VW-Aktien, vermutlich auch für Zulieferer von Batterien, möglicherweise negativ für Konkurrenten. Und das alles wird in Millisekunden verarbeitet und in Handelsentscheidungen umgesetzt.

Social Media: Twitter, Reddit, spezialisierte Finanzforen – überall diskutieren Menschen über Aktien. Ein einzelner Tweet ist bedeutungslos. Aber wenn plötzlich tausende Menschen über ein Unternehmen schreiben, könnte das ein Signal sein. KI-Systeme durchforsten Millionen Posts, filtern relevante heraus und versuchen, daraus Trends abzulesen.

Ein berühmtes Beispiel: Als Elon Musk 2018 twitterte "Am considering taking Tesla private at $420. Funding secured", reagierten Algorithmen sofort. Die Tesla-Aktie schoss in die Höhe – nicht weil Menschen den Tweet lasen und entschieden zu kaufen, sondern weil KI-Systeme das Wort "private" und "funding secured" als extrem positiv bewerteten und automatisch kauften. (Später stellte sich heraus, dass der Tweet problematisch war und Musk juristische Konsequenzen drohten – aber das ist eine andere Geschichte.)

Alternative Daten – hier wird es richtig kreativ. Moderne Hedgefonds nutzen Datenquellen, an die Sie nie denken würden:

- Satellitenbilder von Parkplätzen vor Einzelhandelsketten: Sind mehr Autos da als sonst? Dann läuft das Geschäft gut – kaufe die Aktie, bevor die Quartalszahlen das offiziell bestätigen.

- Schiffsbewegungen: Spezielle Dienste tracken Containerschiffe weltweit. Wenn viele Schiffe von China in die USA fahren – volle Container – ist das ein Signal für starken Handel. Das könnte Rückschlüsse auf Wirtschaftswachstum erlauben.

- Kreditkartentransaktionen (anonymisiert): Manche Datenanbieter verkaufen aggregierte Daten darüber, wo und wie viel Menschen mit Karten bezahlen. Steigen die Umsätze bei einer Restaurantkette? Die Aktie könnte interessant werden.

- Wettervorhersagen: Ein ungewöhnlich kalter Winter könnte den Ölpreis steigen lassen (mehr Heizung). Ein Hurrikan in Florida könnte Versicherungsaktien belasten.

Die schiere Menge und Vielfalt dieser Daten ist überwältigend. Kein Mensch könnte sie alle verarbeiten. Aber KI-Systeme sind genau dafür gemacht: riesige, heterogene Datenströme in Echtzeit zu analysieren, Relevantes von Irrelevantem zu trennen und Muster zu erkennen.

Das alles läuft in Pipelines: Daten fließen kontinuierlich hinein, werden gereinigt (Duplikate entfernt, Fehler korrigiert), strukturiert, analysiert und in Handelssignale umgewandelt. Der gesamte Prozess – von der Veröffentlichung einer Nachricht bis zum ausgeführten Trade – kann weniger als eine Sekunde dauern.

Mustererkennung: Wie Algorithmen profitable Gelegenheiten finden

Der Kern jedes erfolgreichen Handelssystems ist die Fähigkeit, Muster zu erkennen – wiederkehrende Situationen, in denen mit hoher Wahrscheinlichkeit bestimmte Preisbewegungen folgen. Menschen machen das intuitiv: "Immer wenn die Zentralbank die Zinsen erhöht, fallen Technologieaktien." KI-Systeme machen es systematisch – und finden Muster, die für Menschen unsichtbar bleiben.

Technische Muster sind der klassische Ansatz. Die sogenannte technische Analyse sucht nach charakteristischen Formationen in Kursverläufen. Ein Beispiel ist die "Kopf-Schulter-Formation": Wenn ein Kurs dreimal ansteigt, wobei der mittlere Anstieg (der "Kopf") höher ist als die beiden äußeren ("Schultern"), interpretieren Technische Analysten das als Signal für einen bevorstehenden Abwärtstrend.

Solche Muster wurden früher von Menschen identifiziert, die auf Kurs-Charts starrten. Heute trainiert man neuronale Netze mit tausenden historischen Beispielen. Das System lernt nicht nur bekannte Formationen, sondern entdeckt auch völlig neue Muster, die noch keinen Namen haben.

Korrelationsmuster sind besonders interessant. KI kann Zusammenhänge zwischen Variablen finden, die auf den ersten Blick nichts miteinander zu tun haben. Ein vereinfachtes Beispiel:

"Wenn der Goldpreis um mehr als 2% an einem Tag steigt UND gleichzeitig der Dollar gegenüber dem Euro fällt UND große Pensionsfonds ihre Käufe von Staatsanleihen reduzieren, dann steigt mit 73% Wahrscheinlichkeit der Aktienkurs von Goldminen-Unternehmen innerhalb der nächsten 6 Stunden."

Kein menschlicher Analyst würde diese spezifische Kombination von Faktoren im Blick haben. Aber ein Machine-Learning-System, das Millionen möglicher Kombinationen durchprobiert, findet sie.

Zeitliche Muster sind ebenfalls wichtig. Manche Regelmäßigkeiten sind bekannt: Der "Montag-Effekt" (Aktien tendieren montags eher schwach), der "Januar-Effekt" (kleine Aktien performen im Januar oft besser). KI-Systeme finden auch subtilere zeitliche Muster: "In den ersten 15 Minuten nach Börseneröffnung sind die Spreads größer" oder "Kurz vor wichtigen Zentralbank-Entscheidungen sinkt das Handelsvolumen."

Verhaltens-Muster anderer Marktteilnehmer sind eine Goldgrube. Große institutionelle Anleger können einen Auftrag nicht auf einmal platzieren, ohne den Markt zu bewegen. Also splitten sie ihn auf. Aber selbst diese aufgeteilten Aufträge hinterlassen Spuren – ein charakteristisches Muster von kleinen Käufen über Zeit verteilt, vielleicht abwechselnd an verschiedenen Handelsplätzen.

HFT-Algorithmen sind darauf spezialisiert, solche Muster zu erkennen. Wenn sie merken, "Aha, da versucht jemand über die nächsten 30 Minuten verteilt 500.000 Aktien zu kaufen", können sie vorher kaufen und profitieren, wenn der große Auftrag den Preis hochtreibt. Das ist ethisch fragwürdig und wird heftig debattiert – aber es zeigt, wie ausgeklügelt die Mustererkennung geworden ist.

Das Problem mit Mustern ist: Nur weil etwas in der Vergangenheit oft funktioniert hat, heißt das nicht, dass es immer funktioniert. Muster können sich ändern, verschwinden oder Opfer ihres eigenen Erfolgs werden. Wenn alle Algorithmen dasselbe Muster ausnutzen, verschwindet es – wie eine Goldader, die leergeschürft wird.

Trotzdem bleibt Mustererkennung das Herzstück algorithmischen Handels. Die Systeme werden ständig raffinierter, nutzen Deep Learning, können komplexere und abstraktere Muster erfassen. Aber ob sie damit wirklich die Zukunft vorhersagen können? Das ist eine andere Frage – dazu später mehr.

Sentiment-Analyse: Stimmungen aus Texten ablesen

Menschen sind emotionale Wesen. Angst, Gier, Optimismus, Panik – all das treibt Märkte. "The market can remain irrational longer than you can remain solvent", sagte der Ökonom John Maynard Keynes. Wenn man also die Stimmung – das Sentiment – der Marktteilnehmer messen könnte, hätte man einen wertvollen Indikator.

Genau das versucht Sentiment-Analyse – eine KI-Technik, die aus Texten die emotionale Färbung extrahiert. Ist dieser Nachrichtenartikel über BMW positiv oder negativ? Ist dieser Quartalsbericht optimistisch oder vorsichtig formuliert? Sind die Tweets über Tesla gerade bullish (optimistisch) oder bearish (pessimistisch)?

Wie funktioniert das konkret? Im einfachsten Fall nutzt man Wörterbücher: Eine Liste mit positiven Wörtern (Wachstum, Erfolg, Rekord, Durchbruch) und negativen Wörtern (Verlust, Rückgang, Krise, Enttäuschung). Ein Text wird analysiert und gezählt: Mehr positive als negative Wörter? Sentiment: positiv.

Das ist allerdings primitiv. Sprache ist komplizierter. "Die Gewinne sind nicht so stark eingebrochen wie befürchtet" – ist das positiv oder negativ? Es enthält "eingebrochen" (negativ) und "nicht" (Verneinung) und "befürchtet" (negativ). Ein simples Zählsystem würde scheitern. Aber ein modernes neuronales Netz, trainiert auf tausenden Beispielen, versteht: Das ist eine positiv formulierte Aussage – besser als erwartet.

Natural Language Processing (NLP) – die Sprachverarbeitung durch KI – hat in den letzten Jahren enorme Fortschritte gemacht. Moderne Systeme verstehen Kontext, Ironie, Verneinungen, sogar Sarkasmus. Sie können erkennen, dass "Das war ja mal wieder brillant!" in einem bestimmten Kontext genau das Gegenteil bedeutet.

Ein konkretes Anwendungsbeispiel: Ein Unternehmen veröffentlicht einen Quartalsbericht. Ein KI-System liest nicht nur die Zahlen, sondern auch den Text – das sogenannte "Management Discussion and Analysis" (MD&A). Es achtet auf Formulierungen:

- "Wir sind zuversichtlich" vs. "Wir bleiben vorsichtig optimistisch" – letzteres ist weniger positiv

- "Herausforderungen" vs. "vorübergehende Herausforderungen" – letzteres klingt besser

- Die Häufigkeit, mit der Wörter wie "Risiko" oder "Unsicherheit" vorkommen

Selbst die Länge der Sätze wird analysiert: Komplizierte, verschachtelte Formulierungen könnten bedeuten, dass das Management etwas verschleiern will.

Social Media Sentiment ist besonders interessant – und chaotisch. Millionen Menschen äußern täglich Meinungen über Aktien. Einzelne Tweets sind Rauschen, aber das aggregierte Signal könnte wertvoll sein. Einige Systeme gehen so vor:

- Sammle alle Tweets, die eine bestimmte Aktie erwähnen (z.B. $TSLA für Tesla)

- Filtere Spam und Bots heraus

- Bewerte jeder Tweet: positiv, negativ, neutral

- Gewichte nach Einfluss: Ein Tweet von einem Account mit 100.000 Followern zählt mehr als einer mit 50 Followern

- Berechne einen Gesamt-Sentiment-Score

Das Problem: Social Media ist manipulierbar. Gruppen können koordiniert positive oder negative Nachrichten verbreiten, um Kurse zu beeinflussen – sogenannte "Pump and Dump"-Schemes. Die KI muss lernen, authentisches Sentiment von Manipulation zu unterscheiden.

Ein faszinierendes Beispiel für die Macht von Sentiment-Analyse: Forscher haben gezeigt, dass die Stimmung in Twitter-Posts über den S&P 500 Index tatsächlich mit späteren Kursbewegungen korreliert – allerdings nur schwach. Genug, um vielleicht einen winzigen statistischen Vorteil zu haben, aber keine Kristallkugel.

Die Grenzen sind klar: Sentiment misst Stimmungen, keine Fundamentaldaten. Eine euphorische Stimmung bei völlig überbewerteten Aktien ist gefährlich. Umgekehrt kann pessimistische Stimmung Kaufchancen bei soliden Unternehmen bieten. Sentiment-Analyse ist ein Werkzeug von vielen – kein Allheilmittel.

Vorhersagemodelle: Der Versuch, die Zukunft zu berechnen

Die ultimative Frage an der Börse lautet: Was wird morgen passieren? Wird die Aktie steigen oder fallen? Um wie viel? Wann sollte ich kaufen oder verkaufen?

Vorhersagemodelle – Predictive Models – versuchen, genau das zu beantworten. Sie nutzen alle verfügbaren Daten, alle erkannten Muster, alle Korrelationen, um eine Prognose zu erstellen. Aber können sie wirklich die Zukunft vorhersagen?

Klassische statistische Modelle sind der traditionelle Ansatz. Zeitreihenanalyse versucht, aus vergangenen Kursverläufen zukünftige zu extrapolieren. Wenn eine Aktie in den letzten 30 Tagen einen klaren Aufwärtstrend zeigte, könnte sie weiter steigen. Solche Modelle können einfach sein (lineare Regression) oder komplex (ARIMA-Modelle, GARCH-Modelle – keine Sorge, die Details sind für uns nicht wichtig).

Das Problem: Finanzmärkte sind nicht wie das Wetter, wo physikalische Gesetze gelten. Sie sind von Menschen gemacht, chaotisch, beeinflusst von Psychologie, Nachrichten, unvorhersehbaren Ereignissen. Eine Pandemie, ein Krieg, eine überraschende Zentralbank-Entscheidung – und alle Modelle sind Makulatur.

Machine Learning Vorhersagemodelle sind anspruchsvoller. Sie nutzen neuronale Netze, die hunderte Variablen gleichzeitig berücksichtigen:

- Aktuelle und historische Kurse

- Handelsvolumina

- Volatilität (wie stark schwankt der Kurs?)

- Makroökonomische Daten (Zinsen, Inflation, Arbeitslosigkeit)

- Branchendaten

- Unternehmensspezifische Kennzahlen

- Sentiment-Scores

- Saisonale Faktoren

- Korrelationen mit anderen Aktien

Das Netz lernt komplexe, nichtlineare Zusammenhänge. Es könnte entdecken: "Wenn Variable A hoch ist UND Variable B fällt UND es Donnerstag ist UND in den letzten drei Tagen das Sentiment positiv war ABER das Handelsvolumen niedrig, dann steigt die Aktie mit 65% Wahrscheinlichkeit in den nächsten zwei Stunden."

Reinforcement Learning geht noch einen Schritt weiter. Statt nur Vorhersagen zu machen, lernt das System eine komplette Handelsstrategie. Es simuliert tausende mögliche Szenarien: "Was wäre, wenn ich jetzt kaufe? Oder in einer Stunde? Oder wenn ich stattdessen verkaufe?" Es probiert verschiedene Aktionen aus, sieht, welche Resultate sie (in der Simulation) bringen, und optimiert seine Strategie kontinuierlich.

Ein solches System könnte lernen: "Kaufe, wenn das Sentiment positiv dreht UND die Volatilität sinkt. Halte, bis entweder ein bestimmter Gewinn erreicht ist ODER Sentiment negativ wird ODER eine Nachricht mit dem Stichwort 'Gewinnwarnung' erscheint. Dann verkaufe sofort."

Ensemble-Methoden kombinieren mehrere Modelle. Die Idee: Kein einzelnes Modell ist perfekt, aber wenn fünf verschiedene Modelle unabhängig voneinander zu ähnlichen Schlüssen kommen, ist die Vorhersage vermutlich robuster. Man könnte ein statistisches Modell, ein neuronales Netz und ein Entscheidungsbaum-Modell kombinieren und ihre Vorhersagen mitteln oder gewichtet kombinieren.

Die unbequeme Wahrheit: Trotz aller Raffinesse sind Vorhersagemodelle nicht zuverlässig. Die Efficient Market Hypothesis besagt, dass alle verfügbaren Informationen bereits im Preis eingepreist sind. Wenn das stimmt, sind zukünftige Preisbewegungen im Wesentlichen zufällig – ein "Random Walk". Niemand kann sie konsistent vorhersagen.

In der Praxis sieht man: Manche Modelle funktionieren eine Zeit lang gut, dann plötzlich nicht mehr. Ein Muster, das jahrelang Profit brachte, verschwindet. Warum? Vielleicht, weil zu viele Algorithmen es ausnutzten und es dadurch verschwand. Oder weil sich Marktbedingungen änderten.

Die erfolgreichsten Modelle machen vermutlich keine dramatischen Vorhersagen, sondern finden winzige statistische Vorteile – sie liegen in 51% der Fälle richtig statt 50%. Das klingt unspektakulär, aber über tausende Trades summiert sich das zu erheblichen Gewinnen.

Das Black-Box-Problem bleibt: Bei komplexen neuronalen Netzen weiß niemand genau, warum sie eine bestimmte Vorhersage treffen. Das System sagt "Verkaufe Boeing-Aktien", aber ob es dabei auf fundamentale Unternehmensdaten, auf ein technisches Muster oder auf Twitter-Stimmungen reagiert, ist unklar. Das macht es schwierig zu entscheiden, ob man der Vorhersage trauen sollte.

Die Zukunft vorherzusagen bleibt der heilige Gral des algorithmischen Handels. Die Modelle werden besser, nutzen mehr Daten, raffiniertere Techniken. Aber perfekt werden sie nie sein. Denn Märkte bleiben letztlich unvorhersehbar – beeinflusst von menschlichen Entscheidungen, Emotionen und Ereignissen, die niemand vorhersehen kann.

4. Die verschiedenen Spieler und ihre Strategien

High-Frequency Trading: Tausende Trades in Sekunden

Stellen Sie sich einen Händler vor, der jeden Tag zur Arbeit kommt, seinen Computer anschaltet – und dann den ganzen Tag über nichts tut. Er drückt keine Knöpfe, trifft keine Entscheidungen, starrt nicht einmal auf Bildschirme. Währenddessen führt sein Computer tausende, manchmal Millionen von Trades aus. Willkommen in der Welt des High-Frequency Trading.

Was ist HFT genau? Im Kern geht es darum, winzige Profitgelegenheiten auszunutzen, die nur für Sekundenbruchteile existieren – und das in enormem Volumen. Ein typischer HFT-Trade bringt vielleicht einen halben Cent Gewinn pro Aktie. Klingt lächerlich? Bei 10 Millionen Aktien täglich sind das 50.000 Euro. Und das ist nur eine Strategie auf einem Markt.

Market Making ist eine der Hauptstrategien. Erinnern Sie sich an das Konzept von Kauf- und Verkaufspreis? Sie wollen BMW-Aktien kaufen, der beste Verkaufspreis (Ask) ist 95 Euro. Jemand anderes will verkaufen, der beste Kaufpreis (Bid) ist 94,98 Euro. Die Differenz – 2 Cent – ist der Spread.

HFT-Firmen stellen sich nun auf beide Seiten: Sie bieten an, für 94,98 Euro zu kaufen UND für 95 Euro zu verkaufen. Wenn jemand kauft und jemand anderes verkauft, verdienen sie die 2 Cent Differenz – risikolos, weil beide Trades quasi gleichzeitig passieren. Das machen sie für dutzende oder hunderte Aktien gleichzeitig, tausende Male am Tag.

Das klingt einfach, aber es ist ein Knochenjob für Computer. Sie müssen:

- Ständig Preise an allen Handelsplätzen überwachen

- Sofort reagieren, wenn sich Preise ändern

- Ihre Angebote anpassen, wenn sich Marktbedingungen ändern

- Das Risiko managen, dass sie auf einer Position "sitzen bleiben"

Arbitrage ist die zweite Hauptstrategie. Erinnern wir uns: Wenn BMW in Frankfurt für 95 Euro und in München für 95,03 Euro handelt, kaufe in Frankfurt, verkaufe in München, 3 Cent Gewinn. In der Praxis sind die Unterschiede winziger – vielleicht ein Zehntel Cent – und verschwinden in Millisekunden. Aber HFT-Systeme sind so schnell, dass sie sie ausnutzen können, bevor sie verschwinden.

Es gibt auch kompliziertere Arbitrage: Eine Aktie ist Teil eines Index. Wenn der Index-Futurekontrakt teurer ist als die Summe der einzelnen Aktien, kaufe die Aktien, verkaufe den Future. Das erfordert, dutzende Aktien gleichzeitig zu handeln – perfekt für Algorithmen.

Latency Arbitrage ist umstrittener. Hier geht es darum, Informationen über Preisänderungen schneller zu bekommen als andere. Wenn an einer Börse der Preis steigt, weiß ein ultraschnelles System, dass er auch an anderen Börsen steigen wird – und kauft dort, bevor die Information ankommt. Kritiker sagen, das sei unfair – ein Vorteil rein durch Technologie, ohne echten Mehrwert.

Die Kontroverse: HFT-Firmen argumentieren, sie brächten Liquidität, engere Spreads und effizientere Märkte. Tatsächlich sind die Handelskosten für normale Anleger in den letzten Jahrzehnten dramatisch gesunken – teilweise dank HFT. Kritiker kontern: HFT schafft "Phantom-Liquidität" – sie ist da, bis man sie braucht, und verschwindet in Krisenzeiten. Außerdem nutzen HFT-Firmen Geschwindigkeitsvorteile aus, die normale Anleger nie haben können.

Ein berühmtes Buch – "Flash Boys" von Michael Lewis – prangerte HFT als institutionalisiertes Front-Running an: HFT-Firmen sehen Ihre Aufträge und handeln Millisekunden vorher, um davon zu profitieren. Die HFT-Industrie bestreitet das vehement.

Fakt ist: HFT dominiert moderne Märkte. Die Firmen sind hoch spezialisiert, technologiegetrieben und extrem profitabel – zumindest die erfolgreichen. Es ist ein gnadenloses Geschäft: Wer nicht die schnellste Technologie hat, verliert. Ein Wettrüsten ohne Ende.

Robo-Advisor: KI als Anlageberater für Privatpersonen

Ganz am anderen Ende des Spektrums stehen die Robo-Advisor – automatisierte Anlageberater für Menschen wie Sie und mich. Kein Hochfrequenzhandel, keine Millisekunden, kein Technik-Wettrüsten. Sondern: vernünftige, langfristige Geldanlage, unterstützt durch Algorithmen.

Das Grundprinzip ist einfach. Sie beantworten einige Fragen: Wie alt sind Sie? Was ist Ihr Anlageziel – Altersvorsorge, Hauskauf, Vermögensaufbau? Wie viel Risiko können Sie vertragen – wären Sie nervös, wenn Ihr Portfolio 10% verliert, oder könnten Sie das aushalten? Wie lange wollen Sie investieren?

Basierend auf Ihren Antworten erstellt der Robo-Advisor ein diversifiziertes Portfolio – meist aus ETFs (Exchange Traded Funds), die breit gestreut in viele Aktien und Anleihen investieren. Jung mit langer Anlagedauer? Vielleicht 80% Aktien-ETFs, 20% Anleihen. Älter und risikoscheuer? 40% Aktien, 60% Anleihen.

Die KI dahinter ist nicht besonders kompliziert – zumindest im Vergleich zu HFT-Algorithmen. Aber sie löst ein echtes Problem: Traditionelle Anlageberatung war teuer und oft nur für Wohlhabende zugänglich. Ein menschlicher Berater kostet Zeit und Geld. Ein Robo-Advisor kann Millionen Kunden gleichzeitig betreuen, zu minimalen Kosten.

Die typischen Funktionen:

Automatisches Rebalancing: Wenn Sie mit 70% Aktien und 30% Anleihen starten und Aktien stark steigen, haben Sie plötzlich vielleicht 80% Aktien – mehr Risiko als geplant. Der Robo-Advisor verkauft automatisch einige Aktien und kauft Anleihen, um das ursprüngliche Verhältnis wiederherzustellen.

Tax-Loss Harvesting: Eine steueroptimierte Strategie. Wenn eine Ihrer Anlagen Verlust macht, verkauft der Algorithmus sie, um den Verlust steuerlich geltend zu machen – und kauft sofort etwas Ähnliches, damit Sie investiert bleiben. In vielen Ländern können Verluste mit Gewinnen verrechnet werden und so Steuern sparen.

Risikoanpassung über Zeit: Je näher Sie Ihrem Anlageziel kommen, desto konservativer sollten Sie werden. Ein Robo-Advisor kann Ihr Portfolio automatisch Jahr für Jahr defensiver ausrichten – mehr Anleihen, weniger Aktien – damit kurz vor der Rente ein Börsencrash Sie nicht aus der Bahn wirft.

Moderne Robo-Advisor werden ausgeklügelter. Einige nutzen Machine Learning, um:

- Ihr Verhalten zu analysieren: Neigen Sie zu Panikverkäufen in Krisen? Der Algorithmus könnte Sie warnen oder sogar "Cooling-off"-Perioden vorschlagen.

- Makroökonomische Daten einzubeziehen: Wenn eine Rezession wahrscheinlich wird, könnte das System vorschlagen, etwas defensiver zu werden.

- Ihre Ausgaben zu tracken (mit Ihrer Erlaubnis) und Sparpotenzial zu identifizieren: "Sie könnten monatlich 200 Euro mehr investieren, wenn Sie Ihre Restaurantbesuche reduzieren."

Bekannte Beispiele sind Betterment und Wealthfront in den USA, Scalable Capital oder Quirion in Deutschland. Auch traditionelle Banken bieten mittlerweile Robo-Advisory-Dienste an – sie mussten reagieren, um konkurrenzfähig zu bleiben.

Die Grenzen: Robo-Advisor sind gut für standardisierte Situationen – Vermögensaufbau, Altersvorsorge. Aber für komplexe Bedürfnisse – Nachlassplanung, Steueroptimierung bei mehreren Einkommensquellen, Investitionen in Privatunternehmen – brauchen Sie immer noch menschliche Expertise. Die beste Lösung ist oft ein Hybrid: Robo-Advisor für die Basics, menschlicher Berater für komplizierte Fragen.

Das Wichtigste: Robo-Advisor demokratisieren Zugang zu vernünftiger Geldanlage. Sie brauchen kein Millionenvermögen mehr, um professionelle Portfolioverwaltung zu bekommen. Das ist ein echter Fortschritt.

Hedgefonds: Wo die komplexesten Algorithmen zum Einsatz kommen

Wenn Robo-Advisor das demokratische Ende des Spektrums sind, sind Hedgefonds das Elite-Ende. Hier wird die modernste, komplexeste, experimentellste KI entwickelt und eingesetzt. Die Eintrittsbarrieren sind hoch, die Geheimniskrämerei legendär, die möglichen Renditen enorm – und die Risiken auch.

Was sind Hedgefonds? Vereinfacht gesagt: Investmentfonds für Wohlhabende, die fast alles dürfen. Während normale Fonds oft Beschränkungen haben (nur Aktien, kein Hebel, keine Leerverkäufe), können Hedgefonds:

- Mit geliehenem Geld handeln (Leverage) und so Gewinne vervielfachen

- "Short" gehen – auf fallende Kurse wetten

- Derivate nutzen – komplexe Finanzinstrumente

- In alles investieren – Aktien, Anleihen, Rohstoffe, Währungen, Kryptowährungen

Das gibt ihnen enorme Flexibilität – und macht sie zu idealen Testfeldern für KI-Strategien.

Quantitative Hedgefonds – "Quants" – setzen vollständig auf Mathematik und Algorithmen. Die bekanntesten:

Renaissance Technologies, gegründet von James Simons, einem Mathematiker, der zuvor Codes für den US-Geheimdienst knackte. Renaissance stellt keine Wall-Street-Trader ein, sondern Physiker, Kryptographen, Mathematiker. Ihr Hauptfonds, Medallion, ist legendär: Über 30 Jahre durchschnittlich über 60% Rendite nach Gebühren. Zum Vergleich: Warren Buffett, einer der erfolgreichsten Investoren aller Zeiten, schaffte etwa 20% über lange Zeiträume.

Wie machen sie das? Niemand weiß es genau. Medallion ist nur für Mitarbeiter zugänglich, die Strategien sind streng geheim. Man vermutet: Tausende kleine, statistische Ineffizienzen in Märkten, die durch ultraschnelle Computer und Machine Learning ausgenutzt werden. Kein einzelner Trade bringt viel, aber Millionen Trades summieren sich.

Two Sigma und DE Shaw sind ähnlich. Sie beschäftigen hunderte Datenwissenschaftler, nutzen Machine Learning, Natural Language Processing, Alternative Daten. Sie analysieren alles – von Satellitenbildern bis zu Sentiment in Social Media, von Wetterdaten bis zu Schiffsbewegungen.

Die Strategien sind vielfältig:

Statistical Arbitrage: Finde Paare von Aktien, die normalerweise zusammen bewegen (z.B. zwei Autohersteller). Wenn eine plötzlich abweicht, gehe davon aus, dass sie zurückkonvergieren – kaufe die unterbewertete, verkaufe die überbewertete.

Factor Investing: Identifiziere "Faktoren", die historisch mit höheren Renditen korrelieren – Unternehmensgröße, Bewertung, Momentum, Qualität. Baue Portfolios, die diese Faktoren systematisch ausnutzen.

Event-Driven: Nutze KI, um Unternehmensereignisse vorherzusagen oder schnell darauf zu reagieren – Fusionen, Übernahmen, Restrukturierungen. NLP-Algorithmen lesen Anwaltsdokumente, Pressemitteilungen, analysieren Wahrscheinlichkeiten.

Global Macro: Wette auf große wirtschaftliche Trends – Zinsbewegungen, Währungsschwankungen, Rohstoffpreise. Moderne Systeme nutzen Machine Learning, um makroökonomische Daten, politische Entwicklungen, sogar Klimadaten zu analysieren.

Deep Learning Experimente: Einige Fonds experimentieren mit fortschrittlichsten Techniken. Reinforcement Learning, das komplette Handelsstrategien von Grund auf lernt. Generative Modelle, die mögliche Zukunftsszenarien simulieren. Sogar Quantencomputing wird getestet – noch in Kinderschuhen, aber potenziell revolutionär.

Das Problem: Mit so viel Kapital und so vielen klugen Köpfen, die ähnliche Strategien verfolgen, werden Ineffizienzen schnell ausgemerzt. Was vor fünf Jahren funktionierte, funktioniert heute vielleicht nicht mehr. Hedgefonds müssen ständig innovieren, neue Datenquellen finden, neue Algorithmen entwickeln. Es ist ein Wettrüsten gegen andere Hedgefonds.

Die Kosten: Hedgefonds verlangen typischerweise "2 and 20" – 2% Verwaltungsgebühr pro Jahr plus 20% Erfolgsbeteiligung. Bei den Top-Quant-Fonds kann das noch höher sein. Für normale Anleger sind sie ohnehin unzugänglich – Mindestinvestitionen liegen oft bei Millionen.

Die Frage bleibt: Können selbst die besten Algorithmen langfristig den Markt schlagen, nach Gebühren? Die Evidenz ist gemischt. Einige Fonds – wie Medallion – schaffen es spektakulär. Viele andere verschwinden nach wenigen Jahren. Die Effizienz der Märkte scheint eine Grenze zu setzen, die selbst KI schwer überwinden kann.

Marktüberwachung: Wie Regulierungsbehörden KI gegen Manipulation einsetzen

Während Hedgefonds und HFT-Firmen KI nutzen, um Geld zu verdienen, haben Regulierungsbehörden eine andere Mission: Märkte fair und stabil halten. Und sie setzen zunehmend dieselben Technologien ein – KI gegen KI.

Die Herausforderung ist enorm. An einer großen Börse wie der NYSE finden Millionen Transaktionen täglich statt. Wie erkennt man darin Manipulation, Betrug oder Marktmissbrauch? Menschliche Aufseher könnten unmöglich alles überwachen. Also kommt KI ins Spiel.

Insider Trading erkennen: Wenn jemand kurz vor einer großen Ankündigung – etwa einer Übernahme – auffällig viele Aktien kauft, könnte das Insiderhandel sein – illegales Nutzen nicht-öffentlicher Informationen. KI-Systeme überwachen Handelsmuster und schlagen Alarm bei Anomalien.

Ein Beispiel: Eine Person, die normalerweise selten handelt, kauft plötzlich große Mengen einer Aktie. Zwei Tage später wird eine Übernahme angekündigt, der Kurs steigt, die Person verkauft mit Riesengewinn. Das System markiert das als verdächtig. Menschliche Ermittler schauen sich den Fall genauer an: Hat die Person Verbindungen zum Unternehmen? Zum Käufer? Zum Investmentbanker, der den Deal strukturierte?

Spoofing und Layering: Eine Form der Marktmanipulation. Der Täter platziert große Kauf- oder Verkaufsaufträge, die er nie ausführen will – nur um andere Händler zu täuschen. Beispiel: Ich will Aktien verkaufen, aber der Preis ist mir zu niedrig. Also platziere ich riesige Kaufaufträge (die ich nie ausführen will). Andere sehen die vermeintlich hohe Nachfrage und kaufen auch, der Preis steigt. Dann ziehe ich meine Fake-Kaufaufträge zurück und verkaufe zum höheren Preis.

Das alles passiert in Sekunden. Menschliche Aufseher hätten keine Chance, es zu erkennen. Aber Machine-Learning-Systeme können Muster identifizieren: Aufträge, die sofort zurückgezogen werden. Ungewöhnliche Häufung von Aufträgen kurz vor großen Preisbewegungen. Wiederkehrende Verhaltensmuster derselben Händler.

Flash Crash Analyse: Erinnern Sie sich an den Flash Crash 2010? Der Dow Jones stürzte innerhalb von Minuten um fast 1000 Punkte, bevor er sich wieder erholte. Was war passiert? Die Untersuchung dauerte Monate. Moderne KI-Systeme können in Echtzeit analysieren, wenn Märkte verrücktspielen – welche Algorithmen handelten? Welche Kettenreaktionen wurden ausgelöst? Wo lag der Ursprung?

Pump and Dump in Social Media: Betrüger koordinieren sich in Online-Foren, kaufen massenhaft eine billige Aktie, pumpen sie mit übertriebenen Behauptungen in Social Media ("die nächste Tesla!"), locken naive Anleger an, die den Preis hochtreiben – und verkaufen dann mit Gewinn. Die Spätkommer verlieren.

Regulierungsbehörden nutzen NLP und Sentiment-Analyse, um verdächtige Koordination zu erkennen. Plötzliche Spikes in Social Media Aktivität zu einer Penny-Stock, gefolgt von ungewöhnlichem Handelsvolumen – das triggert Alarme.

Die SEC (Securities and Exchange Commission) in den USA, die BaFin in Deutschland, die FCA in UK – sie alle haben in den letzten Jahren massiv in KI-Überwachungssysteme investiert. Sie müssen Schritt halten mit einer Industrie, die Milliarden in Technologie steckt.

Das Problem: Die Regulierer sind oft im Nachteil. Sie haben kleinere Budgets, können nicht die gleichen Top-Talente anziehen wie Hedgefonds (die viel besser zahlen), und sie hinken technologisch oft hinterher. Es ist ein asymmetrischer Kampf – ausgeklügelte, gut finanzierte Algorithmen auf der einen Seite, unterfinanzierte Behörden auf der anderen.

Privacy und Überwachung: Die umfassende KI-Überwachung der Märkte wirft auch Fragen auf. Jeder Trade, jede Order wird gespeichert und analysiert. Für manche ist das notwendiger Schutz. Für andere ein Überwachungsstaat für Finanzmärkte. Wo liegt die Balance zwischen Marktintegrität und Privatsphäre?

Internationale Koordination: Märkte sind global, Regulierung ist national. Ein Manipulator könnte von einem Land aus handeln, in einem anderen ein Konto haben, Aktien in einem dritten handeln. KI-Systeme verschiedener Länder müssen zusammenarbeiten, Daten teilen – eine riesige logistische und politische Herausforderung.

Die Zukunft der Marktüberwachung ist ein Wettrüsten: Immer raffiniertere Manipulation verlangt immer raffiniertere Erkennung. KI wird auf beiden Seiten eingesetzt. Ob die Guten mithalten können? Das wird sich zeigen.

5. Vorteile: Was algorithmischer Handel bringt

Nach all den Beschreibungen von Millisekunden-Wettrüsten, Flash Crashes und Black-Box-Algorithmen könnte man denken: Ist das alles nicht einfach nur gefährlich und unnötig kompliziert? Eine berechtigte Frage. Aber algorithmischer Handel hat auch echte, messbare Vorteile gebracht – für professionelle Investoren, aber auch für normale Anleger wie Sie und mich. Schauen wir uns an, was sich tatsächlich verbessert hat.

Effizienz und Liquidität: Warum Märkte flüssiger werden

Stellen Sie sich vor, Sie möchten ein seltenes Sammlerstück verkaufen – eine antike Uhr etwa. Auf einem kleinen, lokalen Markt könnten Wochen vergehen, bis Sie einen Käufer finden. Und wenn dann endlich einer kommt, müssen Sie vielleicht einen niedrigeren Preis akzeptieren, weil Sie froh sind, überhaupt jemanden gefunden zu haben. Auf einem großen, liquiden Markt – sagen wir eBay mit Millionen Nutzern – finden Sie vermutlich schnell mehrere Interessenten und können einen fairen Preis erzielen.

Mit Aktienmärkten ist es ähnlich. Liquidität bedeutet: Wie leicht können Sie kaufen oder verkaufen, ohne dass das den Preis stark bewegt? Je liquider ein Markt, desto besser für alle Teilnehmer.

Algorithmischer Handel – insbesondere Market Making durch HFT – hat die Liquidität dramatisch erhöht. Warum? Weil Computer ständig bereit sind zu handeln. Früher, auf dem menschlichen Parkett, gab es Market Maker, die Kauf- und Verkaufspreise stellten. Aber sie waren begrenzt – ein Mensch kann nur eine bestimmte Anzahl von Aktien gleichzeitig betreuen, wird müde, macht Pausen.

Algorithmen haben keine solchen Beschränkungen. Sie können:

- Hunderte verschiedene Aktien gleichzeitig überwachen

- 24/7 arbeiten (zumindest während der Handelszeiten)

- Sofort auf Nachfrage reagieren

- Große Mengen verarbeiten

Konkrete Zahlen: Der durchschnittliche Spread – die Differenz zwischen Kauf- und Verkaufspreis – ist in den letzten 20 Jahren massiv gesunken. In den 1990er Jahren lag er bei vielen Aktien bei 10-20 Cent oder mehr. Heute, bei großen liquiden Aktien, sind es oft nur 1 Cent oder sogar Bruchteile davon. Das ist ein direkter Vorteil für jeden, der kauft oder verkauft – Sie zahlen weniger für die Transaktion.

Ein Beispiel: Sie wollen 100 Apple-Aktien kaufen. Bei einem Spread von 10 Cent "verlieren" Sie sofort 10 Euro (100 Aktien × 10 Cent) – einfach durch die Differenz zwischen Kauf- und Verkaufspreis. Bei einem Spread von 1 Cent sind es nur 1 Euro. Über viele Transaktionen und viele Anleger summiert sich das zu Milliarden, die eingespart werden.

Tiefe des Marktes ist ein weiterer Aspekt. Früher, wenn Sie einen großen Auftrag hatten – sagen wir 100.000 Aktien – mussten Sie vorsichtig sein. Würden Sie alles auf einmal kaufen, würde der Preis stark steigen, weil das Angebot knapp ist. Heute, mit algorithmischen Market Makern, die kontinuierlich Liquidität bereitstellen, können auch große Aufträge effizienter ausgeführt werden.

Preisfindung – die Fähigkeit des Marktes, den "richtigen" Preis zu finden – ist ebenfalls effizienter geworden. Wenn eine Nachricht erscheint, wird sie von Algorithmen sofort verarbeitet und in Preise eingepreist. Früher konnte es Minuten oder Stunden dauern, bis Informationen sich vollständig im Preis widerspiegelten. Heute geschieht das in Sekunden.

Beispiel: Ein Unternehmen veröffentlicht besser als erwartete Quartalszahlen. Algorithmen analysieren die Zahlen sofort, vergleichen mit Erwartungen, und beginnen zu kaufen. Der Preis steigt schnell auf ein neues Gleichgewicht. Das ist effizienter als die alte Welt, wo Händler erst die Zahlen lesen, interpretieren und dann langsam reagieren mussten.

Die Kehrseite: Liquidität kann trügerisch sein. In normalen Zeiten ist sie reichlich vorhanden. Aber in Krisen – wenn jeder verkaufen will – können Algorithmen sich zurückziehen. Sie sind programmiert, bei extremer Volatilität vorsichtig zu sein. Das kann bedeuten, dass genau dann, wenn man Liquidität am meisten braucht, sie verschwindet. Das ist das "Phantom-Liquidität"-Problem, das Kritiker ansprechen.

Trotzdem: Im Durchschnitt, unter normalen Bedingungen, sind Märkte heute liquider, effizienter und haben engere Spreads als je zuvor. Das ist ein echter Fortschritt.

Emotionslose Entscheidungen: Keine Panik, keine Gier

Menschen sind brillant – aber wir sind auch emotional. Und Emotionen sind der Feind rationaler Investitionsentscheidungen. Die Geschichte der Finanzmärkte ist voll von Beispielen, wo Panik zu Massenverkäufen führte (und kluge Käufer reich machte) oder Gier zu irrationaler Übertreibung (denken Sie an die Dotcom-Blase oder die Tulpenmanie im 17. Jahrhundert).

Angst und Gier – die beiden mächtigsten Emotionen an der Börse. Warren Buffett hat es auf den Punkt gebracht: "Be fearful when others are greedy, and greedy when others are fearful" (Sei ängstlich, wenn andere gierig sind, und gierig, wenn andere ängstlich sind). Klingt einfach, aber es ist unglaublich schwer, dem eigenen emotionalen Impuls zu widerstehen.

Algorithmen haben dieses Problem nicht. Sie kennen keine Angst, keine Gier, keine Hoffnung, keine Verzweiflung. Sie folgen ihrer Programmierung, stur und konsequent.

Ein konkretes Beispiel: Stellen Sie sich vor, Sie haben eine Strategie: "Wenn eine Aktie unter ihren 200-Tage-Durchschnitt fällt, verkaufe. Wenn sie darüber steigt, kaufe." Einfach genug. Aber dann kommt ein Tag, an dem die Märkte abstürzen. Panik überall. Ihre Strategie sagt "verkaufe", aber Ihr Bauchgefühl schreit: "Warte, vielleicht erholt es sich morgen! Ich will nicht mit Verlust verkaufen!"

Oder umgekehrt: Die Märkte steigen wie verrückt. Alle reden von einer neuen Ära. Ihre Strategie sagt "verkaufe, die Aktie ist überbewertet", aber Ihr Bauchgefühl sagt: "Nur noch ein bisschen länger, es kann noch höher gehen!"

In beiden Fällen ist die Versuchung groß, von der Strategie abzuweichen. Und meistens ist das ein Fehler. Studien zeigen: Emotionales Handeln – Panikverkäufe in Krisen, zu spätes Einsteigen in Boomphasen – vernichtet langfristig Rendite.

Ein Algorithmus hat diese Versuchung nicht. Wenn die Regel sagt verkaufe, wird verkauft. Punkt. Das erzwingt Disziplin.

Cognitive Biases – kognitive Verzerrungen – sind ein weiteres Problem menschlicher Entscheidungen:

- Confirmation Bias: Wir suchen nach Informationen, die unsere Meinung bestätigen, und ignorieren widersprechende Evidenz. Wenn Sie glauben, dass eine Aktie steigen wird, achten Sie unbewusst mehr auf positive Nachrichten.

- Recency Bias: Wir gewichten jüngste Ereignisse zu stark. Eine Aktie, die letzten Monat gut lief, erscheint uns attraktiver – auch wenn das statistisch wenig über die Zukunft aussagt.

- Loss Aversion: Verluste schmerzen psychologisch etwa doppelt so stark wie Gewinne erfreuen. Das führt dazu, dass wir Verlustpositionen zu lange halten (in der Hoffnung, dass sie sich erholen) und Gewinnpositionen zu früh verkaufen.

- Overconfidence: Wir überschätzen unsere Fähigkeiten. Die meisten Menschen glauben, sie seien überdurchschnittliche Autofahrer – und überdurchschnittliche Investoren. Statistisch unmöglich.

Algorithmen leiden nicht unter diesen Verzerrungen. Sie bewerten Informationen objektiv (soweit ihre Programmierung es zulässt), gewichten alle Daten konsistent, und haben keine Ego-Probleme.

Systematisches Risikomanagement ist ein weiterer Vorteil. Menschen sind oft schlecht darin, Risiken richtig einzuschätzen und zu managen. Ein Algorithmus kann präzise berechnen: "Dieses Portfolio hat eine Volatilität von X%, eine maximale Drawdown-Wahrscheinlichkeit von Y%, eine Korrelation von Z% mit dem Gesamtmarkt." Und es kann automatisch Positionen reduzieren, wenn Risiken zu hoch werden.

Ein Beispiel aus der Praxis: Während der Finanzkrise 2008 hielten viele private Anleger ihre verlustträchtigen Positionen viel zu lange – aus Hoffnung, Leugnung oder Schock. Systematische Algorithmen mit klaren Stop-Loss-Regeln (automatisches Verkaufen bei bestimmten Verlusten) begrenzten Schäden konsequenter.

Aber: Algorithmen sind nicht perfekt. Sie können keine echte Weisheit oder Intuition ersetzen. Ein erfahrener menschlicher Investor könnte in einer Krise sagen: "Ja, die Märkte sind panisch, aber die Fundamentaldaten dieses Unternehmens sind solide. Das ist eine Kaufgelegenheit." Ein Algorithmus sieht nur: Kurs fällt, Volatilität steigt, Verkaufssignal.

Die beste Lösung ist oft eine Kombination: Systematische Regeln für Disziplin und emotionslose Ausführung – aber menschliches Urteil für strategische Entscheidungen und außergewöhnliche Situationen.

Kostenreduktion für Anleger

Vielleicht der greifbarste Vorteil: Es ist billiger geworden, an der Börse zu investieren. Dramatisch billiger. Und das verdanken wir zu einem großen Teil algorithmischem Handel.

Transaktionskosten sind in den letzten Jahrzehnten regelrecht implodiert. In den 1990er Jahren zahlte man bei einer deutschen Bank vielleicht 50 Euro Gebühr für einen Aktienkauf – egal ob für 1.000 oder 10.000 Euro Volumen. Heute gibt es Online-Broker, bei denen ein Trade 1 Euro kostet. Oder sogar kostenlos ist.

Wie ist das möglich? Mehrere Faktoren:

Automatisierung: Früher mussten menschliche Broker Aufträge entgegennehmen, verarbeiten, aufs Parkett bringen, ausführen, dokumentieren. Jeder Schritt kostete Zeit und Personal. Heute passiert alles elektronisch. Sie klicken auf "kaufen", der Algorithmus routet Ihren Auftrag automatisch zur besten Ausführungsstelle, führt ihn aus, bucht ihn in Ihr Depot – alles in Sekunden, ohne menschliches Eingreifen.

Skaleneffekte: Wenn ein Broker Millionen Kunden und Transaktionen automatisiert abwickeln kann, sinken die Kosten pro Transaktion gegen null. Die Fixkosten (Server, Software) sind hoch, aber auf Millionen Trades verteilt minimal pro Trade.

Wettbewerb: Algorithmischer Handel senkte die Eintrittsbarrieren für neue Broker. Plötzlich konnten Startups mit schlanker Technologie gegen etablierte Banken antreten. Trade Republic, Robinhood, eToro – sie alle bieten niedrigste Gebühren. Traditionelle Broker mussten nachziehen oder Kunden verlieren.

Engere Spreads: Wie bereits erwähnt, die Differenz zwischen Kauf- und Verkaufspreis ist gesunken. Das ist eine versteckte Kostenreduktion. Wenn Sie früher für 100 Euro kauften und sofort verkauften, bekamen Sie vielleicht nur 99,80 Euro zurück – 20 Cent Spread-Kosten. Heute vielleicht 99,99 Euro – nur 1 Cent Verlust.

Konkrete Zahlen: Studien schätzen, dass die Gesamtkosten des Aktienhandels (Gebühren plus Spreads) in den USA seit den 1990er Jahren um 80-90% gesunken sind. Für einen durchschnittlichen Anleger bedeutet das: Hunderte, manchmal tausende Euro Ersparnis pro Jahr.

Ein Beispiel: Jemand, der 50.000 Euro investiert und zehnmal im Jahr umschichtet, zahlte früher vielleicht 500 Euro Gebühren (10 Trades à 50 Euro) plus Spreads. Heute vielleicht 10 Euro Gebühren (10 Trades à 1 Euro) plus deutlich niedrigere Spreads. Eine Ersparnis von fast 500 Euro – zusätzliche Rendite, die im Portfolio bleibt.

ETFs und Indexfonds wurden durch algorithmischen Handel praktikabel und billig. Diese passiven Investmentprodukte bilden einfach einen Index ab – den DAX, den S&P 500, einen Weltaktienindex. Sie brauchen keine teuren Fondsmanager, die Aktien auswählen. Algorithmen passen das Portfolio automatisch an, wenn sich der Index ändert.

Die Verwaltungskosten von ETFs liegen oft unter 0,2% pro Jahr. Traditionelle aktiv gemanagte Fonds verlangen 1-2% oder mehr. Über Jahrzehnte macht das einen riesigen Unterschied. Bei 50.000 Euro über 30 Jahre und 6% jährlicher Rendite: Mit 2% Kosten bleiben Ihnen etwa 180.000 Euro. Mit 0,2% Kosten etwa 280.000 Euro. Der Unterschied – 100.000 Euro – geht rein durch Kosten verloren.

Robo-Advisor (die wir bereits kennengelernt haben) bieten professionelle Portfolioverwaltung für 0,3-0,8% jährlich. Traditionelle Vermögensverwalter verlangen oft 1,5-2,5%. Wieder eine massive Ersparnis, ermöglicht durch Automatisierung.

Die Demokratisierung des Zugangs: Früher brauchte man hohe Mindestanlagen für professionelle Verwaltung – oft 100.000 Euro oder mehr. Heute können Sie mit 500 Euro oder weniger starten. Algorithmischer Handel macht das möglich, weil die Skalierung keine zusätzlichen Kosten verursacht.

Ein Caveat: "Kostenlos" ist manchmal nicht ganz kostenlos. Manche Broker verdienen Geld durch "Payment for Order Flow" – sie verkaufen Ihre Aufträge an Market Maker, die dann minimal am Spread verdienen. Für Sie als Anleger ist das oft immer noch günstiger als klassische Gebühren, aber es ist nicht völlig ohne Kosten. Und es wirft Fragen auf, ob Interessenkonflikte entstehen.

Trotzdem: Die Kostenreduktion ist real und massiv. Sie bedeutet, dass mehr von Ihrer Rendite bei Ihnen bleibt statt an Banken und Broker zu gehen. Das ist ein echter, greifbarer Vorteil für Millionen Anleger.

Demokratisierung: Professionelle Strategien für jeden zugänglich

Vielleicht der philosophisch interessanteste Vorteil: Algorithmischer Handel hat Investieren demokratisiert. Strategien und Tools, die früher nur Profis mit großen Budgets zur Verfügung standen, sind heute für normale Menschen zugänglich.

Historischer Kontext: Vor 30, 40 Jahren war die Börse eine Welt für Insider. Informationen flossen langsam, über teure Terminaldienste wie Bloomberg (tausende Dollar im Monat). Professionelle Händler hatten direkten Zugang zu Börsenparkett, Insider-Kontakte, Research-Abteilungen. Privatanleger lasen bestenfalls die Wirtschaftszeitung und hofften auf Tipps von ihrem Bankberater – der oft mehr am Verkauf bestimmter Produkte interessiert war als an Ihrer optimalen Rendite.

Die Informationsasymmetrie war enorm. Profis wussten mehr, schneller. Sie hatten bessere Werkzeuge, niedrigere Kosten, und konnten Strategien umsetzen, die für Privatanleger unmöglich waren.

Die digitale Revolution änderte das grundlegend:

Informationszugang: Heute haben Sie auf Ihrem Smartphone Zugriff auf dieselben Nachrichten, Kursdaten, Unternehmensberichte wie professionelle Investoren. In Echtzeit. Kostenlos oder für minimale Gebühren. Bloomberg-Terminals kosten immer noch 20.000 Euro im Jahr, aber für Basisdaten brauchen Sie sie nicht mehr.

Analytische Tools: Früher mussten Sie komplexe Berechnungen von Hand machen oder teure Software kaufen. Heute gibt es kostenlose oder günstige Plattformen, die Ihnen technische Indikatoren, fundamentale Kennzahlen, Portfolio-Analysen auf Knopfdruck liefern. Screener helfen Ihnen, aus tausenden Aktien diejenigen zu finden, die Ihre Kriterien erfüllen – etwas, das früher Tage dauerte.

Automatisierte Strategien: Früher war algorithmischer Handel nur für Hedgefonds und Investmentbanken mit Millionenbudgets für Technologie zugänglich. Heute können Sie bei vielen Brokern eigene einfache Algorithmen erstellen: "Kaufe automatisch jeden Monat für 200 Euro einen Welt-ETF" oder "Verkaufe, wenn eine Aktie 10% Verlust macht" oder komplexere Regeln.

Für ambitionierte Privatanleger gibt es Plattformen wie QuantConnect oder MetaTrader, wo Sie mit etwas Programmier-Knowhow komplexe Strategien entwickeln, backtesten (auf historischen Daten testen) und automatisiert handeln lassen können.

Robo-Advisor haben wir schon besprochen – aber es lohnt sich zu betonen: Sie bringen institutionelle Qualität zu Privatanleger-Preisen. Diversifikation über dutzende oder hunderte Einzelpositionen, automatisches Rebalancing, Tax-Loss Harvesting, Risikomanagement – all das war früher nur für Wohlhabende verfügbar. Heute bekommt es jemand mit 1.000 Euro Startkapital.

Fractional Shares: Algorithmischer Handel ermöglicht es, Bruchteile von Aktien zu kaufen. Früher: Wenn eine Amazon-Aktie 3.000 Euro kostet, brauchten Sie 3.000 Euro, um auch nur eine zu kaufen. Heute können Sie bei vielen Brokern für 100 Euro ein Drittel einer Amazon-Aktie kaufen – rechnerisch aufgeteilt. Das ermöglicht Diversifikation auch mit kleinen Beträgen.

Crowdsourcing und Social Trading: Plattformen wie eToro lassen Sie sehen, was erfolgreiche Händler machen – und deren Strategien automatisch kopieren. Wenn ein Profi 10% seines Portfolios in Apple investiert, können Sie mit einem Klick automatisch dasselbe tun (proportional zu Ihrem Kapital). Algorithmischer Handel macht solches "Copy Trading" technisch möglich.

Bildung und Community: Online-Plattformen, YouTube-Kanäle, Podcasts erklären Investmentstrategien, die früher Geheimnisse professioneller Trader waren. Sie können lernen, was Value Investing ist, wie Optionsstrategien funktionieren, wie man Portfolios optimiert – alles kostenlos. Algorithmen helfen dabei, diese Strategien dann auch umzusetzen.

Die andere Seite der Medaille: Demokratisierung hat auch Schattenseiten. Mit leichtem Zugang kommen auch mehr unerfahrene Anleger, die Risiken unterschätzen. Die Gamification mancher Trading-Apps – bunte Konfetti, wenn Sie eine Aktie kaufen – kann gefährliches Verhalten fördern. Der "Robinhood-Effekt" während der Pandemie: Millionen junger Menschen fingen an zu "traden", oft spekulativ, manchmal mit Geld, das sie sich nicht leisten konnten zu verlieren.

Einfacher Zugang bedeutet nicht automatisch bessere Entscheidungen. Manchmal ist das Gegenteil der Fall: Menschen überschätzen sich, handeln zu viel, jagen Trends nach. Die Tools sind demokratisiert, aber Weisheit und Disziplin müssen immer noch selbst erworben werden.

Eine ausgewogenere Sicht: Demokratisierung ist ein echter Fortschritt. Mehr Menschen können an Vermögensbildung teilhaben, können für Altersvorsorge investieren, können von Wirtschaftswachstum profitieren. Aber mit dieser Macht kommt Verantwortung – die Verantwortung, sich zu bilden, Risiken zu verstehen, langfristig zu denken.

Algorithmischer Handel hat die Werkzeuge demokratisiert. Ob wir sie weise nutzen, liegt an uns.

Wir haben nun die Vorteile gesehen – günstigere Kosten, liquidere Märkte, emotionslose Disziplin, demokratisierter Zugang. Das klingt alles sehr positiv. Aber wie bei jeder mächtigen Technologie gibt es auch ernsthafte Risiken und Gefahren. Im nächsten Kapitel schauen wir uns die Schattenseiten an – Flash Crashes, systemische Risiken, Black-Box-Problematik und die neuen Formen von Manipulation, die algorithmischer Handel ermöglicht.

6. Risiken und Gefahren: Die Schattenseiten

Nach all den Vorteilen könnte man denken, algorithmischer Handel sei eine rein positive Entwicklung. Aber wie jede mächtige Technologie hat er auch eine dunkle Seite. Manche Risiken waren vorhersehbar, andere überraschten selbst Experten. Einige haben bereits zu dramatischen Vorfällen geführt, andere lauern als potenzielle Zeitbomben im System. Schauen wir uns die Schattenseiten genauer an.

Flash Crashes: Wenn Märkte in Sekunden abstürzen

- Mai 2010, 14:42 Uhr Eastern Time. An der Wall Street herrscht normaler Handelsbetrieb. Dann, innerhalb von fünf Minuten, stürzt der Dow Jones Industrial Average um fast 1.000 Punkte ab – etwa 9% seines Wertes. Eine Billion Dollar Marktkapitalisierung verschwindet. Manche Aktien fallen auf einen Cent. Andere schießen auf absurde 100.000 Dollar. Chaos.

Dann, ebenso plötzlich, erholt sich der Markt. Nach etwa 20 Minuten sind die meisten Verluste wieder aufgeholt. Aber was war passiert?