Die Ära der Regeln (1950er-1980er): Die KI-Forschung begann mit dem Traum, menschliches Denken in feste "Wenn-Dann"-Regeln zu fassen. Dies führte zu ersten Erfolgen in der Logik und Expertensystemen, scheiterte aber an der Komplexität der realen Welt, was zum "KI-Winter" führte.

Die Ära des Lernens (1990er-2010er): Angetrieben durch mehr Rechenleistung und die Daten des Internets, verlagerte sich der Fokus auf Maschinelles Lernen. KIs wie der Schachcomputer Deep Blue (durch Rechenkraft) und Empfehlungsalgorithmen (durch Mustererkennung) zeigten die neue Macht der datengesteuerten KI.

Die Ära der tiefen Netze (2012-Heute): Der "Urknall" kam 2012 mit AlexNet. Tiefe neuronale Netze bewiesen ihre Überlegenheit in der Mustererkennung. Dies führte zu Durchbrüchen wie AlphaGo und gipfelte 2022 in der "generativen Explosion" mit ChatGPT und Midjourney, die KI für Hunderte von Millionen Menschen direkt erlebbar machte.

Für viele war die Veröffentlichung von ChatGPT im Jahr 2022 der erste Berührungspunkt mit KI. Andere haben es vielleicht sogar erst 2025 mit dem Einbau von MetaAI in WhatsApp, Instagram oder Facebook mitbekommen. Tatsächlich aber gibt es KI nicht erst seit ein paar Jahren: Ihre Geschichte geht bedeutend früher los.

Die heutige KI-Revolution ist kein plötzliches Ereignis, sondern das triumphale Ergebnis von über 70 Jahren Forschung. Es ist eine Geschichte, geprägt von visionären Träumen, von genialen Durchbrüchen, aber auch von bitteren Enttäuschungen und langen, eisigen "KI-Wintern", in denen der Fortschritt stagnierte und die Forschungsgelder versiegten. Es ist die Geschichte eines unbändigen menschlichen Willens, die Essenz unserer eigenen Intelligenz zu verstehen und sie in Silizium nachzubilden.

Phase 1: Das Zeitalter der Logik und des Optimismus (1950er – 1970er)

1956: Die Dartmouth Konferenz – Die Taufe

Stellen Sie sich einen Sommer im Jahr 1956 vor. Die Welt erholt sich noch von den Wunden des Zweiten Weltkriegs, Computer sind riesige, raumfüllende Ungetüme, die mit Lochkarten gefüttert werden, und die Idee einer "denkenden Maschine" ist Stoff für Romane, nicht für die Wissenschaft.

Doch auf dem ruhigen Campus des Dartmouth College in New Hampshire (USA) kam eine kleine Gruppe brillanter junger Wissenschaftler zusammen. Darunter waren Pioniere wie John McCarthy, Marvin Minsky und Claude Shannon. Sie teilten eine radikale und für die damalige Zeit fast schon überhebliche Vision: Ihr Antrag für ihr achtwöchige Forschungsprojekt enthielt einen Satz, der zum Gründungsmythos eines ganzen Feldes werden sollte. Ihre überzeugte Annahme war, dass "jeder Aspekt des Lernens oder jeder andere Wesenszug von Intelligenz prinzipiell so präzise beschrieben werden kann, dass eine Maschine gebaut werden kann, um ihn zu simulieren."

In diesem einen Satz steckt alles: der unerschütterliche Optimismus und der Glaube, dass Kreativität, Sprache und logisches Denken keine mystischen, rein menschlichen Eigenschaften sind, sondern im Grunde informationsverarbeitende Prozesse, die man in Code gießen kann.

Während dieses Sommers prägte John McCarthy den Begriff, der all diese Hoffnungen bündeln sollte: Künstliche Intelligenz. 🤖

Die Dartmouth Konferenz selbst produzierte keine fertige KI. Sie war kein Produkt-Launch. Aber sie tat etwas viel Wichtigeres: Sie gab dem Traum einen Namen, einer losen Gruppe von Forschern eine gemeinsame Identität und einem ganzen Wissenschaftszweig seine Gründungsurkunde. Der Startschuss für die Jagd nach der denkenden Maschine war gefallen. Der Weg dorthin sollte jedoch steiniger und länger werden, als es sich die Pioniere in jenem optimistischen Sommer je hätten vorstellen können.

1960er: Erste Versuche

Beflügelt vom Optimismus der Dartmouth Konferenz begann die erste große Ära der KI-Forschung. Der dominante Ansatz in dieser Zeit war die sogenannte symbolische KI, oft auch als "gute, altmodische KI" (Good Old-Fashioned AI, GOFAI) bezeichnet.

Die zentrale Idee war, dass Intelligenz auf der Manipulation von Symbolen (wie Wörtern oder Zahlen) nach logischen Regeln basiert. Man ging davon aus, dass man einer Maschine das Wissen der Welt wie ein riesiges Regelbuch beibringen könnte. Der Ansatz lautete: Wenn wir nur genug "Wenn-Dann-Regeln" in den Computer einspeisen, wird er irgendwann intelligent.

Computer als Logik-Maschinen

In dieser Phase wurden beeindruckende erste Erfolge erzielt. Programme wurden entwickelt, die komplexe mathematische Theoreme beweisen konnten, geometrische Probleme lösten und einfache Strategiespiele wie Dame meisterten. Für die damalige Zeit waren dies magische Leistungen. Sie schienen den Beweis zu erbringen, dass Maschinen tatsächlich in der Lage waren, Aufgaben zu lösen, die logisches "Denken" erforderten. Die KI-Forscher waren überzeugt, dass sie auf dem richtigen Weg waren und die Schaffung einer allumfassend intelligenten Maschine nur noch eine Frage der Zeit und der Rechenleistung war.

Doch diese regelbasierten Systeme hatten eine fundamentale Schwäche: Sie konnten nur innerhalb ihrer eng gesteckten Grenzen agieren und waren völlig unfähig, mit der chaotischen, unvorhersehbaren und mehrdeutigen realen Welt umzugehen. Für jede neue Situation musste ein menschlicher Experte eine neue Regel schreiben. Das "Lernen" fand nicht in der Maschine statt, sondern im Kopf des Programmierers.

1964: ELIZA – Die Maschine spricht (oder tut so als ob)

Mitten in dieser Ära der starren Logik entwickelte der deutsch-amerikanische Informatiker Joseph Weizenbaum am MIT ein Programm, das die Welt verblüffte und eine bis heute andauernde Debatte auslöste: ELIZA.

ELIZA war der erste Chatbot der Geschichte. Das Programm simulierte eine Psychotherapeutin. Du konntest einen Satz eintippen, und ELIZA antwortete Dir.

- Nutzer: "Ich fühle mich heute traurig."

- ELIZA: "Warum fühlen Sie sich heute traurig?"

- Nutzer: "Mein Vater hasst mich."

- ELIZA: "Erzählen Sie mir mehr über Ihre Familie."

Was auf den ersten Blick wie tiefes Verständnis wirkte, war in Wahrheit ein genial einfacher Trick. ELIZA verstand absolut nichts vom Inhalt des Gesprächs. Das Programm funktionierte nach simplen Regeln: Es scannte die Eingabe des Nutzers nach Schlüsselwörtern (wie "Vater", "traurig") und formulierte den Satz nach einem vordefinierten Muster um, oft in eine offene Gegenfrage.

Der ELIZA-Effekt

Der Effekt war jedoch revolutionär. Weizenbaum war schockiert, als er feststellte, dass viele Nutzer – sogar seine eigene Sekretärin – dem Programm tief persönliche Geheimnisse anvertrauten. Sie wussten, dass es nur eine Maschine war, aber die Illusion eines verständnisvollen Gesprächspartners war so stark, dass sie eine emotionale Verbindung aufbauten.

Dieses Phänomen, die menschliche Neigung, computergestütztem Verhalten unbewusst menschliche Absichten und Gefühle zuzuschreiben, ist heute als "ELIZA-Effekt" bekannt.

ELIZA war ein Meilenstein. Sie war der erste Beweis dafür, wie überzeugend eine Konversations-Simulation sein kann, selbst wenn keinerlei echtes Verständnis dahintersteckt. Sie legte den Grundstein für jeden Chatbot und jeden Sprachassistenten, den wir heute nutzen, und warf gleichzeitig die fundamentale Frage auf: Was bedeutet es wirklich, etwas zu "verstehen"? Eine Frage, die die KI-Forschung bis heute beschäftigt.

1965: Dendral – Der erste Experte

Während ELIZA die Illusion von allgemeinem Verständnis erzeugte, verfolgten andere Forscher ein pragmatischeres Ziel. Anstatt zu versuchen, das gesamte menschliche Denken nachzubilden, konzentrierten sie sich darauf, das hochspezialisierte Wissen eines menschlichen Experten in einem winzigen, klar definierten Fachgebiet zu replizieren.

Das Ergebnis dieser Bemühungen war Dendral, ein bahnbrechendes Programm, das an der Stanford University entwickelt wurde. Dendrals Aufgabe war es, die Struktur unbekannter organischer Moleküle zu identifizieren. Ein menschlicher Chemiker tut dies, indem er die Daten eines Massenspektrometers analysiert – eine komplexe Aufgabe, die jahrelange Erfahrung und tiefes Fachwissen erfordert.

Die Entwickler von Dendral verbrachten unzählige Stunden damit, genau diese menschlichen Experten zu interviewen. Sie extrahierten das Wissen der Chemiker und gossen es in die Form von Hunderten von "Wenn-Dann"-Regeln.

- "WENN das Spektrometer diesen spezifischen Peak anzeigt, DANN deutet das auf das Vorhandensein einer Keton-Gruppe hin."

- "WENN eine Keton-Gruppe vorhanden ist, DANN sind diese und jene Molekülstrukturen wahrscheinlicher."

Dendral war damit das erste Expertensystem der Welt. Es war der Beweis, dass man das analytische Wissen eines Fachmanns erfolgreich in Software übertragen konnte. In seinem engen Spezialgebiet konnte Dendral mit menschlichen Experten mithalten und übertraf sie manchmal sogar in Geschwindigkeit und Genauigkeit. Dieser Erfolg löste eine Welle von Expertensystemen in anderen Bereichen aus – von der medizinischen Diagnose bis zur geologischen Exploration – und zeigte, dass KI auch ohne allgemeines "Bewusstsein" einen enormen praktischen und kommerziellen Wert haben konnte.

1972: Shakey der Roboter – Die KI bekommt einen Körper

Bis in die späten 1960er Jahre existierte KI ausschließlich in der rein digitalen Welt der Großrechner. Sie löste logische Probleme, aber sie konnte nicht mit der physischen Welt interagieren. Das änderte sich mit einem Projekt am Stanford Research Institute, das so wegweisend war, dass sein Ergebnis heute im Computer History Museum steht: Shakey der Roboter.

Shakey war ein klobiger Kasten auf Rädern, ausgestattet mit einer Kamera, Berührungssensoren und einem Computer, der so groß war wie ein Wandschrank. Er war der erste mobile Roboter, der nicht nur blind einem vorprogrammierten Pfad folgte, sondern seine eigene Umgebung wahrnehmen, analysieren und sich darin zurechtfinden konnte. 🤖

Er lebte in einer speziell für ihn gebauten Welt aus großen Bauklötzen und Rampen. Über eine Tastatur konnte man ihm Befehle in einfacher englischer Sprache geben, wie zum Beispiel: "Schiebe den Block vom Tisch."

Um diesen Befehl auszuführen, musste Shakey eine erstaunliche Kette von intelligenten Prozessen durchlaufen:

- Sprachverarbeitung: Zuerst musste er den Satz analysieren und seine Bedeutung verstehen.

- Wahrnehmung: Mit seiner Kamera musste er die Umgebung scannen, um den "Tisch" und den "Block" zu identifizieren (Computer Vision).

- Planung: Er musste einen Plan entwickeln. Zuerst muss er zum Tisch navigieren, dann den Block anvisieren und ihn dann schieben. Dabei musste er Hindernisse umfahren.

- Aktion: Schließlich musste er diesen Plan in konkrete Motorbefehle für seine Räder und seinen Schieber umsetzen.

Shakey war langsam, ungeschickt und zitterte oft (daher sein Name "Shakey", der Zittrige). Aber er war ein fundamentaler Durchbruch. Er war der erste, der die bis dahin getrennten Welten der Robotik, der Computer Vision und der Verarbeitung natürlicher Sprache in einem einzigen, funktionierenden System vereinte. Er war der Urahn jedes selbstfahrenden Autos, jedes Staubsaugerroboters und jedes Mars-Rovers, der heute ferne Welten erkundet. Shakey bewies, dass die Prinzipien der KI aus der digitalen Welt heraus- und in die physische Welt hineingetragen werden konnten.

Phase 2: Der KI-Winter – Die große Ernüchterung (ca. 1974 – 1990er)

Die frühen Erfolge von Programmen wie ELIZA und Dendral hatten eine Goldgräberstimmung erzeugt. Die Forscher hatten vollmundige Versprechen gemacht – von vollautomatischen Übersetzern bis hin zu Maschinen mit menschenähnlicher Intelligenz, alles nur eine Frage weniger Jahre. Regierungen und Unternehmen pumpten riesige Summen in die Forschung.

Doch Mitte der 1970er Jahre machte sich Ernüchterung breit. Die Fortschritte stagnierten. Es wurde schmerzlich klar, dass die anfänglichen Versprechen nicht gehalten werden konnten. Die Folge war ein massiver Vertrauensverlust und die drastische Kürzung von Forschungsgeldern. Eine lange, eisige Periode brach an, die als der erste "KI-Winter" ❄️ in die Geschichte einging.

Der Grund für den Winter: Die Wand der Realität

Die Forscher stießen an zwei fundamentale Mauern, die der regelbasierte Ansatz der symbolischen KI einfach nicht überwinden konnte:

- Die unendliche Komplexität der Welt: Es stellte sich heraus, dass man die reale Welt nicht in ein endliches Set von "Wenn-Dann"-Regeln fassen kann. Man kann einer KI Regeln für das Schachspielen beibringen, aber wie viele Regeln bräuchte man, um ihr das Konzept eines "Stuhls" zu erklären? (Ein Stuhl kann drei oder vier Beine haben, aus Holz oder Metall sein, ein Bürostuhl sieht anders aus als ein Barhocker etc.). Das menschliche "Alltagswissen" ist so riesig und implizit, dass es unmöglich war, es manuell zu programmieren.

- Die Grenzen der Rechenleistung: Selbst die einfachsten Probleme erforderten eine Rechenleistung, die die damaligen Computer bei weitem überstieg. Das Problem explodierte exponentiell. Die KI konnte zwar in einer vereinfachten Welt mit ein paar Bauklötzen navigieren, war aber mit der visuellen Komplexität eines einfachen Fotos völlig überfordert. Sie konnte Schach "spielen", aber kein spielendes Kind auf einem Foto erkennen.

Die KI war in einer Sackgasse. Der Traum schien ausgeträumt, und viele Wissenschaftler wandten sich enttäuscht anderen Feldern zu.

1989: LeNet – Ein Lichtblick in der Dunkelheit

Während der Großteil der KI-Forschung im KI-Winter erstarrt war, arbeitete eine kleine Gruppe von Forschern im Stillen an einem radikal anderen Ansatz, der von der Struktur des menschlichen Gehirns inspiriert war: die künstlichen neuronalen Netze. Statt der Maschine explizite Regeln beizubringen, wollten sie ein System schaffen, das aus Beispielen lernt.

Einer der wichtigsten Pioniere dieser Bewegung war der französische Informatiker Yann LeCun. Im Jahr 1989 entwickelte er bei den Bell Labs ein neuronales Netz namens LeNet-5.

Seine Aufgabe war scheinbar simpel, aber für die damalige Zeit revolutionär: das automatische Lesen von handgeschriebenen Postleitzahlen auf Briefumschlägen. 📬

LeNet wurde nicht mit Regeln darüber programmiert, wie eine "5" oder eine "7" aussieht. Stattdessen wurde es mit Tausenden von Beispielen handgeschriebener Ziffern trainiert. Durch diesen Prozess lernte das Netz von selbst, die entscheidenden visuellen Muster zu erkennen, die eine Ziffer ausmachen, unabhängig von der individuellen Handschrift.

Die Genauigkeit von LeNet war für die damalige Zeit atemberaubend und übertraf alle bisherigen regelbasierten Ansätze. Es war der erste, spektakuläre Beweis dafür, dass dieser neue Ansatz des maschinellen Lernens eine immense praktische Leistungsfähigkeit besaß.

LeNet war ein Lichtblick in der Dunkelheit des KI-Winters. Es legte den fundamentalen Grundstein für die kommende Revolution und die gesamte moderne Computer Vision. Es bewies, dass die Zukunft der KI nicht darin lag, Maschinen zu programmieren, sondern darin, sie zu trainieren. Es sollte jedoch noch über zwei Jahrzehnte dauern, bis die Welt – und vor allem die verfügbare Rechenleistung – bereit war, das volle Potenzial dieser Idee zu entfesseln.

Phase 3: Das Zeitalter des Maschinellen Lernens (1990er – Frühe 2010er)

Nach dem langen KI-Winter begann das Eis langsam zu tauen. Zwei gewaltige technologische Wellen veränderten die Welt und schufen die perfekten Bedingungen für eine Wiedergeburt der Künstlichen Intelligenz:

- Das Mooresche Gesetz in voller Blüte: Die Rechenleistung der Computer wuchs weiterhin exponentiell. Maschinen, die einst ganze Räume füllten, passten nun auf einen Schreibtisch und wurden millionenfach leistungsfähiger.

- Die Geburt des World Wide Web: Das Internet explodierte und erzeugte zum ersten Mal in der Geschichte der Menschheit eine unvorstellbare, stetig wachsende Menge an digitalen Daten – Texte, Bilder, Klicks.

Diese beiden Entwicklungen waren der Treibstoff, den die KI brauchte. Die Forschung verlagerte ihren Fokus endgültig weg von den starren, handgeschriebenen Regeln der symbolischen KI hin zum maschinellen Lernen. Die neue Devise lautete: Gib der Maschine genug Rechenleistung und genug Daten, und sie wird die Muster von selbst finden.

1997: Deep Blue besiegt Kasparov – Der "Brute Force"-Triumph

Im Mai 1997 fand in New York ein Ereignis statt, das weltweit für Schlagzeilen sorgte und die Fantasie von Millionen von Menschen beflügelte: Ein Supercomputer von IBM namens Deep Blue trat in einem Sechs-Partien-Match gegen den unangefochtenen Schachweltmeister Garri Kasparow an – und gewann. ♟️

Es war ein ikonischer Moment: Der Mensch, Symbol für Intuition und kreative Strategie, wurde in seinem eigenen intellektuellen Spiel von einer Maschine besiegt. Für die Weltöffentlichkeit war dies der ultimative Beweis, dass Künstliche Intelligenz nun "intelligent" geworden war.

Ein Sieg der Rechenkraft, nicht der Einsicht

Technisch gesehen war Deep Blues Sieg jedoch weniger ein Triumph einer menschenähnlichen "Intelligenz" als vielmehr ein atemberaubender Sieg der rohen Rechenleistung, einer Methode, die man auch "Brute Force" (rohe Gewalt) nennt.

Deep Blue "dachte" nicht wie Kasparow. Es besaß keine Intuition oder ein tiefes Verständnis für die Schönheit einer Schachstellung. Stattdessen war es eine hochspezialisierte Rechenmaschine, die in der Lage war, 200 Millionen Schachpositionen pro Sekunde zu analysieren. Sie konnte für jeden möglichen Zug viele Runden im Voraus alle denkbaren Gegenzüge durchrechnen und den Pfad wählen, der statistisch zur besten Endposition führte.

Kasparow beschrieb es später so, als würde er gegen eine "Wand" spielen. Er konnte die Maschine nicht durch psychologische Tricks oder unkonventionelle Züge aus der Fassung bringen, weil sie keine Fassung hatte. Sie rechnete einfach weiter.

Ein Wendepunkt in der öffentlichen Wahrnehmung

Auch wenn Deep Blue eher ein mathematischer Muskelprotz als ein subtiler Denker war, war sein Sieg ein entscheidender Meilenstein.

- Er katapultierte das Thema Künstliche Intelligenz aus den Forschungslaboren ins Rampenlicht der Weltöffentlichkeit.

- Er bewies, dass Maschinen in hochkomplexen, strategischen Domänen, die lange als rein menschlich galten, überlegen sein können.

- Er befeuerte die Investitionen in die KI-Forschung erneut und half dabei, den langen KI-Winter endgültig zu beenden.

Der Sieg von Deep Blue war symbolisch. Er schloss das Kapitel der klassischen, regelbasierten Spiel-KIs ab und zeigte gleichzeitig, was mit exponentiell wachsender Computerleistung möglich war. Der Weg war nun frei für die nächste, noch tiefgreifendere Revolution – eine, die nicht auf schierer Rechenkraft, sondern auf echtem Lernen basieren sollte.

2004: Die Mars-Rover Spirit & Opportunity – Autonomie in einer anderen Welt

Im Januar 2004 landeten zwei Roboter von der Größe eines Golfcarts auf dem Mars: Spirit und Opportunity. Ihre Mission war es, die Oberfläche des Roten Planeten zu erkunden, Gesteinsproben zu analysieren und nach Spuren von vergangenem Wasser zu suchen. Doch diese Mission stand vor einer fundamentalen Herausforderung: der unvorstellbaren Entfernung.

Ein Funksignal von der Erde zum Mars benötigt je nach Planetenkonstellation zwischen 4 und 24 Minuten – für eine einzelne Strecke. Eine Echtzeit-Steuerung der Rover per Joystick war also unmöglich. Man konnte dem Rover nicht sagen "Fahre 5 Meter vor und stoppe", denn bis das Stopp-Signal ankäme, wäre der Rover längst in einen Felsen gekracht.

Die Lösung war autonome Navigation, angetrieben durch eine Bord-KI. 🛰️

Der Roboter als eigenständiger Entdecker

Die Ingenieure der NASA gaben den Rovern nur übergeordnete Ziele, zum Beispiel: "Fahre zu diesem interessanten Felsen am Horizont." Den Weg dorthin musste der Roboter selbstständig finden.

- Wahrnehmung: Mit seinen Stereokameras erstellte der Rover eine 3D-Karte seiner unmittelbaren Umgebung.

- Analyse: Die KI-Software an Bord analysierte diese Karte, identifizierte Hindernisse wie Felsen oder steile Abhänge und bewertete, welche Routen sicher und befahrbar waren.

- Entscheidung und Aktion: Basierend auf dieser Analyse traf der Rover autonome Entscheidungen. Er plante eine sichere Route für die nächsten paar Meter, fuhr diese Strecke, blieb stehen, erstellte eine neue Karte und wiederholte den Prozess.

Diese Rover waren ein triumphaler Beweis für die praktische Anwendung von KI in einer der extremsten und unvorhersehbarsten Umgebungen, die man sich vorstellen kann. Sie trafen eigenständige Entscheidungen, um wissenschaftliche Ziele zu erreichen und sich selbst zu schützen, Millionen von Kilometern von ihren menschlichen Schöpfern entfernt. Die ursprünglich auf 90 Tage ausgelegte Mission von Opportunity dauerte am Ende fast 15 Jahre – ein Testament für die Robustheit und Intelligenz ihres autonomen Systems.

2011: Der Empfehlungs-Algorithmus – KI wird unsichtbar und allgegenwärtig

Während die Mars-Rover ferne Welten erkundeten, begann auf der Erde eine leisere, aber nicht weniger tiefgreifende KI-Revolution. Sie fand nicht in Laboren oder auf anderen Planeten statt, sondern direkt auf unseren Bildschirmen. Plattformen wie YouTube, Netflix und Amazon begannen, maschinelles Lernen in großem Stil einzusetzen, um ein zentrales Problem des digitalen Zeitalters zu lösen: die Qual der Wahl.

In einer Welt mit Millionen von Videos, Filmen und Produkten ist es für einen Menschen unmöglich, den Überblick zu behalten. Hier kamen die Empfehlungsalgorithmen (Recommendation Engines) ins Spiel.

Die KI als persönlicher Kurator

Diese Systeme lernten nicht aus physikalischen Regeln, sondern aus dem Verhalten von Millionen von Nutzern.

- Daten sammeln: Der Algorithmus beobachtete jede Deiner Interaktionen: Welches Video schaust Du Dir an? Welchen Film bewertest Du gut? Welches Produkt legst Du in den Warenkorb?

- Muster erkennen: Er analysierte diese Daten und verglich sie mit den Daten von Millionen anderer Nutzer. Dabei entdeckte er Muster, die oft auf dem Prinzip des kollaborativen Filterns basierten: "Menschen, die Film A mochten, mochten mit hoher Wahrscheinlichkeit auch Film B."

- Vorhersagen treffen: Basierend auf diesen Mustern traf die KI eine Vorhersage darüber, was Dir als Nächstes gefallen könnte, und personalisierte Deine Startseite.

Dieser Meilenstein war aus zwei Gründen entscheidend:

- KI wurde unsichtbar: Zum ersten Mal interagierten hunderte Millionen von Menschen täglich mit einer hochentwickelten KI, oft ohne es überhaupt zu wissen. KI war keine bewusste Erfahrung mehr, sondern wurde zur unsichtbaren Architektur unserer digitalen Umgebung.

- KI wurde zum Geschäftsmodell: Personalisierung wurde zum entscheidenden Faktor für den Erfolg von Online-Plattformen. Eine gute Empfehlungs-KI bindet Nutzer länger an die Seite, steigert die Zufriedenheit und treibt den Konsum an.

Die Ära der Empfehlungsalgorithmen markierte den Punkt, an dem maschinelles Lernen endgültig aus der Forschung in den Mainstream überging und zu einem der mächtigsten und profitabelsten Werkzeuge der digitalen Wirtschaft wurde.

Phase 4: Die Deep-Learning-Revolution (2012 – Heute)

Die 2010er Jahre begannen. Das Internet war allgegenwärtig, soziale Medien explodierten, und die Menge an digitalen Daten wuchs ins Unermessliche. Gleichzeitig waren Grafikkarten (GPUs), angetrieben von der boomenden Videospiel-Industrie, zu unglaublich leistungsfähigen Parallel-Rechenmonstern herangewachsen.

Die Zutaten für eine Revolution waren angerichtet: riesige Datenmengen (das Futter) und massive Rechenleistung (der Motor). Es fehlte nur noch das richtige Rezept. Und dieses Rezept war die Idee der tiefen neuronalen Netze, die seit den Tagen von LeNet in den Laboren schlummerte und nun endlich bereit war, ihr volles Potenzial zu entfalten.

Das Zeitalter des Deep Learning begann. Und es begann mit einem Urknall.

2012: AlexNet gewinnt den ImageNet-Wettbewerb – Der "Big Bang" der modernen KI

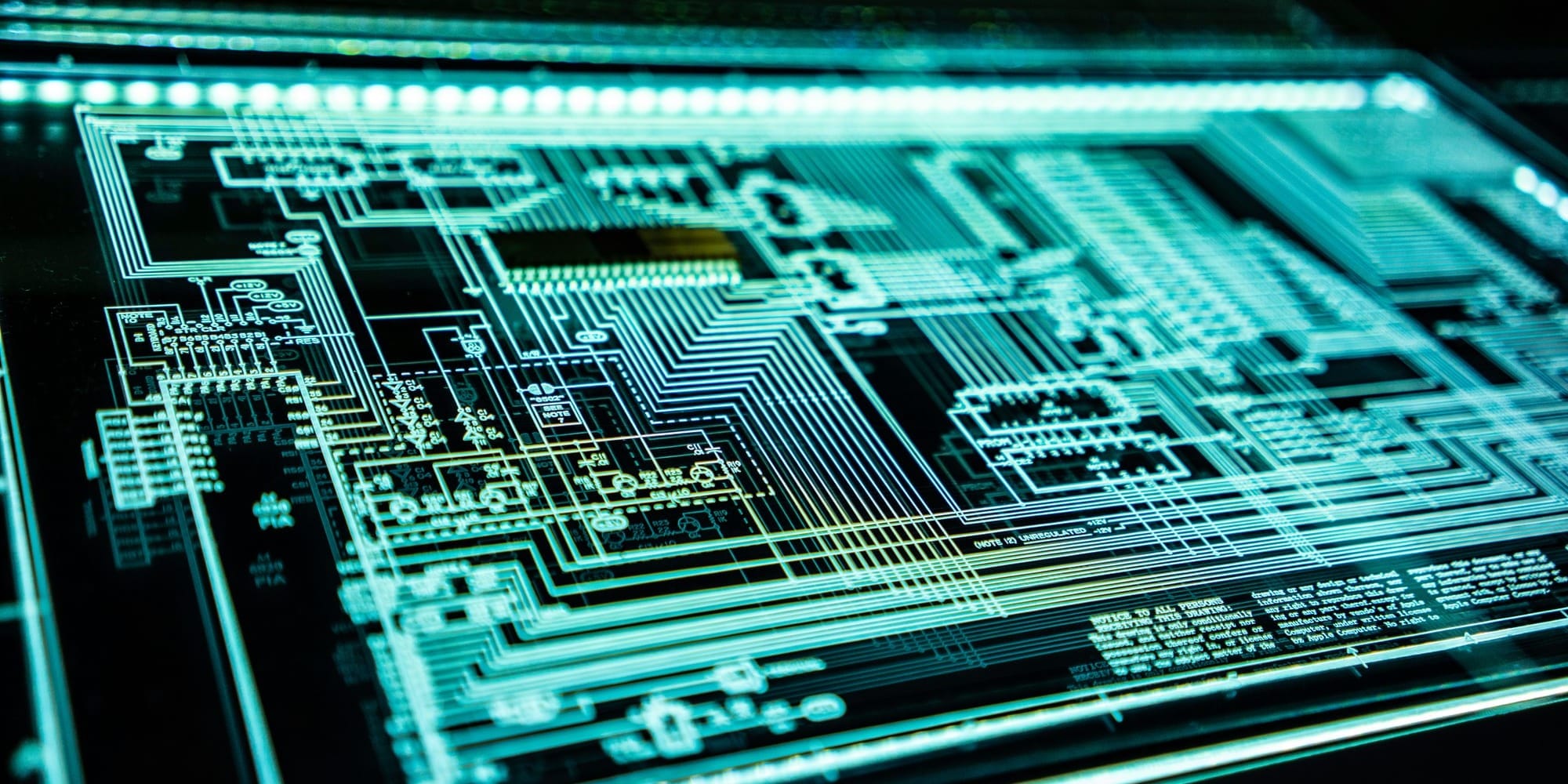

Jedes Jahr trafen sich die weltweit führenden Forscher im Bereich Computer Vision zum "ImageNet Large Scale Visual Recognition Challenge". Der Wettbewerb war eine Art Olympiade für KI-Systeme. Die Aufgabe: Eine Software sollte in über einer Million Bildern tausend verschiedene Objekte korrekt erkennen – von Hunderassen über Autos bis hin zu Pilzarten.

Jahrelang hatten die besten Systeme eine Fehlerquote von etwa 25-30 %. Sie waren gut, aber weit von menschlicher Perfektion entfernt.

Doch im Jahr 2012 passierte etwas Unerwartetes. Ein Team um den KI-Pionier Geoffrey Hinton von der University of Toronto reichte ein Modell namens AlexNet ein. AlexNet basierte nicht auf den traditionellen Methoden, sondern war ein tiefes, mehrschichtiges neuronales Netz, das auf leistungsstarken GPUs trainiert wurde.

Die Deklassierung der Konkurrenz

Das Ergebnis war ein Schock für die gesamte Fachwelt. AlexNet gewann den Wettbewerb nicht nur, es deklassierte die Konkurrenz. Es erreichte eine Fehlerquote von nur 15,3 %. Der Zweitplatzierte lag bei über 26 %. Es war kein knapper Sieg, es war eine Machtdemonstration.

AlexNet war der unwiderlegbare Beweis, dass tiefe neuronale Netze, trainiert auf großen Datenmengen mit der richtigen Hardware, allen anderen Ansätzen zur Mustererkennung haushoch überlegen waren.

Warum war das der Urknall?

- Der Paradigmenwechsel war vollzogen: Nach diesem Tag war die Debatte beendet. Die gesamte KI-Forschung stürzte sich auf Deep Learning. Es war, als hätte jemand bewiesen, dass Dampfmaschinen allen anderen Antriebsarten überlegen sind.

- Die Hardware-Revolution wurde gezündet: Unternehmen wie NVIDIA erkannten, dass ihre GPUs nicht nur für Gamer, sondern für die wichtigste technologische Revolution des 21. Jahrhunderts entscheidend waren. Eine neue Industrie für KI-Hardware wurde geboren.

- Die Tore wurden aufgestoßen: Der Erfolg von AlexNet bei der Bilderkennung war der Startschuss für eine unglaubliche Serie von Durchbrüchen in anderen Bereichen. Die Forscher erkannten: Wenn dieses Prinzip bei Bildern funktioniert, funktioniert es vielleicht auch bei Sprache, bei Tönen, bei medizinischen Daten.

Der Sieg von AlexNet im Jahr 2012 war der Funke, der das Feuer der modernen KI-Revolution entfachte. Alles, was wir heute mit Staunen beobachten – von ChatGPT bis hin zu selbstfahrenden Autos – hat seine direkten Wurzeln in diesem einen, entscheidenden Moment. Die Ära der tiefen neuronalen Netze hatte begonnen, und sie sollte die Welt in einem Tempo verändern, das selbst die kühnsten Pioniere von Dartmouth nicht für möglich gehalten hätten.

2014: Facebooks DeepFace – Wenn die Maschine Gesichter erkennt

Der Damm, den AlexNet 2012 gebrochen hatte, löste eine Flut von Innovationen aus. Forscher und Tech-Giganten erkannten, dass die Kombination aus tiefen neuronalen Netzen, großen Datensätzen und GPU-Power das Erfolgsrezept war. Einer der ersten Bereiche, in dem dies zu atemberaubenden Ergebnissen führte, war die Gesichtserkennung.

Im Jahr 2014 stellte Facebook sein System DeepFace vor. Die Aufgabe: festzustellen, ob zwei verschiedene Fotos dieselbe Person zeigen. DeepFace wurde mit einer riesigen Datenbank von vier Millionen Gesichtsbildern von Facebook-Nutzern trainiert.

Das Ergebnis war ein weiterer Meilenstein: DeepFace erreichte eine Genauigkeit von 97,35 %. Zum Vergleich: Die durchschnittliche Genauigkeit eines Menschen bei derselben Aufgabe liegt bei etwa 97,5 %. Die Maschine hatte in dieser spezifischen visuellen Aufgabe quasi menschliches Niveau erreicht. 👱

Die Konsequenzen waren unmittelbar und weitreichend:

Plötzlich war es möglich, automatisch Personen auf Fotos zu "taggen", Smartphones per Gesicht zu entsperren oder große Menschenmengen nach bestimmten Personen zu durchsuchen. Der Durchbruch bei der Gesichtserkennung war eine direkte Folge der Deep-Learning-Revolution. Er zeigte, wie schnell eine ehemals als extrem schwierig geltende Aufgabe der Computer Vision gelöst werden konnte. Gleichzeitig läutete er aber auch die bis heute andauernde, hitzige Debatte über die ethischen Implikationen von Überwachungstechnologien und den Schutz der Privatsphäre ein.

2016: AlphaGo besiegt Lee Sedol – Der Triumph der "Intuition"

Während DeepFace bewies, dass KI die Welt "sehen" konnte, sollte ein anderes Ereignis beweisen, dass sie auch auf eine Weise "denken" konnte, die bisher als unmöglich galt. Die nächste große Bastion menschlicher intellektueller Dominanz war das uralte Brettspiel Go.

Anders als Schach, das bereits 1997 von Deep Blue durch schiere Rechenkraft geknackt worden war, ist Go ungleich komplexer. Die riesige Anzahl an möglichen Zügen macht eine "Brute-Force"-Suche unmöglich. Go erfordert, so die allgemeine Überzeugung, ein tiefes, intuitives Verständnis für Strategie, eine Art menschliches Bauchgefühl. Viele Experten schätzten, dass es noch mindestens ein Jahrzehnt dauern würde, bis eine KI einen menschlichen Weltmeister besiegen könnte.

Sie irrten sich gewaltig.

Im März 2016 trat AlphaGo, eine von DeepMind (Google) entwickelte KI, gegen den südkoreanischen Go-Legende Lee Sedol an. Die Welt erwartete einen klaren Sieg für den Menschen. Stattdessen erlebte sie eine Demonstration einer neuen Form von Intelligenz.

AlphaGo gewann das Match mit 4:1. Aber es war die Art, wie es gewann, die die Welt in Staunen versetzte. AlphaGo basierte auf Deep Reinforcement Learning. Es hatte nicht nur aus menschlichen Partien gelernt, sondern vor allem durch Millionen von Partien gegen sich selbst. Dabei entwickelte es eine Art übermenschliche Intuition.

Der berühmte "Zug 37" in der zweiten Partie war ein Zug, den kein menschlicher Meister je gespielt hätte. Er wirkte bizarr, falsch, fast schon amateurhaft. Doch er war der Schlüssel zum Sieg und offenbarte eine tiefere strategische Wahrheit des Spiels, die Menschen in 3.000 Jahren nicht entdeckt hatten.

Der Sieg von AlphaGo war ein viel tiefgreifenderer Meilenstein als der von Deep Blue. Er bewies, dass KI nicht nur rechnen, sondern durch selbstständiges Lernen Strategien entwickeln kann, die menschliche Kreativität und Intuition übertreffen. Es war der Moment, in dem die KI begann, uns nicht nur zu imitieren, sondern uns neue Wege aufzuzeigen.

2018: AlphaZero – Lernen aus dem Nichts

Nach dem triumphalen Sieg von AlphaGo stellten sich die Forscher bei DeepMind eine noch radikalere Frage: Braucht eine KI überhaupt menschliches Wissen, um ein Spiel zu meistern? Oder kann sie alles, was wir wissen – und mehr –, völlig allein entdecken?

Die Antwort war AlphaZero, und sie war ein weiterer Paukenschlag.

Im Gegensatz zu seinem Vorgänger AlphaGo, der anfangs noch mit einer Datenbank menschlicher Profi-Partien "gefüttert" wurde, erhielt AlphaZero absolut kein menschliches Wissen. Man gab ihm nur die reinen Spielregeln von Schach, Go und Shogi. Das war alles. Es bekam kein Eröffnungsbuch, keine Endspieldatenbank, keine einzige von Menschen gespielte Partie. Sein einziges Lerninstrument war das Deep Reinforcement Learning durch Selbstspiel.

Das Ergebnis war schwindelerregend:

- Innerhalb von nur 4 Stunden lernte AlphaZero Schach auf einem Niveau, das ausreichte, um das weltbeste Schachprogramm der damaligen Zeit, Stockfish, vernichtend zu schlagen.

- Innerhalb von 9 Stunden meisterte es Go und übertraf die Version von AlphaGo, die Lee Sedol besiegt hatte.

Noch erstaunlicher war der Stil, den AlphaZero entwickelte. Im Schach spielte es ein dynamisches, aggressives und oft "unmenschliches" Spiel, das Kommentatoren als außerirdisch schön beschrieben. Es opferte Figuren auf eine Weise, die menschliche Großmeister für riskant oder falsch halten würden, um langfristige strategische Vorteile zu erlangen.

AlphaZero war der ultimative Beweis für echtes, selbstständiges maschinelles Lernen. Es zeigte, dass eine KI, ausgestattet nur mit den Grundregeln und einem klaren Ziel (das Spiel zu gewinnen), in der Lage ist, das gesamte Wissen einer Disziplin, das Menschen über Jahrhunderte angesammelt haben, in wenigen Stunden neu zu entdecken und sogar zu übertreffen. Es war, als hätte man einen Neandertaler in einen verschlossenen Raum mit den Gesetzen der Physik gesteckt und er wäre am nächsten Tag als Albert Einstein wieder herausgekommen.

2022: Die generative Explosion – Die KI wird kreativ

Während AlphaZero die Perfektion des analytischen Denkens demonstrierte, brodelte an einer anderen Front der KI-Forschung eine Revolution, die bald die ganze Welt erfassen sollte. Der Fokus verlagerte sich von der Analyse bestehender Daten hin zur Kreation völlig neuer Inhalte.

Die technologische Grundlage dafür war die Transformer-Architektur, eine bahnbrechende Entwicklung, die es ermöglichte, Large Language Models (LLMs) von nie dagewesener Größe und Leistungsfähigkeit zu trainieren.

Ende 2022 öffneten sich die Schleusen. Innerhalb weniger Wochen und Monate wurden mehrere Systeme für die breite Öffentlichkeit zugänglich gemacht, die alles Bisherige in den Schatten stellten:

- Bildgeneratoren wie Midjourney, DALL-E und Stable Diffusion ermöglichten es jedem, durch eine einfache Texteingabe atemberaubende, fotorealistische oder künstlerische Bilder zu erschaffen.

- ChatGPT von OpenAI, ein auf Konversation spezialisiertes LLM, wurde zu einem globalen Phänomen. Millionen von Menschen interagierten zum ersten Mal direkt mit einer KI, die Gedichte schreiben, Code programmieren, komplexe Fragen beantworten und menschenähnliche Dialoge führen konnte.

Der Wendepunkt zur Alltags-KI

Dieser Moment war anders als alle Meilensteine zuvor. Es ging nicht mehr um einen Supercomputer, der einen Großmeister besiegt, oder um einen Roboter auf dem Mars. Zum ersten Mal wurde die immense Macht der modernen KI für Hunderte von Millionen von Menschen direkt erlebbar und nutzbar. 🚀

Die generative Explosion markiert den Übergang der KI von einem spezialisierten Werkzeug für Experten zu einer universellen Technologie für die Allgemeinheit. Sie hat die öffentliche Wahrnehmung und die Diskussion über die Möglichkeiten und Risiken von Künstlicher Intelligenz für immer verändert. Es ist der Beginn der Ära, in der wir heute leben – eine Ära, in der die Grenzen zwischen menschlicher und maschineller Kreativität täglich neu verhandelt werden.

Fazit: Auf den Schultern von Giganten

Die scheinbar über Nacht erschienene Revolution der künstlichen Intelligenz ist in Wahrheit das Ergebnis einer langen, oft mühsamen Evolution. Die heutigen kreativen Superhirne stehen auf den Schultern von Giganten: auf den Träumen der Pioniere von Dartmouth, auf den logischen Maschinen der ersten Ära, auf den fehlgeschlagenen Versprechungen, die zum KI-Winter führten, und auf den stillen Durchbrüchen der Forscher, die auch in der Dunkelheit an die Kraft der neuronalen Netze glaubten.

Die Geschichte der KI ist eine Geschichte des exponentiellen Fortschritts. Jede Welle baute auf der vorherigen auf, angetrieben von den unaufhaltsamen Kräften des Mooreschen Gesetzes und der globalen Datenexplosion. Vom ersten, regelbasierten Chatbot ELIZA, der nur die Illusion von Verständnis erzeugte, bis zu ChatGPT, das auf einem tiefen, statistischen Verständnis von Sprache beruht, liegt eine Welt.

Diese Reise ist noch lange nicht zu Ende. Wir befinden uns gerade erst am Anfang der aufregendsten Phase – einer Ära, in der die KI beginnt, nicht nur unsere Muster zu lernen, sondern uns dabei zu helfen, völlig neue zu entdecken. Die Geschichte hat uns gezeigt, dass nach jedem Durchbruch und nach jedem Winter ein neuer, noch aufregenderer Frühling kam. Und der Frühling, in dem wir uns gerade befinden, verspricht, der bisher spektakulärste von allen zu werden.

Weiterführende Fragen

Was war der "KI-Winter" und warum ist er wichtig?

Der "KI-Winter" war eine Periode (hauptsächlich in den späten 1970ern und 1980ern), in der die KI-Forschung stagnierte, weil die versprochenen Durchbrüche ausblieben. Dies führte zu massiven Kürzungen von Forschungsgeldern. Er ist wichtig, weil er zeigt, dass die KI-Entwicklung nicht linear verläuft, sondern aus Zyklen von Hype, Enttäuschung und anschließenden, oft auf neuen Ideen basierenden Durchbrüchen besteht.

Was war der größte Unterschied zwischen dem Sieg von Deep Blue (Schach) und AlphaGo (Go)?

Der Sieg von Deep Blue (1997) war hauptsächlich ein Triumph der rohen Rechenkraft. Der Computer konnte Millionen von Zügen pro Sekunde durchrechnen. Der Sieg von AlphaGo (2016) war ein Triumph des maschinellen Lernens. Die KI gewann nicht nur durch Rechnen, sondern weil sie durch Deep Reinforcement Learning eine Art übermenschliche Intuition und völlig neue Strategien für das Spiel entwickelt hatte.

Warum ist das Jahr 2012 mit AlexNet so ein entscheidender Wendepunkt?

Weil AlexNet mit seinem Sieg beim ImageNet-Wettbewerb unwiderlegbar bewies, dass Deep Learning (tiefe neuronale Netze), trainiert auf großen Datenmengen mit GPUs, allen anderen Methoden der Mustererkennung überlegen ist. Dieser "Urknall" beendete die Debatte über den richtigen Ansatz und löste die massive Welle an Investitionen und Forschungsdurchbrüchen aus, die direkt zur heutigen KI-Revolution geführt hat.

Jetzt kostenlos abonnieren und immer auf dem Neuesten bleiben. 🚀